航空工业是衡量一个国家在技术、经济及国防实力等方面水平的重要指标。装配是产品制造至关重要的环节,它直接影响着制造成本、生产效率。据统计,装配环节大约占据了整个制造流程中一半时间和1/3 成本。航空装备的零部件种类繁多、形态各异、尺寸不一,装配要求各不相同,作业精度要求高而空间狭小[1–2],这给装配中的测量任务带来了巨大挑战。传统的三坐标等接触式测量方法效率低、易划伤工件表面[3]。现代航空工业备对于空气动力学外形精度以及部件之间位置的要求日益严格,这不仅增加了装配工作的复杂性和工作量,还对装配技术提出了更加严苛的要求。

机器视觉是一种非接触式光学传感技术,能够自动从捕捉到的图像中提取信息或触发控制动作,利用计算机模仿人类视觉功能,从单个或一系列图像中获取并处理信息,理解和应用这些信息于检测、测量及控制等任务中[4–5],具有效率精度高与测量无接触等优势。在航空产品装配过程中,利用机器视觉技术可以实现对机器人的伺服控制、对构件与产品的高精度的测量与检测[6–7]。

本文探讨了机器视觉技术在航空装配中测量、引导、检测3 个方面的应用现状,重点关注点云配准、视觉伺服等关键技术,并给出了未来发展趋势。

1 视觉测量

视觉测量利用传感器采集测量图像,根据图像信息与物方空间内几何信息间的映射关系实现测量,在航空装配过程中发挥着关键作用,尤其是大部件装配位姿测量、大型构件装配外形测量及钻铆孔的视觉测量这3 个核心领域。位姿测量通过捕捉组件的三维空间信息来保证其在装配流程中的精准对准与定位,从而大幅提高了自动化装配的准确性和效率。在装配中,提升外形测量的水平则关系到产品最终的质量;对制造工艺,如钻孔过程中,位置测量技术可以提供孔位的精确定位,孔的垂直度、尺寸等测量结果能评估孔的质量。

1.1 大部件装配位姿测量

位姿检测系统用于装配作业实时定位测量,建立地面坐标系与对接部件坐标系的关系,是实现自动对接的基础。非接触式位姿测量可以在较大范围内对被跟踪物体进行实时测量,计算机视觉成本较低,具有较强的适应性[8]。视觉位姿测量利用图像信息和相机成像模型来获取目标的位姿信息,通过特征点匹配和图像配准技术分析和对比参考图像与当前图像,以确定相机当前位置与期望位置间的差异,常用的具体算法有单应性矩阵计算与分解[9–10]及本质矩阵分解[11]等。

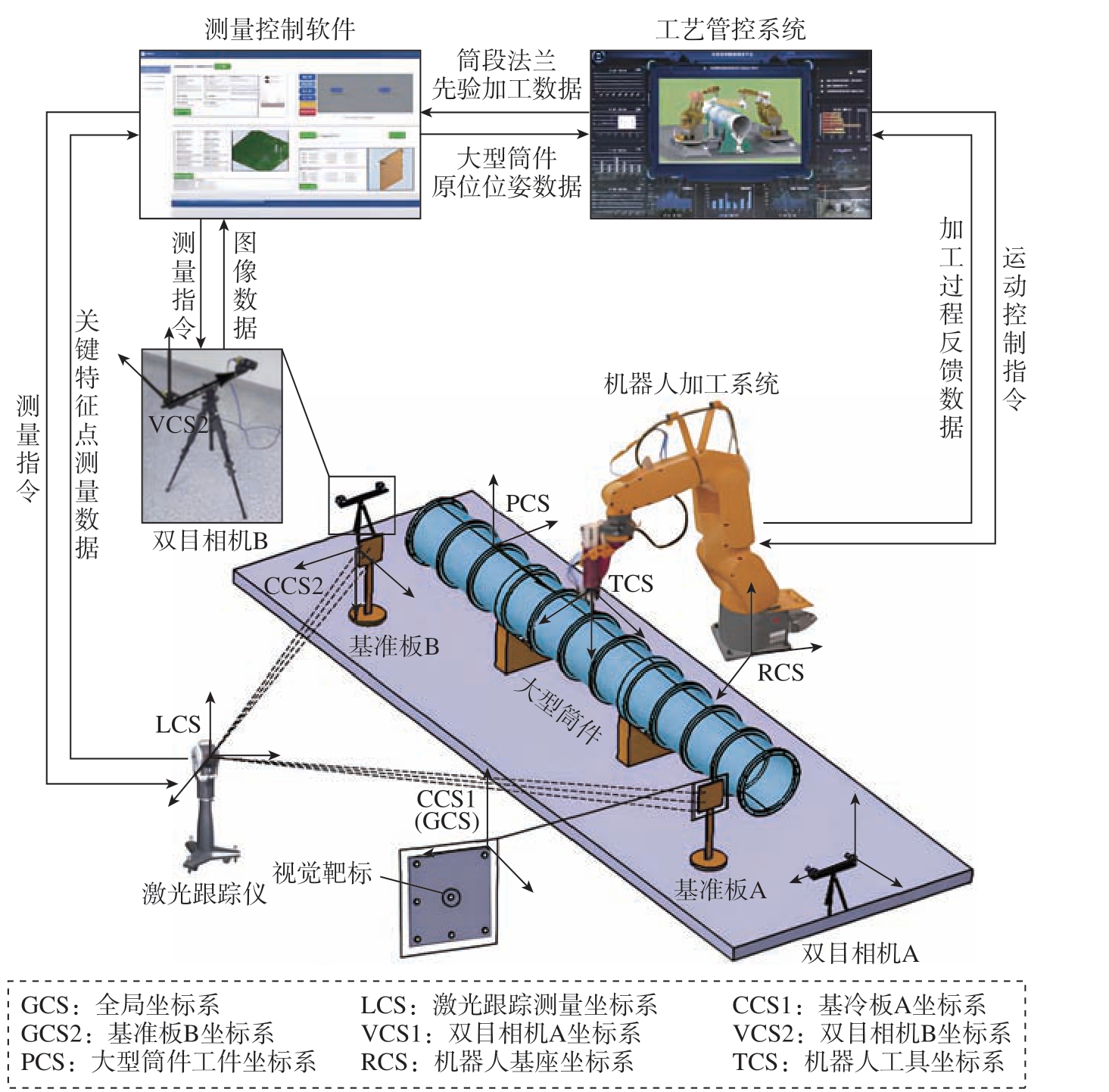

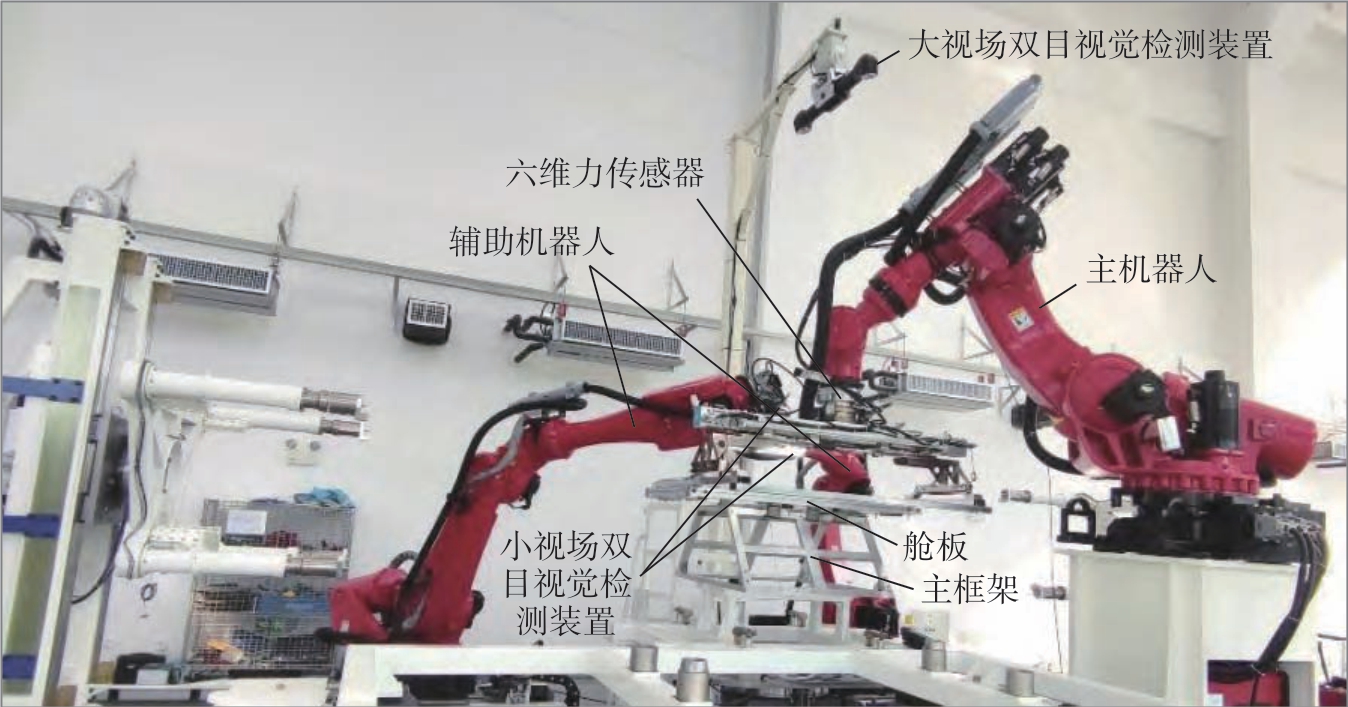

单纯依靠图像处理获取三维信息,特别是姿态信息,需要对单目视觉在多个视点或双目视觉拍摄的图像进行特征匹配,匹配误差会显著影响测量结果。马大智等[12] 提出了一种基于双目视觉配合工业机器人的测量系统,完成了大型高反光构件的原位高效高精度测量。采用不同传感器,通过特定技术手段将信息融合,实现信息间优劣互补,可以提高位姿测量的精度和稳定性,使位姿测量系统更为可靠。如图1 所示,郑联语等[13]将双目视觉、激光跟踪仪与先验数据结合,先进行关键特征的识别与定位,再根据双目视觉三维重构方法对求解大型筒件关键特征中心位置进行空间坐标,最后引入先验数据得到位姿测量结果。陈冠宇等[14]提出了一种基于激光轮廓传感器和CCD 图像传感器等多传感器协同测量的舱段六自由度位姿估计和调整方法,结合了激光轮廓传感器的可靠性和机器视觉的灵活性,有效提高了自动对接系统的效率、稳定性和一致性。

图1 大型筒件安装面机器人加工工艺系统[13]

Fig.1 Robotic processing technology system for large cylinder mounting surfaces[13]

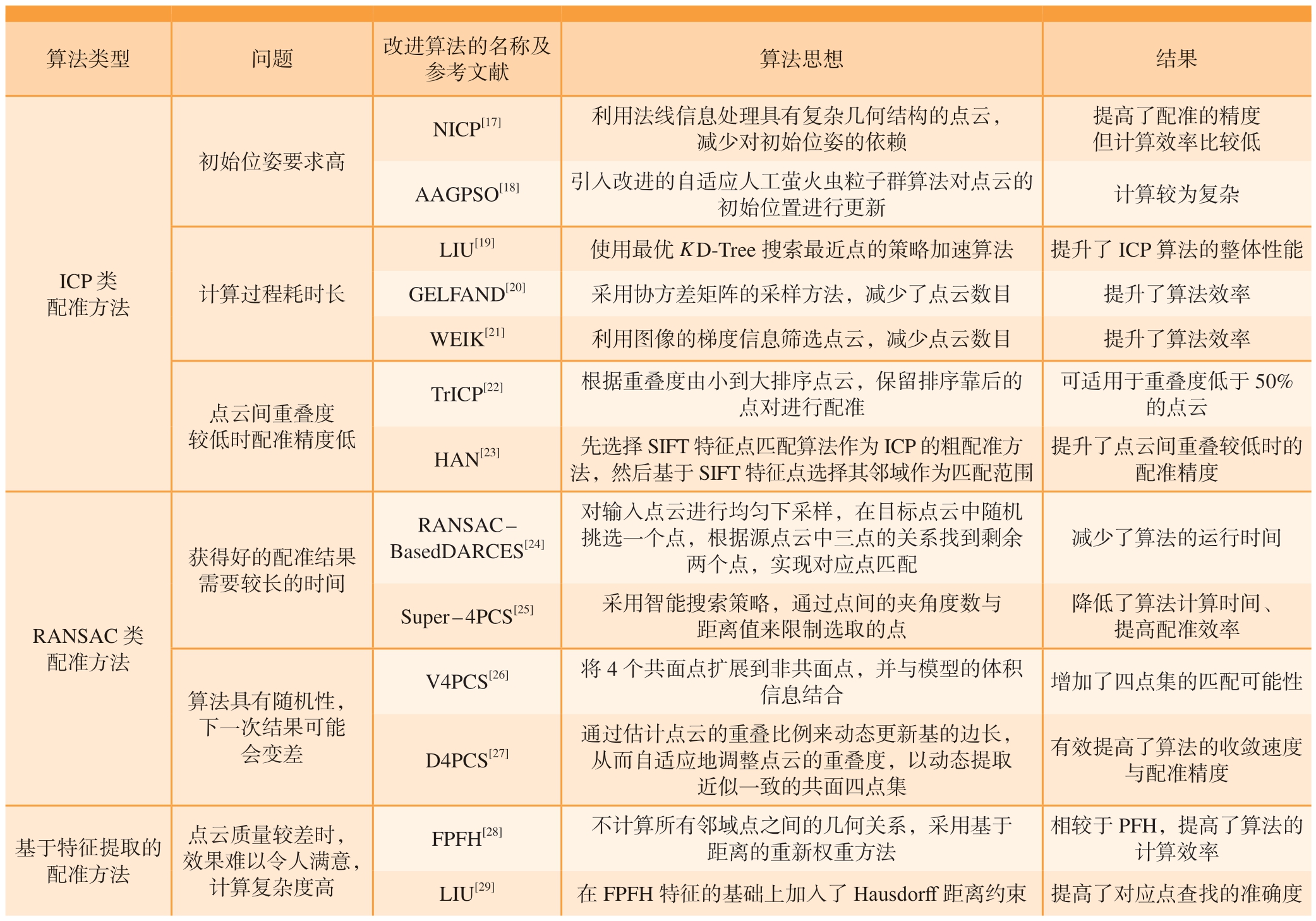

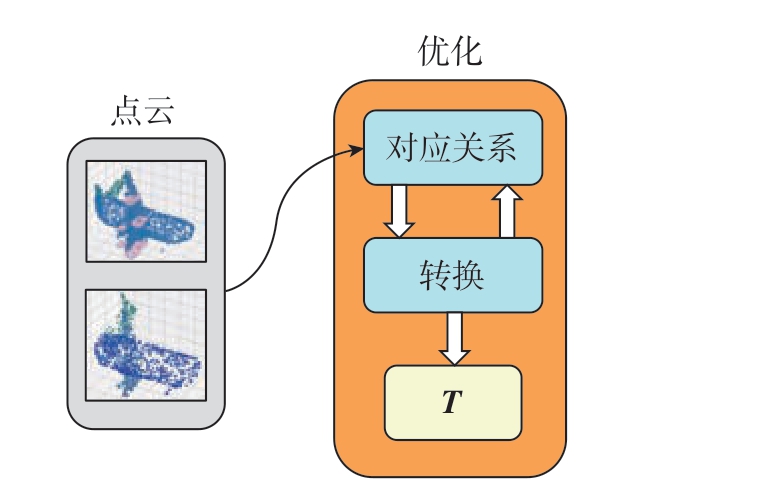

将实际测量的 3D 点云数据与已知的 CAD 模型进行匹配,可以实现高精度的位姿检测。基于已知的 CAD 模型配准方法可以分为传统优化方法 (包括ICP 配准方法、基于 RANSAC 的配准方法和基于特征提取的配准方法)和基于学习的方法 (包括特征学习方法与端到端学习方法)。传统优化方法包括图2 所示的两个阶段: (1)将对应点进行匹配; (2)估计旋转平移变换矩阵T。ICP 配准方法[15]通过寻求2 个待配准点云之间的最近邻点求解变换矩阵,具有配准精度高的优势,但初始位姿要求高、计算过程耗时长、点云间重叠度较低时配准精度低。基于RANSAC 的配准方法[16]通过随机选取两点云中的几个点作为对应点来进行点云配准,经过多次重复选择最好的配准结果作为所要的变换矩阵,该方法不需要好的初始条件,但缺点是具有随机性、耗时长。基于特征提取的配准方法通过提取点云中点的特征,来找寻两点云间相似的点,从而实现点云的配准,它的初始条件要求低、速度快、面对复杂形状点云也能取得好结果。但是针对质量差的、部分可见的点,该方法云配准效果不好。如表1 所示,针对这些问题,研究者做出了一系列改进,发展出了ICP 类配准方法[17–23]、RANSAC 类配准方法[24–27]、基于特征提取的配准方法[28–29]三大类方法。

表1 传统优化方法类型总结

Table 1 Summary of traditional optimization methods

算法类型 问题 改进算法的名称及参考文献 算法思想 结果提高了配准的精度但计算效率比较低AAGPSO[18] 引入改进的自适应人工萤火虫粒子群算法对点云的初始位置进行更新 计算较为复杂初始位姿要求高NICP[17] 利用法线信息处理具有复杂几何结构的点云,减少对初始位姿的依赖ICP 类配准方法计算过程耗时长LIU[19] 使用最优K D-Tree 搜索最近点的策略加速算法 提升了 ICP 算法的整体性能GELFAND[20] 采用协方差矩阵的采样方法,减少了点云数目 提升了算法效率WEIK[21] 利用图像的梯度信息筛选点云,减少点云数目 提升了算法效率TrICP[22] 根据重叠度由小到大排序点云,保留排序靠后的点对进行配准点云间重叠度较低时配准精度低可适用于重叠度低于50%的点云HAN[23] 先选择 SIFT 特征点匹配算法作为 ICP 的粗配准方法,然后基于 SIFT 特征点选择其邻域作为匹配范围提升了点云间重叠较低时的配准精度获得好的配准结果需要较长的时间RANSAC –BasedDARCES[24]对输入点云进行均匀下采样,在目标点云中随机挑选一个点,根据源点云中三点的关系找到剩余两个点,实现对应点匹配减少了算法的运行时间RANSAC 类配准方法Super – 4PCS[25] 采用智能搜索策略,通过点间的夹角度数与距离值来限制选取的点降低了算法计算时间、提高配准效率V4PCS[26] 将4 个共面点扩展到非共面点,并与模型的体积信息结合 增加了四点集的匹配可能性算法具有随机性,下一次结果可能会变差D4PCS[27]通过估计点云的重叠比例来动态更新基的边长,从而自适应地调整点云的重叠度,以动态提取近似一致的共面四点集有效提高了算法的收敛速度与配准精度基于特征提取的配准方法点云质量较差时,效果难以令人满意,计算复杂度高FPFH[28] 不计算所有邻域点之间的几何关系,采用基于距离的重新权重方法相较于PFH,提高了算法的计算效率LIU[29] 在FPFH 特征的基础上加入了Hausdorff距离约束 提高了对应点查找的准确度

图2 传统优化方法

Fig.2 Traditional optimization methods

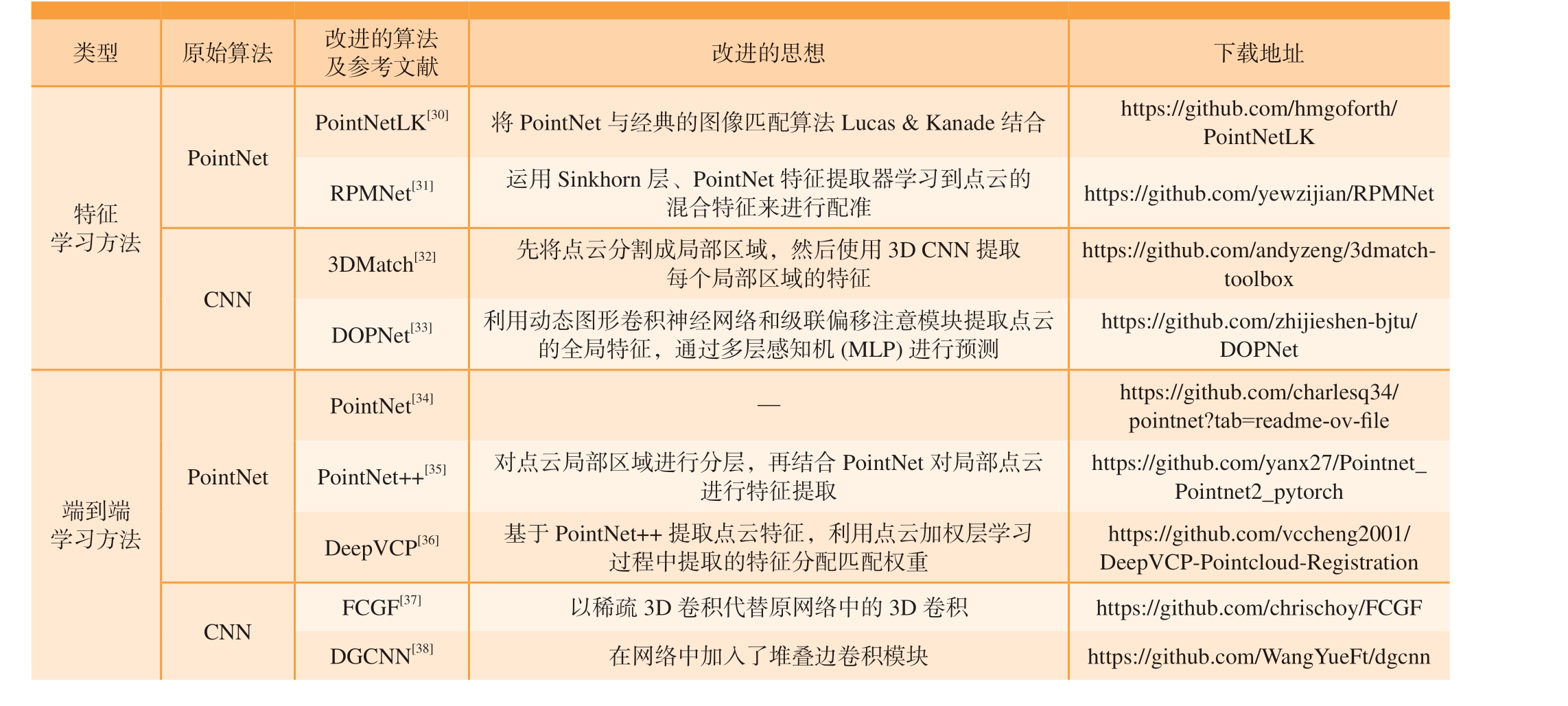

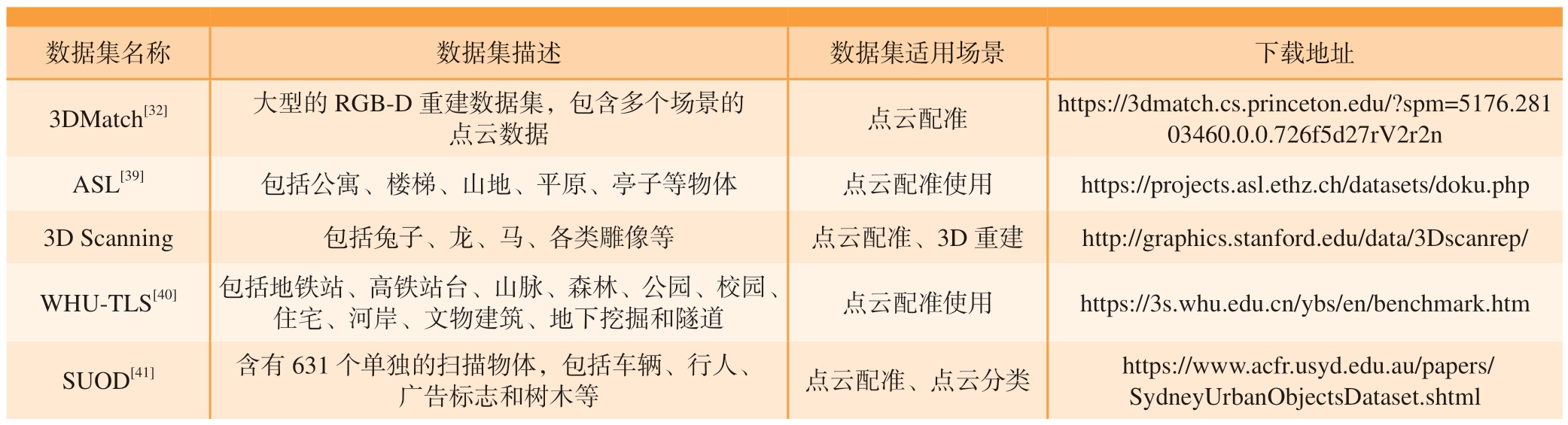

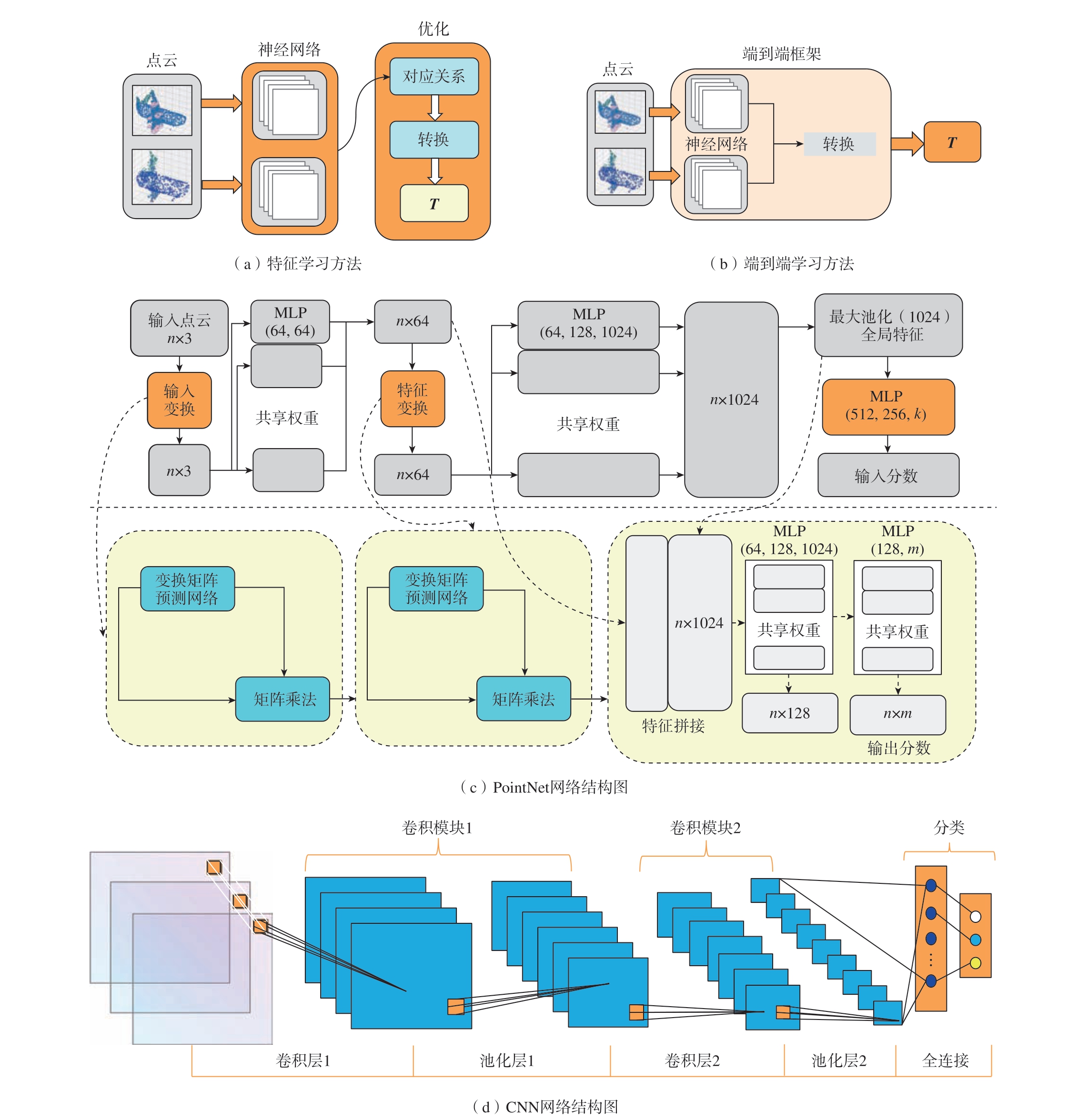

如图3(a)和 (b)所示,深度神经网络通过体积数据或直接从点云中学习,实现对应点的匹配,并通过变换矩阵的估计获得最终的变换矩阵,其可分为特征学习方法与端到端学习方法两类。其中,端到端学习方法直接从原始数据预测输出,而基于特征的学习方法需先提取特征再进行预测。现有的深度学习方法多在Pointnet 与CNN 的基础上改进得到,其结构分别如图3(c)和 (d)所示。图3(c)中k 表示输出分数的数量;m 表示输出特征的数量;n 表示输入点云的点的数量。表2 中总结了特征学习方法类[30–33]与端到端学习方法类[34–38]的改进算法,考虑到数据集对于深度学习的重要性,在表3 中汇总了常见的点云配准数据集,并给出了下载地址。

表2 基于深度学习的方法介绍

Table 2 Introduction to learning-based methods

PointNet端到端学习方法PointNet[34]—https://github.com/charlesq34/pointnet?tab=readme-ov-file PointNet++[35] 对点云局部区域进行分层,再结合PointNet 对局部点云进行特征提取https://github.com/yanx27/Pointnet_Pointnet2_pytorch DeepVCP[36] 基于PointNet++提取点云特征,利用点云加权层学习过程中提取的特征分配匹配权重https://github.com/vccheng2001/DeepVCP-Pointcloud-Registration CNN FCGF[37] 以稀疏3D 卷积代替原网络中的3D 卷积 https://github.com/chrischoy/FCGF DGCNN[38] 在网络中加入了堆叠边卷积模块 https://github.com/WangYueFt/dgcnn

表3 点云配准的常见数据集汇总

Table 3 Summary of common point cloud registration datasets

数据集名称 数据集描述 数据集适用场景 下载地址3DMatch[32] 大型的RGB-D 重建数据集,包含多个场景的点云数据 点云配准 https://3dmatch.cs.princeton.edu/?spm=5176.281 03460.0.0.726f5d27rV2r2n ASL[39] 包括公寓、楼梯、山地、平原、亭子等物体 点云配准使用 https://projects.asl.ethz.ch/datasets/doku.php 3D Scanning 包括兔子、龙、马、各类雕像等 点云配准、3D 重建 http://graphics.stanford.edu/data/3Dscanrep/WHU-TLS[40] 包括地铁站、高铁站台、山脉、森林、公园、校园、住宅、河岸、文物建筑、地下挖掘和隧道 点云配准使用 https://3s.whu.edu.cn/ybs/en/benchmark.htm SUOD[41] 含有631 个单独的扫描物体,包括车辆、行人、广告标志和树木等 点云配准、点云分类 https://www.acfr.usyd.edu.au/papers/SydneyUrbanObjectsDataset.shtml

图3 基于深度学习的方法

Fig.3 Methods based on deep learning

基于深度学习的点云配准方法相较于传统方法具备显著优势。深度学习方法能够提取更为精准、鲁棒的点云特征,大幅减少噪声干扰对配准效果的影响。此外,由于不需要传统方法中的多次迭代过程,深度学习方法显著提升了配准速度,降低了时间开销,对配准效率尤为有利。在处理部分可见的点云时,深度学习方法也比传统方法表现出更好的适应性。然而,与基于数学理论的传统点云配准方法相比,深度学习方法的泛化能力仍显不足,难以适应未见过的不同数据集[42]。

1.2 大型构件装配外形测量

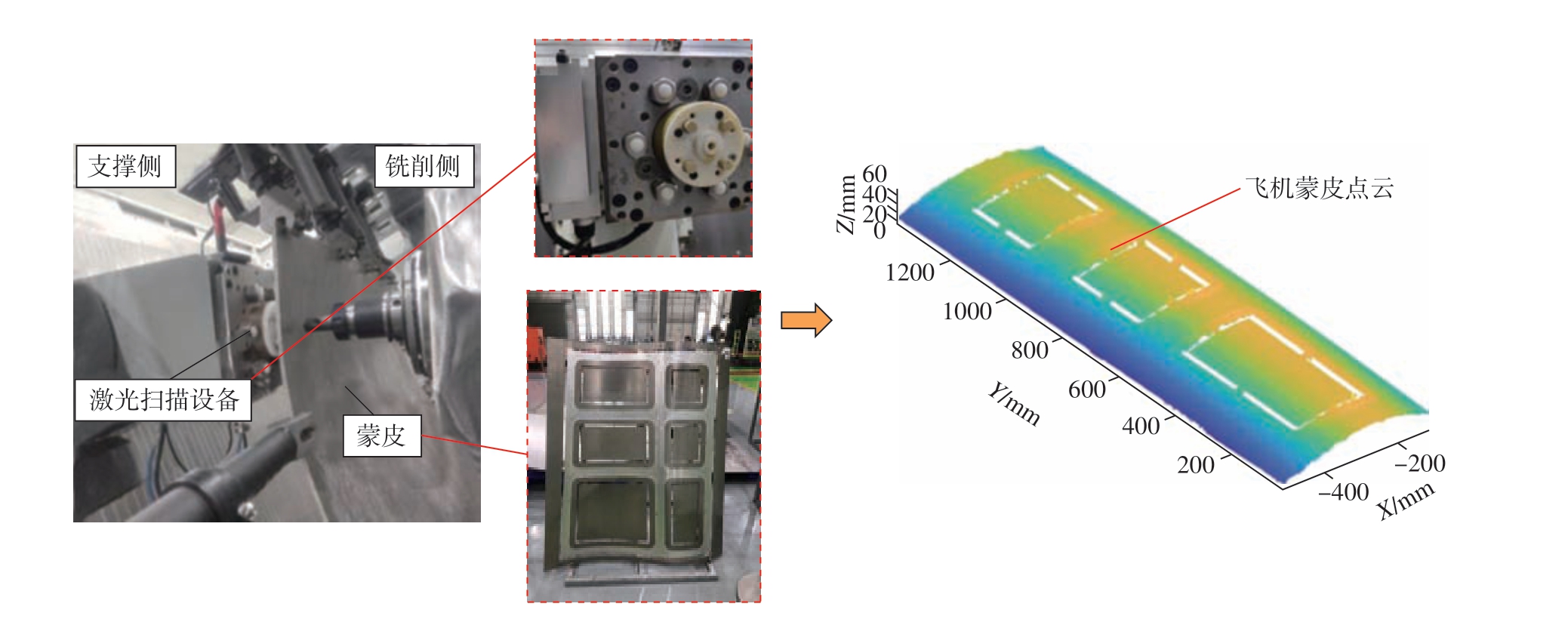

装配是保证航空产品外形精度的重要环节,提高装配部件的外形检测水平对于提升制造质量有重要意义。利用三维模型采样设备获取点云数据,是实现物体外形精准测量的有效方法。这种方法主要分为接触式与非接触式两大类。接触式测量典型设备为三坐标测量机,其工作原理为通过带有传感器的测头接触被测物体的表面来获取高精度的点云信息。高继昆等[43]使用三坐标测量机实现了航空发动机整体叶盘的外形测量。接触式测量方法精度高,但是效率低、易划伤工件表面且无法实现自动化测量;非接触式测量中较为常用的有激光扫描仪、线结构光扫描仪等,其测量原理为通过光、声电磁等方式,将模拟量转化为模型上点的坐标信息。如图4 所示,利用线激光扫描仪可以获得飞机蒙皮点云,实现无接触测量。张泽[44]提出了一种基于结构光三维扫描的飞机蒙皮外形测量方法,实现了飞机蒙皮的无接触测量。

图4 线激光扫描获取蒙皮点云

Fig.4 Line laser scanning to obtain skin point clouds

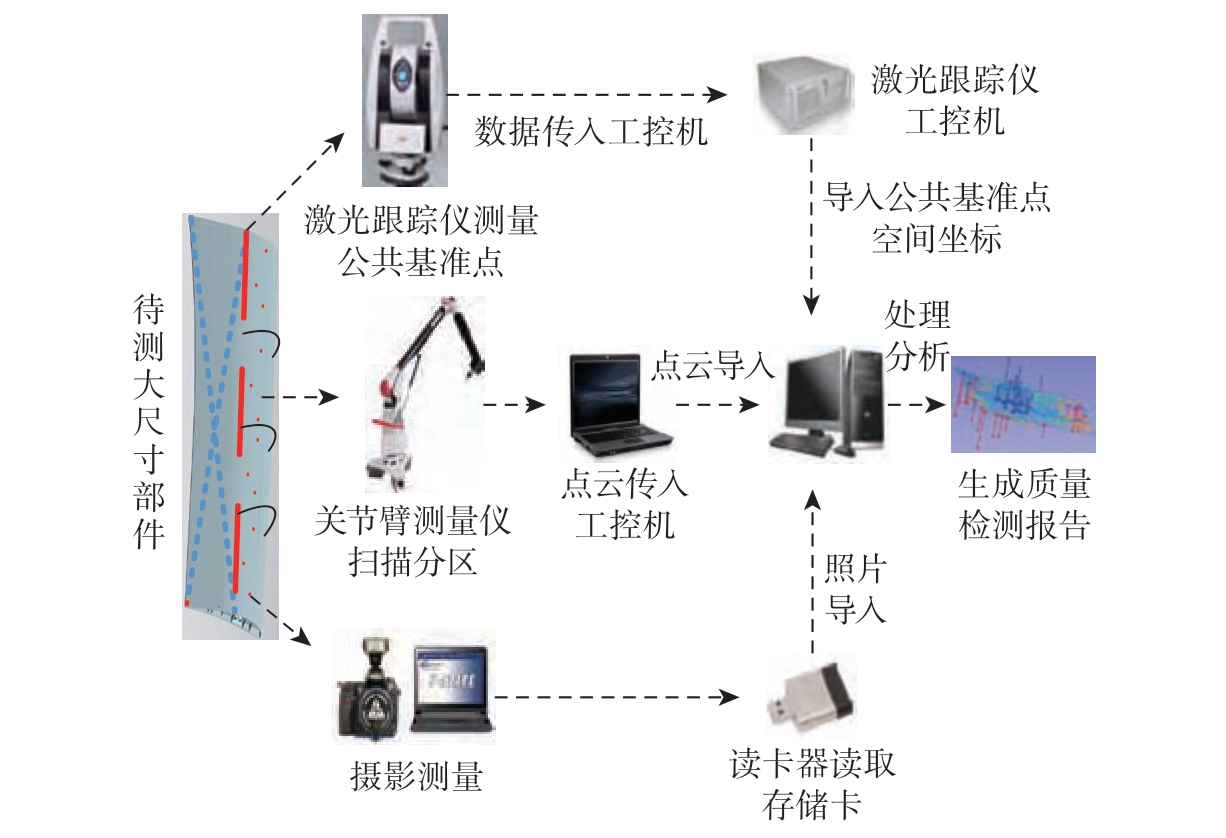

随着测量要求的提高,激光扫描法、结构光法等单一视觉非接触式测量方法难以兼顾测量效率与测量精度。将视觉传感器与其他传感器结合构建数字化组合系统,使设备性能互补,可以有效提升测量精度与效率。如图5 所示,李五朋等[45]将关节臂测量仪、激光跟踪仪以及摄影测量组合,在飞机内襟翼上翼面外形精度测量上应用与验证,在保证外形测量精度的同时提高了测量效率。Zhou等[46]为了解决大型部件关键局部特征的全局测量和局部测量精度之间的矛盾,将3D 扫描仪、激光跟踪仪和工业机器人组合对大型构件进行形状测量。隋少春等[47]将AGV 小车、移动式激光扫描仪、工业机器人相结合构建了固定式测量站,用于测量飞机几何外形,其重复测量精度可达0.024 mm,3D 点坐标测量误差小于0.2 mm,且有60%的测量数据误差小于0.1 mm。

图5 飞机大部件外形组合测量系统[45]

Fig.5 Combination measuring system of aircraft large component outline[45]

1.3 大型构件装配中的孔测量

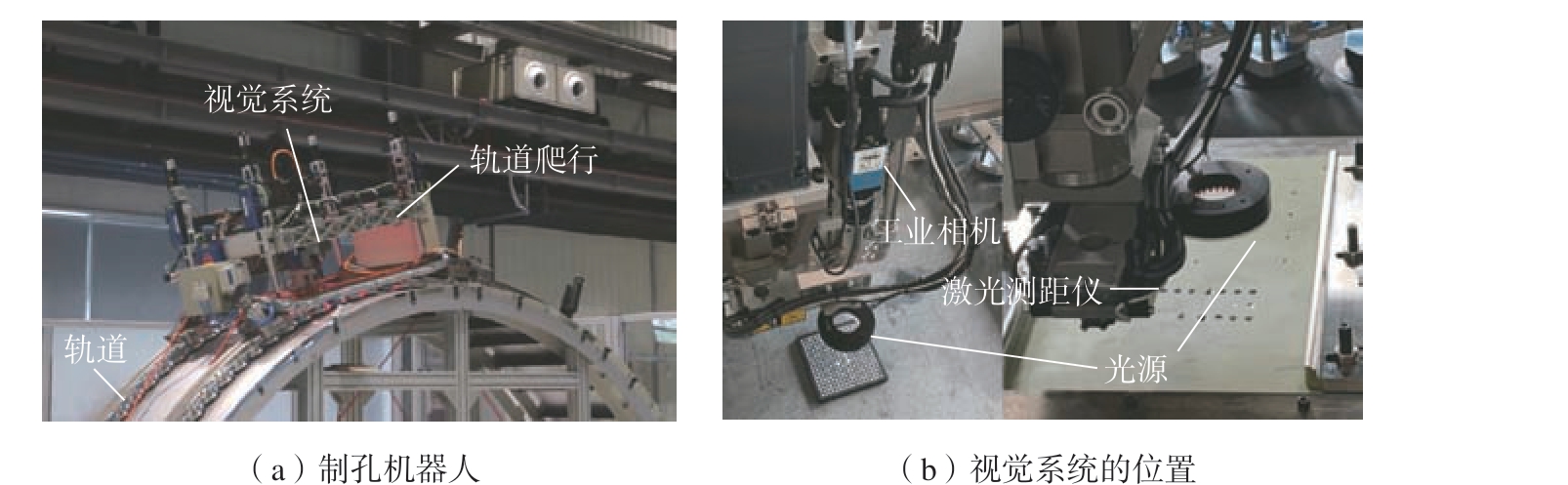

机器视觉测量已经广泛应用于机器人自动化制孔过程中,将工业相机、机器人与法矢测量单元结合,可以实现孔位置与垂直度的高精度测量。如图6 所示,崔海华等[48]将工业相机与激光位移传感器结合,利用图像处理手段获得基准孔轮廓,通过激光位移传感器以及4 条支撑柱保证相机光轴与基准孔所在的平面垂直且测量高度h 固定,计算获得基准孔位置坐标,定位误差小于0.05 mm。毕运波等[49]将工业相机与激光测距仪结合,提出一种基于视觉测量的沉头孔垂直度检测方法,沉头孔垂直度的平均视觉测量误差约为0.03°。考虑到机器人在部分场景的应用受到限制,张辉等[50]提出了一种面向航空锪窝孔制孔质量的手持式视觉检测方法,开发了锪窝孔孔径及窝深的亚像素检测算法,孔径测量精度优于0.01 mm,锪窝深度测量精度优于0.1 mm。

图6 试验装置[48]

Fig.6 Experimental setup[48]

基于单目视觉的测量方法一方面要求相机与被测对象保持垂直度关系,另一方面容易受到投影误差的影响。而基于双目视觉的检测方法不仅对垂直度的要求不高,还能够获取钻铆孔内外轮廓在相机坐标系下的三维坐标,从而可以通过三维重建的方式获取钻铆孔的几何参数。如图7 所示,王红平等[51]采用双目视觉测量飞机蒙皮自动钻铆中锪孔的尺寸,在双目视觉的三维重建中,以拟合空间曲线的方式建立钻铆孔的空间圆锥模型,从而得到钻铆孔的内孔孔径和锪窝深度,试验显示测量误差均在0.04 mm 内。也可以采用结构光的方案进行三维测量,陈璐等[52]采用结构光视觉的方案获得3D 点云,通过对点云的处理完成制孔位置与法向量的测量。

图7 双目视觉在线检测[51]

Fig.7 Online detection of binocular vision[51]

2 视觉引导

视觉引导即根据相机采集到的图像信息,通过算法间接评估执行器当前位姿或者与目标物体间的相对位姿,在此基础上对执行器进行控制。一般流程包括图像采集、图像处理 、特征提取、决策和控制等。在装配领域,利用视觉系统可以提高生产效率、智能化程度、加工质量和成品精度,降低设备对环境的依赖性。

2.1 微装配中的视觉引导

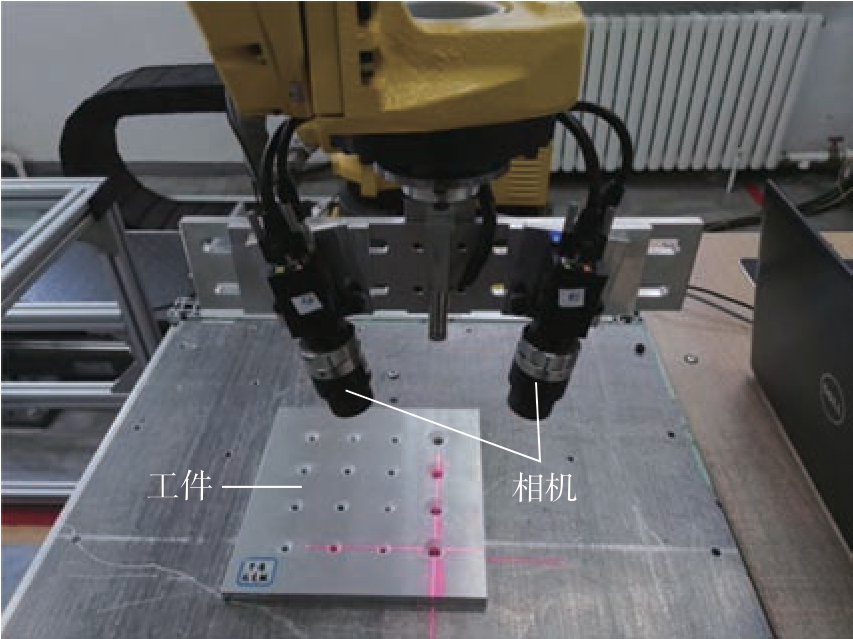

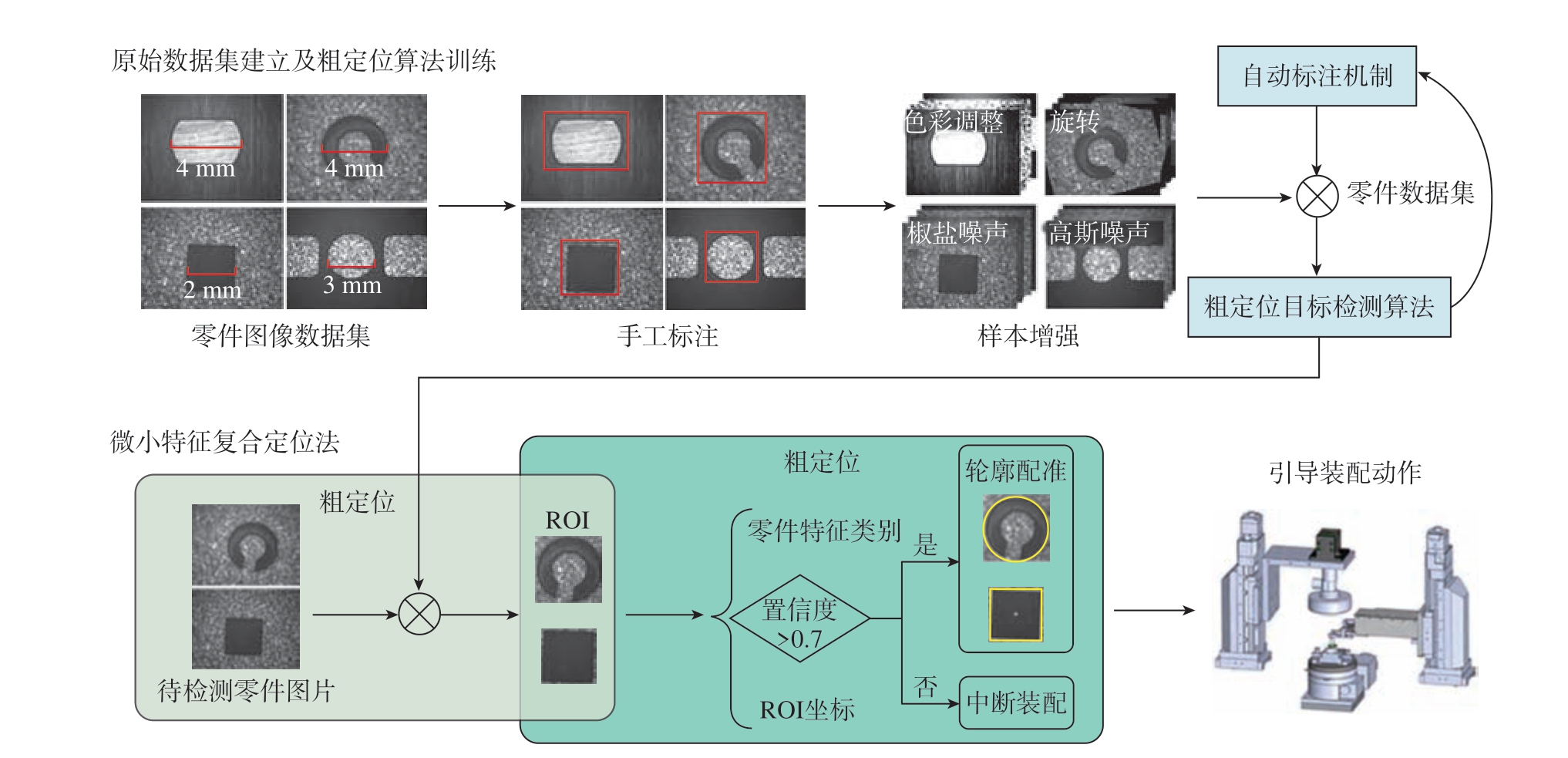

高性能微系统是航天器等重大装备中不可或缺的关键单元,其装配精度和一致性对产品性能有重大的影响。在精密微装配中,通过机器视觉引导微小特征再引导相应的装置拾取、搬运、对准微小零件是常用的模式。房运涛等[53]研制了一套万向支架微小螺纹副自动装配系统,采用基于变聚焦位置分区域图像采集的内外螺纹零件中心提取方法结合最小二乘法,确定了螺纹孔的中心,其装配外环支架偏心量小于5 μm,内环及外环的轴向窜动量均小于3 μm。随着对微系统性能和集成度要求的提高,系统逐渐呈现多品种、小批量、异形异构等特点,几何形状配准[54]、基于尺度不变特征转换[55]、方向梯度直方图特征[56]等传统模板匹配方式泛化性弱、稳定性差,难以适应照明波动、零件表面差异、轻度离焦等复杂场景下的作业需求。研究者通过引入人工智能技术,开发更高稳定性的算法。如图8 所示,王晓东等[57]提出了一种面向精密装配的微小零件特征复合定位方法,先利用深度学习技术锁定目标区域进行粗定位,再用几何轮廓特征精定位,结合了深度学习鲁棒性强与几何特征提取精度高的特点。

图8 复合定位法的训练及应用[57]

Fig.8 Training and application of composite positioning method[57]

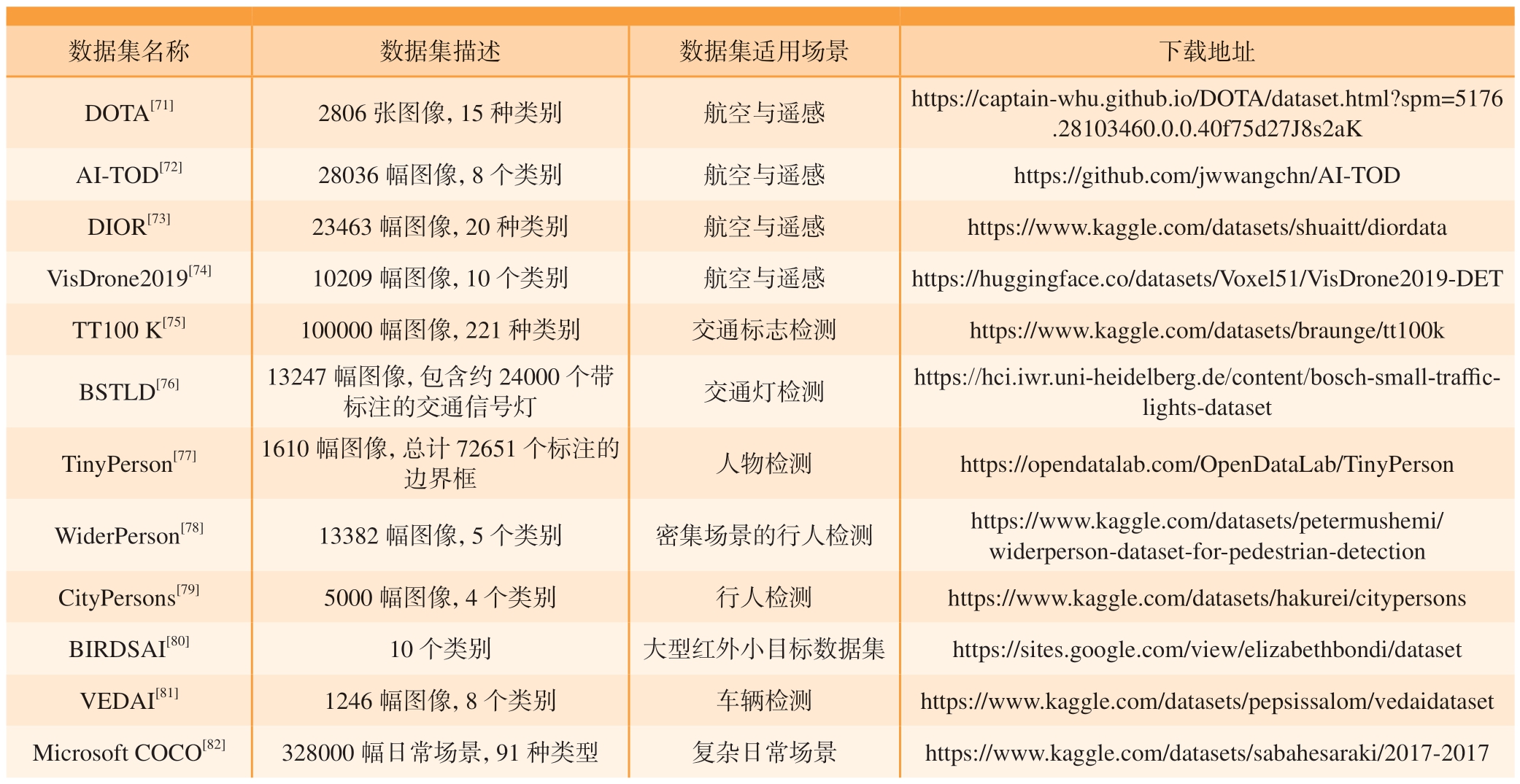

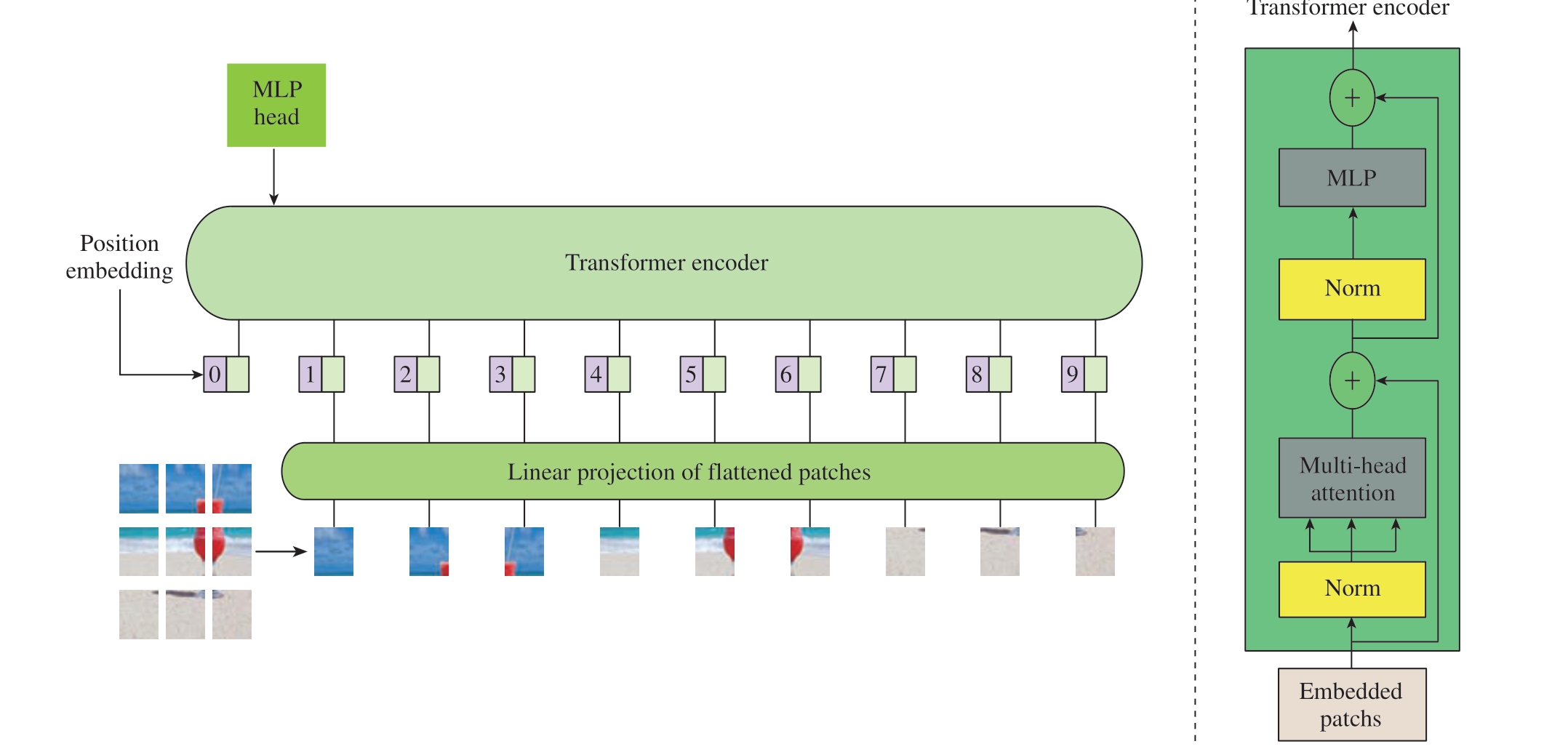

显微机器视觉能够为微装配系统提供环境、目标位姿和受力等关键信息,通过高精度的目标跟踪及力、位信息检测,确保系统的整体性能。目标识别检测算法是显微机器视觉研究的核心之一,可分为传统方法与基于深度学习的方法两类。传统方法依赖手工设计的特征提取算法,如背景减法、时间差法和光流法等[58–59],这些方法存在表达能力有限、过程复杂冗余、识别准确率低,以及对环境噪声和光照条件敏感等问题,导致其鲁棒性和普适性较差。相比之下,智能显微机器视觉技术利用深度神经网络实现目标识别检测,可以自动学习不同类别对象的特征,提供更具描述性和显著性的特征表示,大幅提升检测的准确性和鲁棒性,增强系统的泛化能力。现有的小目标检测深度神经网络多由CNN、YOLO、Transformer(图9)等改进而来,在表4 中总结了一些典型算法并提供了下载链接以供参考,考虑到数据集的重要性,在表5 中提供了常用数据集的下载链接。

表4 微小目标检测神经网络介绍

Table 4 Introduction of neural network for micro target detection

原始算法 改进的算法及参考文献 改进的思想 下载地址CNN MTCNN[60] 多尺度融合 https://github.com/ipazc/mtcnn MTGAN[61] 提高分辨率 https://github.com/LuChang-CS/MTGAN Faster R-CNN[62] 结合锚框机制 https://github.com/ShaoqingRen/faster_rcnn CoupleNet[63] 利用上下文信息 https://github.com/yousongzhu/CoupleNet YOLO YOLOv4[64] 数据增强 https://github.com/Tianxiaomo/pytorch-YOLOv4 YOLOv5[65] 结合锚框机制 https://github.com/ultralytics/yolov5 Attention-YOLO[66] 引入注意力机制 https://github.com/search?q=Attention-YOLO&type=repositories TPH-YOLOv5[67] 添加、替换预测头 https://github.com/cv516Buaa/tph-yolov5 Transformer DETR[68] 与CNN 架构结合 https://github.com/facebookresearch/detr CF-DETR[69] 融合局部和全局信息 https://github.com/116508/CF-Deformable-DETR AO2-DETR[70] 生成定向建议 https://github.com/Ixiaohuihuihui/AO2-DETR

表5 微小目标检测数据集介绍

Table 5 Introduction of detection data sets of micro target

数据集名称 数据集描述 数据集适用场景 下载地址DOTA[71] 2806 张图像,15 种类别 航空与遥感 https://captain-whu.github.io/DOTA/dataset.html?spm=5176.28103460.0.0.40f75d27J8s2aK AI-TOD[72] 28036 幅图像,8 个类别 航空与遥感 https://github.com/jwwangchn/AI-TOD DIOR[73] 23463 幅图像,20 种类别 航空与遥感 https://www.kaggle.com/datasets/shuaitt/diordata VisDrone2019[74] 10209 幅图像,10 个类别 航空与遥感 https://huggingface.co/datasets/Voxel51/VisDrone2019-DET TT100 K[75] 100000 幅图像,221 种类别 交通标志检测 https://www.kaggle.com/datasets/braunge/tt100k BSTLD[76] 13247 幅图像,包含约24000 个带标注的交通信号灯 交通灯检测 https://hci.iwr.uni-heidelberg.de/content/bosch-small-trafficlights-dataset TinyPerson[77] 1610 幅图像,总计72651 个标注的边界框 人物检测 https://opendatalab.com/OpenDataLab/TinyPerson WiderPerson[78] 13382 幅图像,5 个类别 密集场景的行人检测 https://www.kaggle.com/datasets/petermushemi/widerperson-dataset-for-pedestrian-detection CityPersons[79] 5000 幅图像,4 个类别 行人检测 https://www.kaggle.com/datasets/hakurei/citypersons BIRDSAI[80] 10 个类别 大型红外小目标数据集 https://sites.google.com/view/elizabethbondi/dataset VEDAI[81] 1246 幅图像,8 个类别 车辆检测 https://www.kaggle.com/datasets/pepsissalom/vedaidataset Microsoft COCO[82] 328000 幅日常场景,91 种类型 复杂日常场景 https://www.kaggle.com/datasets/sabahesaraki/2017-2017

图9 Transformer 结构

Fig.9 Transformer structure

2.2 设备移动的视觉引导

移动工业机器人能够依据预设路径或实时指令自动行驶,具有高度灵活、高效和安全的特点,成为提高航空装配自动化水平的重要解决方案之一。移动机器人自动化制孔系统可以满足航空装配中对自动化灵活度逐渐增加的需求,将AGV、机器人、移动生产线相结合,可以有效提升生产质量。如图10 所示,美国AIT 公司的重载AGV 系统兼容单机与多级串联模式,支持通过用户界面或操纵杆控制,德国HUBTEX 公司的运输系统则通过模块化互联实现了高效的协同工作[83–84]。EI 公司开发了一套移动机器人制孔系统,采用移动平台顶部的KUKA 工业机器人装配飞机结构件,通过底座上的双相机实现工厂内定位与导航[85]。针对装配场景复杂多变,单一传感器对环境感知存在信息不完整的问题,有学者采用多传感器融合的方式捕捉特征实现定位。李广等[86]将移动机器人与视觉检测技术融合,结合视觉与其他传感单元获取图像、点云信息,满足了复杂多变装配场景的定位要求,实现了移动机器人的精准定位。

图10 应用于航空部件搬运的移动机器人系统[83]

Fig.10 Mobile robot system applied to aviation parts transportation[83]

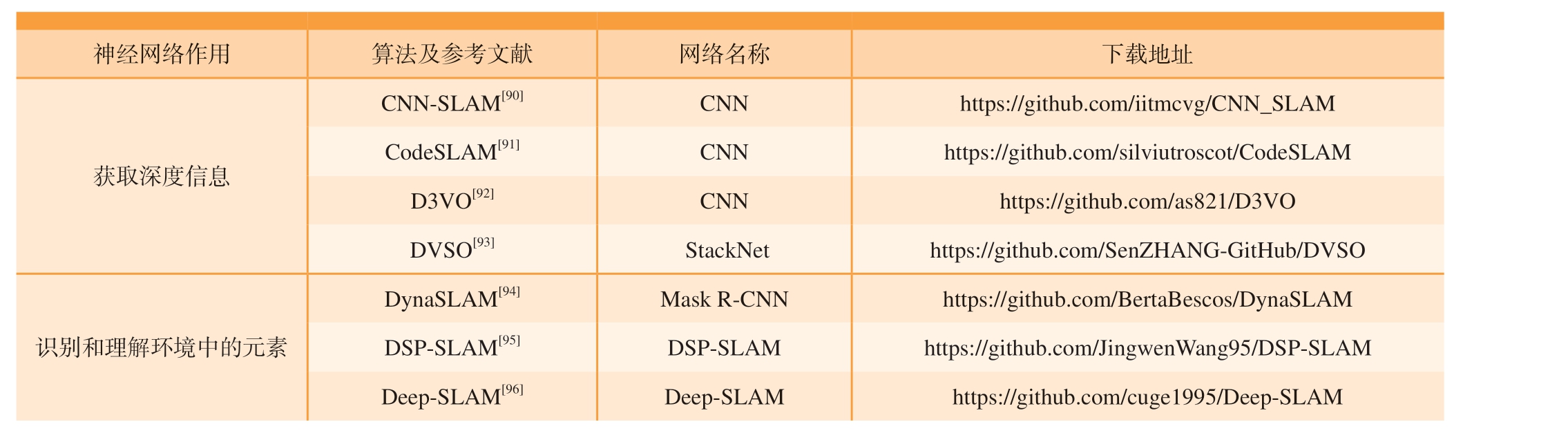

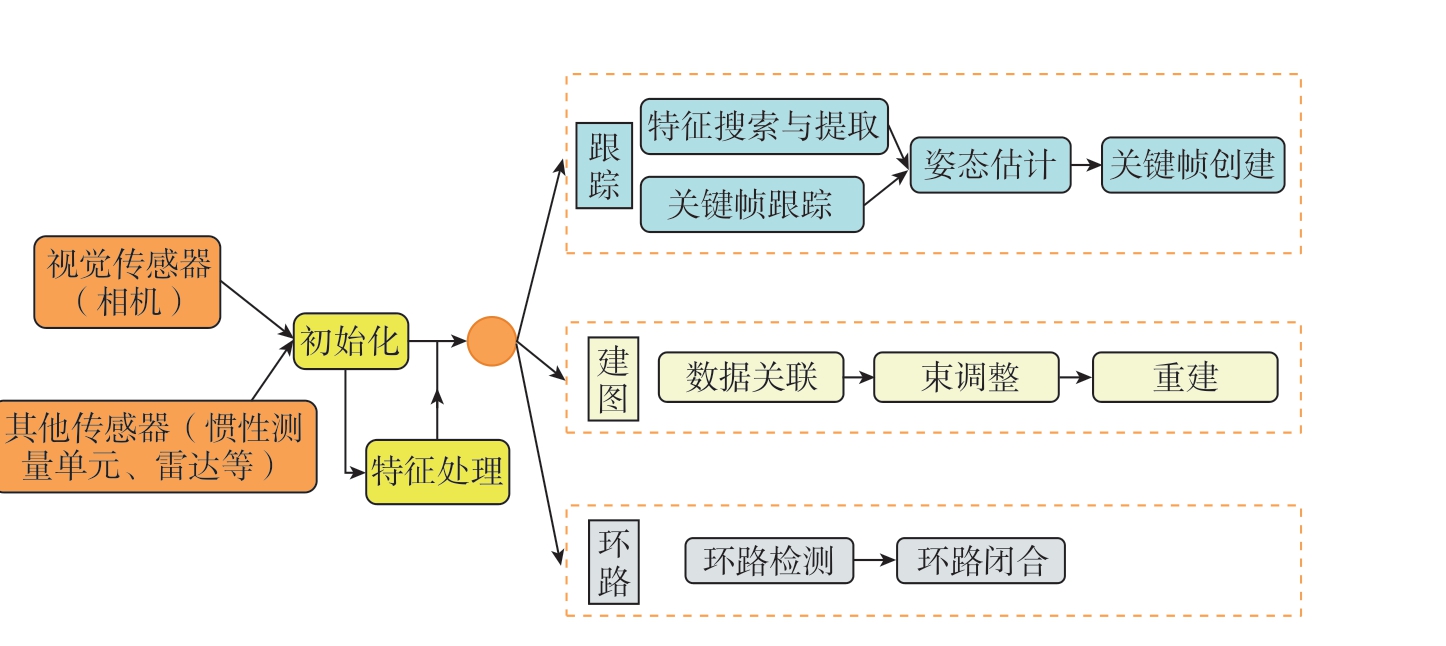

SLAM 是一种让移动机器人在未知环境中运动时,能够同时构建环境的地图并确定自身位置的技术,按照传感器种类可以分为激光SLAM与 视 觉SLAM[83–84]。视 觉SLAM 方法的总体架构如图11 所示,其又可分为基于特征点的视觉 SLAM、基于直接法的SLAM 及结合深度学习的视觉SLAM。ORB-SLAM 利用 ORB(Oriented fast and rotated brief)描述子来检测图像中的特征点,并依赖这些特征点进行定位与建图[87]。DTAM通过光度一致性检测相机位姿,同时使用优化算法来提高位姿估计的准确性,通过这些位姿信息和相邻帧之间的图像信息构建三维稠密地图[88]。通过引入深度学习模型可以对视觉SLAM 的各个环节进行优化,特别是在特征提取、匹配和环境理解等方面。此外,深度学习还常用于提升闭环检测能力,使得SLAM 系统能够更有效地应对动态环境变化,从而提高其长期运行的稳定性和可靠性[89]。为了方便参考,在表6 中总结了相关的算法并提供了下载地址,在表7 中给出了常用的视觉SLAM 数据集的下载地址。

表6 基于深度学习的视觉SLAM 算法

Table 6 Visual SLAM algorithm based on deep learning

神经网络作用 算法及参考文献 网络名称 下载地址获取深度信息CNN-SLAM[90] CNN https://github.com/iitmcvg/CNN_SLAM CodeSLAM[91] CNN https://github.com/silviutroscot/CodeSLAM D3VO[92] CNN https://github.com/as821/D3VO DVSO[93] StackNet https://github.com/SenZHANG-GitHub/DVSO识别和理解环境中的元素DynaSLAM[94] Mask R-CNN https://github.com/BertaBescos/DynaSLAM DSP-SLAM[95] DSP-SLAM https://github.com/JingwenWang95/DSP-SLAM Deep-SLAM[96] Deep-SLAM https://github.com/cuge1995/Deep-SLAM

表7 视觉SLAM 的常用数据集

Table 7 Common data sets for visual SLAM

数据集名称及参考文献 数据集描述 数据集适用场景 下载地址https://www.dropbox.com/scl/fo/ja9heh2wdcykaofy1zn x5/ABzl0XOuTdGVHgRHJ231XKk?rlkey=dfdla7luh5 yvzahuaxdh77jz3&e=1&dl=0 KITTI[98] 车载摄像头和激光雷达数据 自动驾驶、车辆定位 https://huggingface.co/datasets/nateraw/kitti ICL-NUIM[99] RGB-D 图像序列 室内导航、机器人定位 https://www.doc.ic.ac.uk/~ahanda/VaFRIC/iclnuim.html TUM RGB-D[100] RGB-D 图像序列 室内导航、机器人定位 https://huggingface.co/datasets/voviktyl/TUM_RGBD-SLAM SceneNet RGB-D[101] 合成的RGB-D 图像数据 室内导航、虚拟现实 https://robotvault.bitbucket.io/scenenet-rgbd.html OpenLORIS-Scene[102] RGB-D 图像序列 室内导航、机器人定位 https://github.com/lifelong-robotic-vision/OpenLORISScene/blob/master/download.md NTU VIRAL[103] RGB-D 图像序列 室内导航、机器人定位 https://ntu-aris.github.io/ntu_viral_dataset/RAWSEEDS[97] RGB-D 图像序列和IMU 数据 室内导航、机器人定位

图11 视觉SLAM 方法的总体架构

Fig.11 Overall architecture of the standard visual SLAM method

2.3 装配对接的视觉引导

使用视觉传感器来指导机器人完成任务,可以实现对机器人的闭环控制,使控制系统设计更加灵活,提升精度。季旭全等[104]提出一种基于机器人与视觉引导的星载设备智能装配方法,将装配时间缩短至若干分钟以内,将装配误差控制在0.3 mm以内,提升了装配的精度与效率。如图12 所示,李鹏程等[105]将视觉与力觉结合,利用视觉技术完成装配误差的在线测量,通过力觉检测装置完成机器人末端负载辨识与力觉补偿,将装配误差控制在0.2 mm 以内,装配干涉力控制在50 N 以内。

图12 卫星装配试验系统平台[105]

Fig.12 System platform of satellite assembly experiment[105]

传统的目标定位方法主要依赖于解析标记物信息或点云处理,前者因人工安装标记物导致精度和稳定性差、效率低;后者在高动态范围区域易产生相位计算错误,且处理时间长、计算成本高[106]。结合视觉与深度学习的目标检测方式,不仅无需标记物,而且抗干扰能力更强,实时性也更好。Triyonoputro 等[107]针对孔初始位置不确定的轴孔装配问题,提出一种基于学习的视觉伺服方法,利用训练的DNN 网络预测孔的位置,实现轴孔的迅速靠近。孙阳等[108]提出视觉引导入位方法,使用改进的YOLO-v5s 模型检测球窝确定位置,再引导球头竖直插入球窝点。

许多科研计划需要有大型空间结构作为基础,如大型太阳能电池阵列、星载天线等,但它们无法通过运载器直接送入太空,需要由桁架在轨装配而成,利用空间机器人结合视觉伺服可以有效完成任务[109]。刘新玉等[110] 提出一种采用协作机器人辅助实现空间展开机构桁架铰链微重力装配的方法,采用视觉引导方式快速自动抓取桁架铰链。传统的机器人视觉伺服系统大多是在对相机模型和机器人模型标定的基础上实现的,但在轨装配过程中无法实现对系统的精确有效标定,因此无标定的视觉伺服方法具有更广泛的应用前景。如图13 所示,贾庆轩等[111]设计了一种基于深度估计器和滑模控制器的无标定视觉伺服对准方法,该方法通过在线估计目标深度值,并根据反馈图像信息实时调整机器人关节运动,以纠正系统误差,实现精确对准跟踪。

图13 视觉引导的移载式定位器对接系统[111]

Fig.13 Vision-guided relocatable positioner docking system[111]

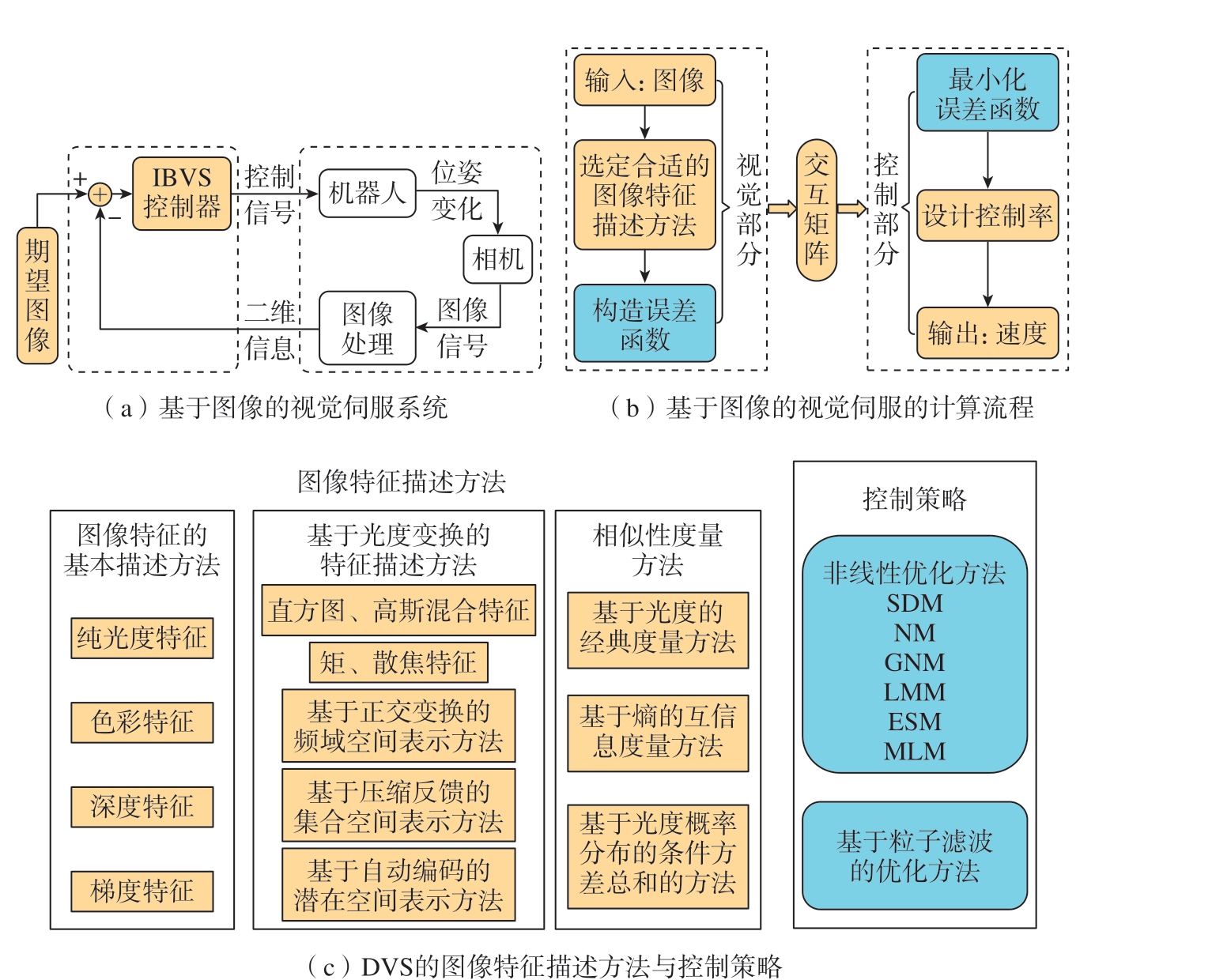

传统的基于图像视觉伺服 (IBVS)主要通过图像特征来实现控制任务,利用特征点的坐标变化间接推测位姿变动,其框架与计算过程分别如图14(a)和 (b)所示。这些方法通常依赖于点、线、面等几何信息,但实现过程中需要精确的相机姿态、稳健的特征提取、快速的帧间匹配以及实时的时空跟踪,且在噪声、尺度和旋转变化下精度容易受损,特征提取过程也容易出错且通用性有限。此外,基于点特征的交互矩阵存在非线性强、耦合性高等问题,容易陷入局部最小值,且收敛域有限。直接视觉伺服(DVS)则跳过了复杂的特征提取过程,利用图像的全局特征 (如光度、色彩、梯度、深度)构造误差函数进行控制,直接在信号级别操作,无需中间估计环节,避免了特征丢失、视野变化导致的奇异性和不连续性,从而提升了系统的稳定性、准确性和鲁棒性,但DVS 仍然存在收敛域较小、可能陷入局部极小值等问题,其图像特征描述方法[112–115]与控制策略[113,116]如图14(c)所示。

图14 视觉伺服

Fig.14 Visual servo

近年来,视觉伺服技术 (VS)开始集成深度学习 (DL)与强化学习(RL)的方法,以实现直接控制和特征提取,主要包括DL + IBVS、DL + DVS和RL + VS 3 类。Ahlin 等[117]将CNN集成到IBVS 中,使用CNN 进行对象跟踪,具有在日益非结构化的环境中应用的优势。Bateux 等[118]将CNN集成到DVS 中,使用CNN 估计当前图像和期望图像之间的相对姿态,完成了高精度、鲁棒性和实时性要求的六自由度定位任务。Gao 等[119]提出了一种基于神经网络提取集中特征的测量方法,通过计算访问状态的新颖性来鼓励RL 智能体的探索,其奖励值和完成率分别比SAC 与VS 提高了0.35%和8.0%。

3 视觉检测

视觉检测是用机器代替人眼来做测量和判断,它通过图像摄取装置将被摄取目标转换成图像信号,然后传送给专用的图像处理系统,根据像素分布和亮度、颜色等信息,转变成数字化信号,再通过图像系统对这些信号进行各种运算来抽取目标的特征,获得判别的结果。

利用视觉检测不仅可以实现装配过程中错漏装、多余物、装配损伤等问题的高效精准检测,还大幅提升了检测的灵活性与自动化水平。

3.1 装配中的错装及漏装检测

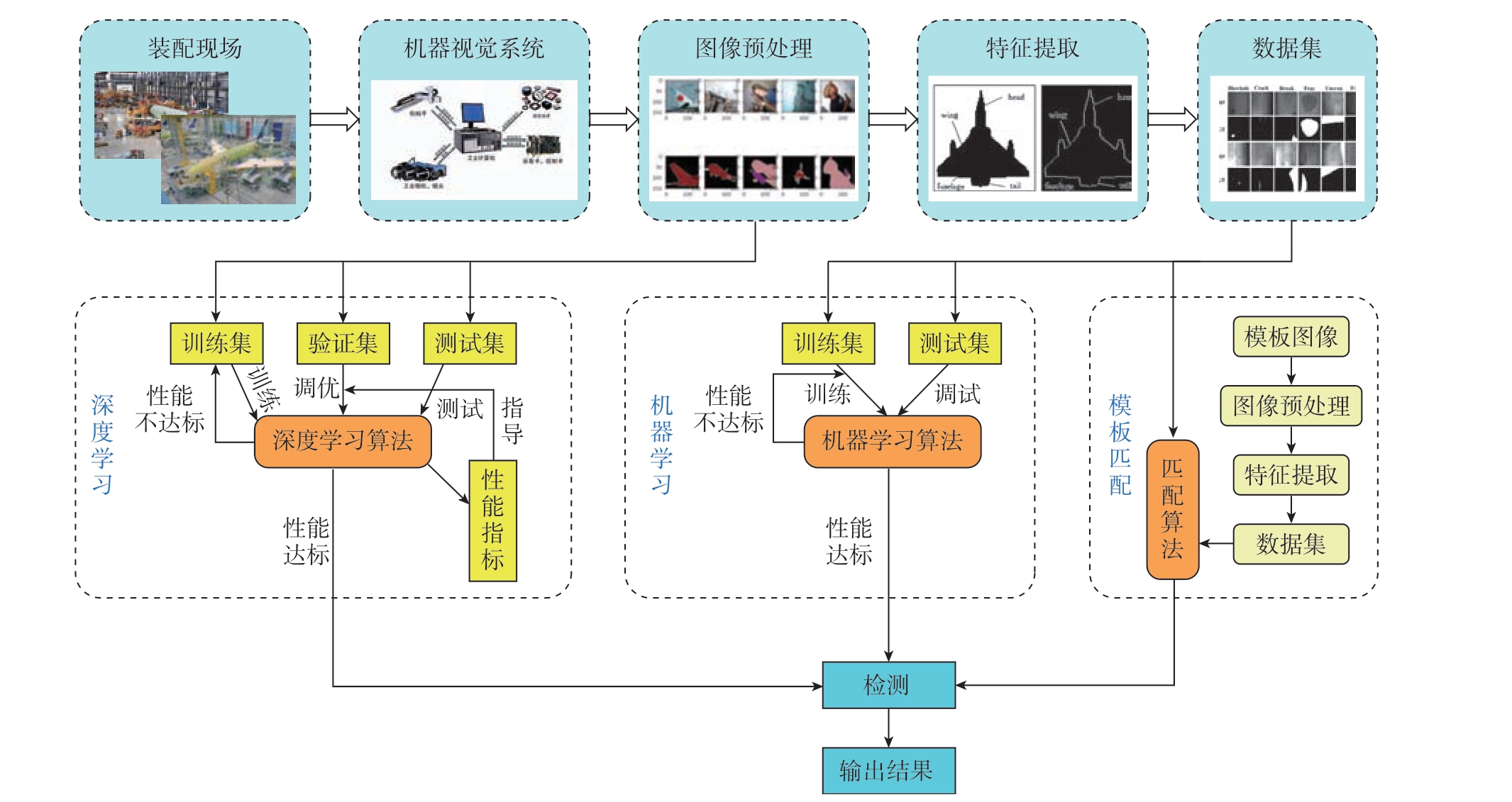

由于飞机结构复杂,零部件较多且体积庞大,在装配过程中容易出现错装或漏装,为确保质量,需进行错漏装检测,现有的方案包括人工检测、机械检测、视觉检测3 类。视觉错漏装检测方案相对于其他方案具有速度快、精度高的优势,已经得到了广泛的应用。如图15 所示,视觉错漏装检测按照核心算法的不同可分为基于模板匹配的错漏装检测技术、基于机器学习的错漏装检测技术和基于深度学习的错漏装检测技术3 类。缪晨萱等[120]用机械臂控制图像采集单元,通过视觉技术检测航空发动机燃烧室的错装、漏装情况,针对燃烧室管路保险丝的漏装缺陷检出率可达100%。李广等[86]利用移动机器人作为柔性运动平台,将多视觉传感器作为检测单元,能有效完成零/部件边长测量、螺钉漏装检测和零/部件间距测量。在着色检测中,通过机器视觉技术进行图像处理,不仅可以实现着色剂有无检测,还可以判断其面积、均匀性、连续性是否符合标准[121]。

图15 机器视觉的不同错漏装检测方法的流程

Fig.15 Process of different error and omission detection methods of machine vision

如图16 所示,模板匹配是一种常用的目标检测方法,通过计算模板与目标图像之间的相似度来识别与定位目标,广泛应用于装配错误或缺失部件的检测,具有稳定可靠、高效的优点,主要包括基于灰度值的模板匹配算法和几何特征的模板匹配算法两种。基于灰度值的模板匹配算法通过计算像素灰度值之差的绝对值或平方和,找到相似度最高的匹配点,适用于目标平移情况,但对光照变化较为敏感。董元发等[122]针对手工装配作业中微小金属件装配区图像特征易受光照环境影响产生不规则动态变化的问题,建立了不同装配特征灰度分布混杂区动态识别的数学模型,解决了装配现场图像易受光照环境影响的问题。基于几何特征的模板匹配方法,通过对图像中的几何特征与模板的几何特征来进行匹配,在飞机错漏装检测任务中常用的几何特征有边缘特征、轮廓特征、角点特征、尺度不变特征、几何关系特征等[123]。 李静寅[124]设计了一种用于错漏装检测的图像定位匹配算法,通过机器视觉实时采集装配图像,并利用角度偏差检测与标准模板进行匹配,实现对多媒体导航仪内错漏装问题的检测,精度达98.18%。

图16 模板匹配方法总结

Fig.16 Summary of template matching methods

基于机器学习的飞机错漏装检测技术,利用机器学习算法和模型来检测飞机装配过程中可能出现的错误和缺陷,它可以从大量的数据中学习并自动提取特征和模式,以实现相较于模板匹配更准确的检测和判断。Burresi 等[125]针对电子产品的螺钉漏装问题,利用机器学习方法进行了检测。WU 等[126]结合机器视觉与机器学习,提出了一种基于支持向量机(SVM)的产品错装检测方法,它通过图像处理技术识别产品缺陷类型,并利用SVM 训练集匹配结果,提升了识别的速度和准确性。基于深度学习检测方法通过构建深度神经网络模型,自动学习图像特征和模式,可以实现对缺陷信息的准确表述与理解,完成高效、准确的错漏装检测。Li等[127]针对X 射线成像在识别错误组装方面的局限性,提出了一种结合X 射线CT 和卷积神经网络 (CNN)的方法,利用CNN 对内部部件的投影信息进行分类和定位,通过与标准产品投影数据集的匹配,可识别错位、转位等装配故障,有效提升了错装、漏装、换位等问题的检测精度。

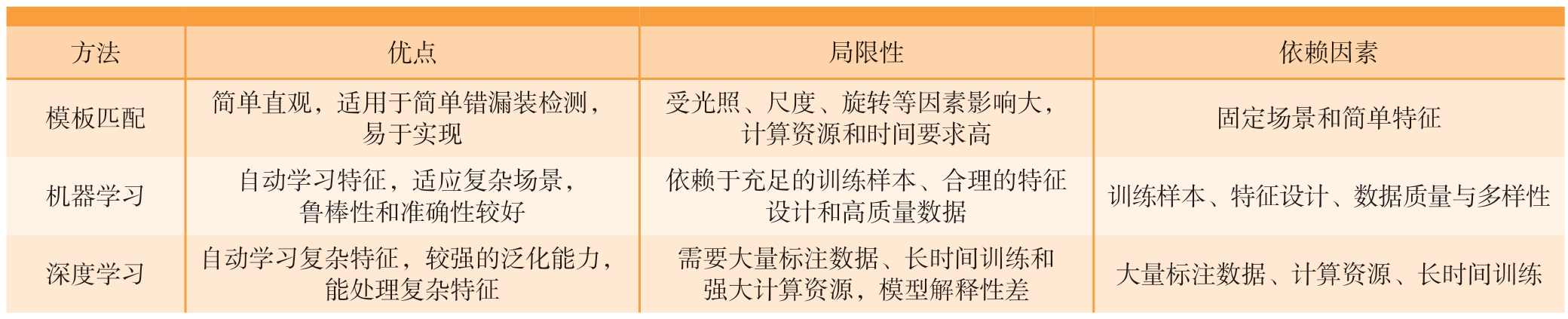

如表8 所示,模板匹配方法简单直观,适用于检测简单错漏装情况,但受光照、尺度、旋转等因素影响较大,且通常需要较高的计算资源和时间,在大规模图像匹配中表现不佳。因此,复杂错漏装检测任务常需结合机器学习或深度学习方法,以提高其准确性和鲁棒性。机器学习和深度学习能够自动学习特征和模式,适应复杂场景,具有良好的鲁棒性和准确性。机器学习依赖于充足的训练样本、合理的特征设计和高质量数据,而深度学习则具有较强的泛化能力,能处理复杂特征,但需要大量标注数据、长时间训练和强大计算资源,同时模型解释性较低,难以解释判断过程。

表8 错漏装检测方法的对比

Table 8 Comparison of three methods for error and omission detection

方法 优点 局限性 依赖因素模板匹配 简单直观,适用于简单错漏装检测,易于实现受光照、尺度、旋转等因素影响大,计算资源和时间要求高 固定场景和简单特征机器学习 自动学习特征,适应复杂场景,鲁棒性和准确性较好依赖于充足的训练样本、合理的特征设计和高质量数据 训练样本、特征设计、数据质量与多样性深度学习 自动学习复杂特征,较强的泛化能力,能处理复杂特征需要大量标注数据、长时间训练和强大计算资源,模型解释性差 大量标注数据、计算资源、长时间训练

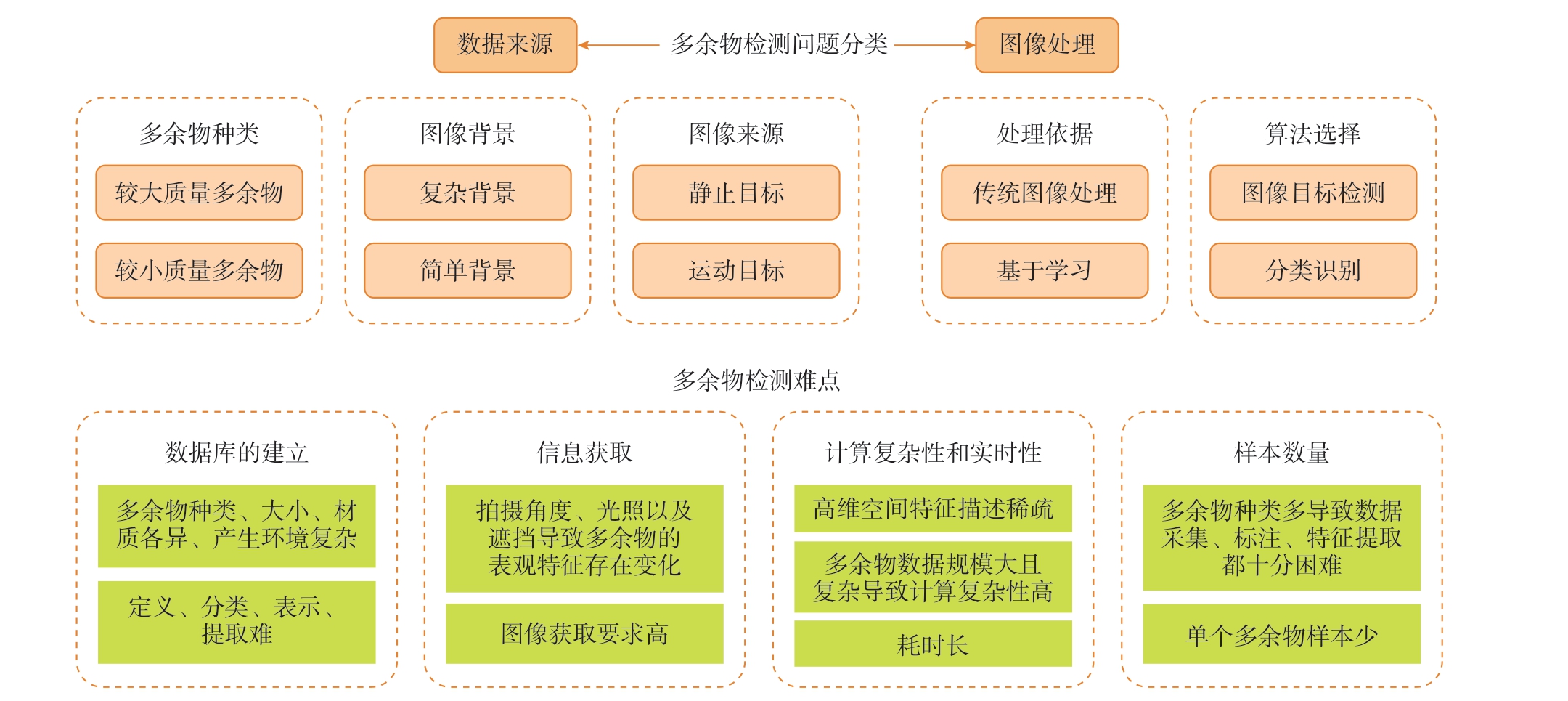

3.2 装配中的多余物及损伤检测

航天产品的研发工艺复杂,因制造工艺、操作失误等原因,易产生将多余物 (如焊锡飞溅物、螺母、毛发等)封装在产品内部,导致设备短路或误动,进而引发航天器发射失败或失效[128]。利用机器视觉技术,可以有效检测多余物,其基本原理是通过区分图像中的前景和背景信息实现检测,处理过程包括图像分割、区域特征提取、显著特征提取、显著区域识别与配准,以及多余物目标定位等关键步骤[129]。陈静[130]通过识别背景区域实现了复杂背景下多余物的检测。Zhao 等[131]提出了一种基于计算机视觉和增强现实 (AR)智能眼镜的冗余目标检测方法,使用 AR眼镜作为图像采集硬件,利用深度学习技术分析处理图像,完成多余物的检测。由于多余物种类繁多、单类样本稀缺且获取困难,这给检测带来了极大的挑战,如图17 所示,对多余物机器视觉方法进行了分类,并总结了关键技术难点[128,132]。

图17 多余物机器视觉方法分类及难点分析

Fig.17 Classification and difficulty analysis of machine vision methods for redundant objects

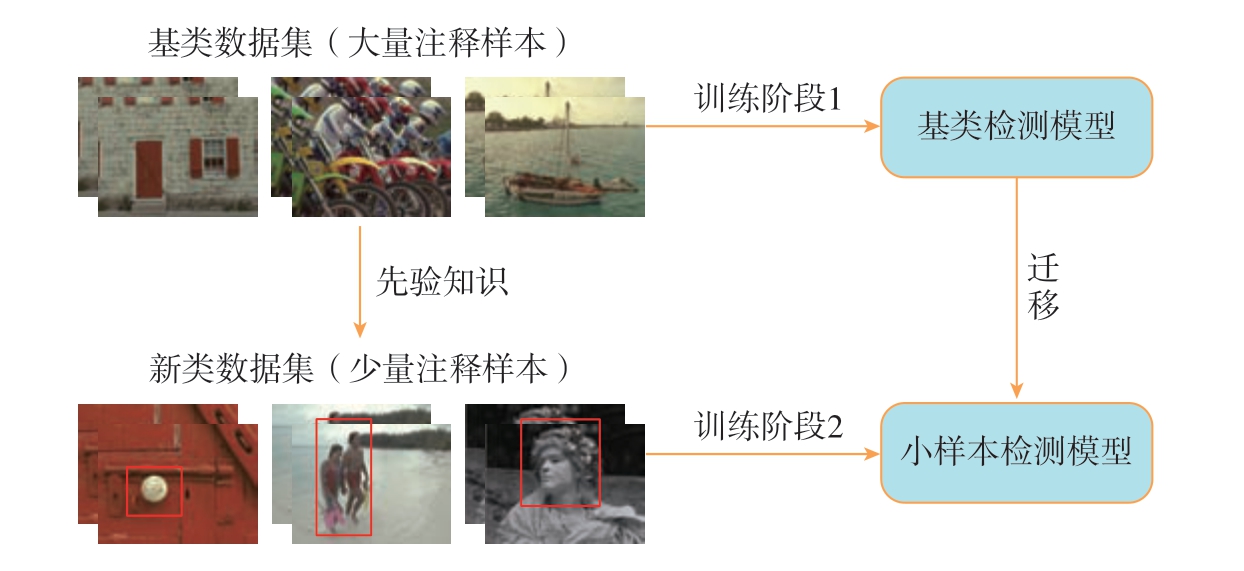

目前多余物并无标准数据集,航空航天产品多单件生产,多余物样本较少。小样本目标检测 (图18)旨在通过少量标注样本实现对图像中目标的分类和定位,以此得到具有良好泛化能力的检测模型,可以分为基于元学习的方法、基于迁移学习的方法、基于数据增强的方法和基于度量学习的方法4 类[133],在其他领域已经有了成功的案例。许夙晖等[134]针对样本量小而导致的分类精度低问题,提出了一种基于多尺度卷积神经网络 (MS-DCNN)的遥感图像场景分类方法,对UCMLandUse 和HRSS 两个数据集的分类正确率分别达91.34%和90.05%。易炟等[135]以Faster-RCNN 为基础,提出了一种基于特征耦合注意力机制的小样本目标检测方法 (FC-FSOD),在PASCAL VOC 和MS COCO 这两个公开数据集上表现优异。但是,小样本目标检测仍面临诸多挑战,包括过拟合、定位精度不足、增量学习的困难、弱监督学习问题以及域适应中的限制。此外,复杂场景下的应用也受到了显著制约。

图18 小样本目标检测示意图

Fig.18 Schematic diagram of object detection for small samples

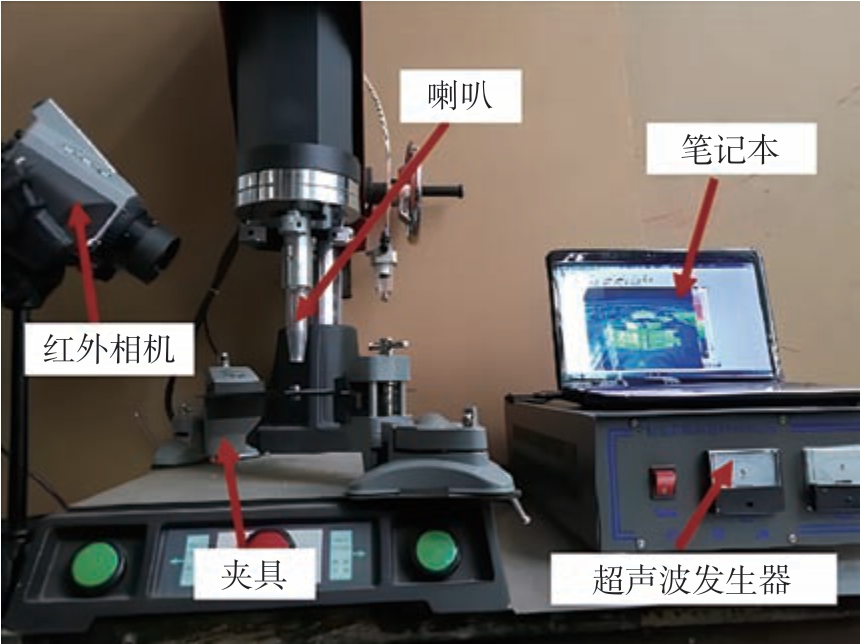

航空复合材料装配过程中的应力变化可能导致脱黏、分层、夹杂等缺陷,影响产品安全与长期服役性能,利用激光超声检测仪、超声红外热成像仪、X 射线成像仪与太赫兹时域光谱仪等仪器可以有效获得缺陷的图像信息[7,136]。Jun 等[137]发现在峰值能量密度恒定的情况下,通过增加激光束尺寸提升直射波和反射波的振幅,可显著增强激光的传播深度,从而优化较厚复合材料结构的检测系统。如图19 所示,吴昊等[138]采用超声红外热波检测的方法对复合材料螺栓连接件进行损伤识别,利用图像识别方法提取损伤信息。Khanna 等[139]采用机器视觉装置对低温环境下的CFRP 钻孔分层效果进行检测,并将其作为CFRP 低温钻孔技术的评价指标。

图19 超声红外热波检测系统[138]

Fig.19 Detection system of ultrasonic infrared heat wave[138]

由于获得的图像较为模糊且特征不够明显,需要应用图像融合和超分辨率成像技术改善复合材料缺陷图像的清晰度和特征表现,从而实现高精度的缺陷测量与定位。图像融合技术通过将来自不同传感器或视角的图像信息合成一幅新图像,综合各图像的有效信息,去除冗余或噪声,从而增强图像质量、细节和信息量。为了提升缺陷图像质量,实现缺陷的高精度测量与定位,Katunin 等[140]利用图像融合技术,对超声和X射线计算机层析成像方法检测的数据进行融合成像,提高了碳纤维增强复合材料中装配缺陷的成像分辨率。超分辨率技术通过算法处理低分辨率图像或多个低分辨率图像,恢复出高分辨率图像,从而提升图像的空间分辨率和细节表现,超越传统分辨率限制。Xu 等[141]利用超分辨率技术对具有分层缺陷的多层玻璃纤维增强聚合物复合材料进行超分辨率表征。为定位缺陷位置和计算缺陷面积,孙保燕等[142]将三维激光扫描仪得到的点云数据和红外热成像仪探测的目标轮廓信息融合,可同时获取缺陷的面积大小、位置信息。为进一步利用图像数据,Wang 等[143]利用神经网络对收集的缺陷信号进行处理,实现了对缺陷的检测和分类。

4 总结与展望

4.1 总结

机器视觉技术广泛应用于航空装配领域,本文对其在视觉测量、视觉引导、视觉检测3 个方面的应用进行了综述。视觉检测从大部件装配位姿测量、大型构件装配外形测量与大型构件中的孔测量3 个方面阐述了测量方案从单一视觉传感器到多传感器融合的发展历程,重点关注了点云配准技术,对点云配准的传统算法与基于学习的算法做出了系统性的总结,针对关键的深度学习算法提供了源码的下载链接,并提供了常见的用于点云配准算法训练的数据集下载链接,以便于读者参考。视觉引导从微装配中的视觉引导、设备移动的视觉引导与装配对接的视觉引导3 个方面说明了多传感器融合的测量方法与深度学习技术,总结了在轨装配这一新应用领域的需求与相关成果,重点关注了视觉伺服技术,阐述了IBVS 与DVS 的原理与特点,总结了DVS 的特征描述方法与控制策略,介绍了深度学习与视觉伺服结合的一些成果。视觉检测从错装及漏装检测、多余物及缺陷检测两个方面阐述,重点关注了模板匹配、机器学习与深度学习的视觉错漏装检测技术,阐述了它们的原理、特点。

4.2 展望

机器视觉技术在航空专配领域已经有了广泛的应用,深度学习技术的引入又提升了其智能化与自动化程度,并且已经有了许多成功的应用案例,可以预见的是未来深度学习技术将与机器视觉技术结合得更加紧密。但是目前的深度学习技术高度依赖数据集,以点云配准为例,公开的航空领域的数据集比较少,这导致模型无法充分学习到数据中的模式和特征,对模型的泛化能力和预测准确性造成了巨大的影响。因此,未来的研究一方面需要关注航空领域的点云配准、缺陷检测、视觉伺服等数据集的构建,另一方面需要关注数据增强、迁移学习、合成数据生成与半监督学习等技术的发展,通过这些技术减少对于数据集的依赖。

[1]XU L D, WANG C G, BI Z M, et al.AutoAssem: An automated assembly planning system for complex products[J].IEEE Transactions on Industrial Informatics, 2012, 8(3): 669–678.

[2]董云龙, 李祥飞, 刘行, 等.航空航天领域机器人化智能装配技术综述[J].人工智能, 2022(3): 6–20.DONG Yunlong, LI Xiangfei, LIU Xing,et al.Overview of robotic intelligent assembly technology in aerospace field[J].Artificial Intelligence View, 2022(3): 6–20.

[3]李彬鹏, 茅健.大尺寸飞机零部件检测技术研究进展[J].上海工程技术大学学报,2021, 35(4): 346–353.LI Binpeng, MAO Jian.Research progress on detection technology of large-size aircraft parts[J].Journal of Shanghai University of Engineering Science, 2021, 35(4): 346–353.

[4]刘金桥, 吴金强.机器视觉系统发展及其应用[J].机械工程与自动化, 2010(1): 215–216.LIU Jinqiao, WU Jinqiang.Development of machine vision system and its application[J].Mechanical Engineering & Automation, 2010(1):215–216.

[5]尹仕斌, 任永杰, 刘涛, 等.机器视觉技术在现代汽车制造中的应用综述[J].光学学报, 2018, 38(8): 11–22.YIN Shibin, REN Yongjie, LIU Tao, et al.Review on application of machine vision in modern automobile manufacturing[J].Acta Optica Sinica, 2018, 38(8): 11–22.

[6]袁培江, 陶一宁, 傅帅, 等.航空制孔机器人的现状与展望[J].航空制造技术, 2022,65(13): 38–47.YUAN Peijiang, TAO Yining, FU Shuai, et al.Status and prospect of aviation drilling robot[J].Aeronautical Manufacturing Technology, 2022,65(13): 38–47.

[7]张开富, 史越, 骆彬, 等.大型飞机装配中的高精度测量技术研究进展[J].激光与光电子学进展, 2023, 60(3): 52–69.ZHANG Kaifu, SHI Yue, LUO Bin, et al.Research progress of high precision measurement technology in large aircraft assembly[J].Laser &Optoelectronics Progress, 2023, 60(3): 52–69.

[8]刘渊, 费允锋, 宋银灏, 等.航天器舱段自动对接研究进展及关键技术分析[J].兵器装备工程学报, 2018, 39(6): 8–13.LIU Yuan, FEI Yunfeng, SONG Yinhao, et al.Research on key problems of automatic docking technology for spacecraft[J].Journal of Ordnance Equipment Engineering, 2018, 39(6): 8–13.

[9]FANG Y, BEHAL A, DIXON W E, et al.Adaptive 2.5D visual servoing of kinematically redundant robot manipulators[C]//Proceedings of the 41st IEEE Conference on Decision and Control, 2002.Piscataway, NJ: IEEE, 2003: 2860–2865.

[10]FANG Y, DAWSON D M, DIXON W E, et al.Homography-based visual servoing of wheeled mobile robots[C]//Proceedings of the 41st IEEE Conference on Decision and Control, 2002.Piscataway, NJ: IEEE, 2003: 2866–2871.

[11]CHESI G, HASHIMOTO K.Camera pose estimation from less than eight points in visual servoing[C]//IEEE International Conference on Robotics and Automation, 2004.Piscataway,NJ: IEEE, 2004: 733–738.

[12]马大智, 于斌超, 张彦泽, 等.基于双目视觉的大型高反光构件测量系统[J].应用光学, 2021, 42(4): 577–585.MA Dazhi, YU Binchao, ZHANG Yanze,et al.Measurement system of large-scale high reflective component based on binocular vision[J].Journal of Applied Optics, 2021, 42(4): 577–585.

[13]郑联语, 付强, 樊伟, 等.基于双目视觉和先验加工数据的大型筒件原位位姿感知方法[J].机械工程学报, 2023, 59(11): 129–146.ZHENG Lianyu, FU Qiang, FAN Wei,et al.In-situ pose measurement method for large cylinders based on binocular vision and prior processing data[J].Journal of Mechanical Engineering, 2023, 59(11): 129–146.

[14]陈冠宇, 成群林, 张解语, 等.基于多传感器测量的航天器舱段自动对接位姿调整方法[J].北京航空航天大学学报, 2019,45(6): 1232–1239.CHEN Guanyu, CHENG Qunlin, ZHANG Jieyu, et al.Multi-sensor measurement based position and pose adjustment method for automatic docking of spacecraft cabins[J].Journal of Beijing University of Aeronautics and Astronautics, 2019,45(6): 1232–1239.

[15]CHEN Y, MEDIONI G.Object modeling by registration of multiple range images[C]//Proceedings of 1991 IEEE International Conference on Robotics and Automation.Piscataway,NJ: IEEE, 1991: 2724–2729.

[16]FISCHLER M A, BOLLES R C.Random sample consensus: A paradigm for model fitting with applications to image analysis and automated cartography[J].Readings in Computer Vision, 1987: 726–740.

[17]SERAFIN J, GRISETTI G.NICP: Dense normal based point cloud registration[C]//2015 IEEE/RSJ International Conference on Intelligent Robots and Systems(IROS).Piscataway, NJ: IEEE, 2015: 742–749.

[18]任伟建, 高梦宇, 高铭泽, 等.基于混合算法的点云配准方法研究[J].吉林大学学报(信息科学版), 2019, 37(4): 408–416.REN Weijian, GAO Mengyu, GAO Mingze,et al.Research on point cloud registration method based on hybrid algorithm[J].Journal of Jilin University (Information Science Edition), 2019,37(4): 408–416.

[19]LIU Y H.Automatic registration of overlapping 3D point clouds using closest points[J].Image and Vision Computing, 2006,24(7): 762–781.

[20]GELFAND N, IKEMOTO L,RUSINKIEWICZ S, et al.Geometrically stable sampling for the ICP algorithm[C]//Fourth International Conference on 3-D Digital Imaging and Modeling.Piscataway, NJ: IEEE, 2003: 260–267.

[21]WEIK S.Registration of 3-D partial surface models using luminance and depth information[C]//Proceedings of International Conference on Recent Advances in 3-D Digital Imaging and Modeling.Piscataway, NJ: IEEE,1997: 93–100.

[22]CHETVERIKOV D, STEPANOV D, KRSEK P.Robust Euclidean alignment of 3D point sets: The trimmed iterative closest point algorithm[J].Image and Vision Computing, 2005,23(3): 299–309.

[23]HAN B C, WU W, WANG Y F, et al.The semi-dense ICP algorithm based on the SIFT feature points neighborhood[J].Journal of Physics:Conference Series, 2020, 1631(1): 012058.

[24]CHEN C S, HUNG Y P, CHENG J B.RANSAC-based DARCES: A new approach to fast automatic registration of partially overlapping range images[J].IEEE Transactions on Pattern Analysis and Machine Intelligence, 1999, 21(11):1229–1234.

[25]MELLADO N, AIGER D, MITRA N J.Super 4PCS fast global pointcloud registration via smart indexing[J].Computer Graphics Forum,2014, 33(5): 205–215.

[26]HUANG J D, KWOK T H, ZHOU C.V4PCS: Volumetric 4PCS algorithm for global registration[C]//ASME 2017 International Design Engineering Technical Conferences and Computers and Information in Engineering Conference.Cleveland, 2017.

[27]DA SILVA J P, BORGES D L, DE BARROS VIDAL F.A dynamic approach for approximate pairwise alignment based on 4-points congruence sets of 3D points[C]//2011 18th IEEE International Conference on Image Processing.Piscataway, NJ: IEEE, 2011: 889–892.

[28]RUSU R B, BLODOW N, BEETZ M.Fast point feature histograms (FPFH) for 3D registration[C]//2009 IEEE International Conference on Robotics and Automation.Piscataway, NJ: IEEE, 2009: 3212–3217.

[29]GUO F, ZHENG W B, LIAN G F,et al.A point cloud registration method based on multiple-local-feature matching[J].Optik, 2023,295: 171511.

[30]AOKI Y, GOFORTH H, SRIVATSAN R A, et al.PointNetLK: Robust & efficient point cloud registration using PointNet[C]//2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).Piscataway, NJ: IEEE, 2019:7156–7165.

[31]YEW Z J, LEE G H.RPM-net: Robust point matching using learned features[C]//2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).Piscataway, NJ:IEEE, 2020: 11821–11830.

[32]ZENG A, SONG S R, NIEßNER M, et al.3DMatch: Learning local geometric descriptors from RGB-D reconstructions[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Piscataway, NJ: IEEE, 2017:199–208.

[33]YI R B, LI J L, LUO L, et al.DOPNet:Achieving accurate and efficient point cloud registration based on deep learning and multi-level features[J].Sensors, 2022, 22(21): 8217.

[34]CHARLES R Q, HAO S, MO K C,et al.PointNet: Deep learning on point sets for 3D classification and segmentation[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Piscataway, NJ: IEEE, 2017:77–85.

[35]QI C R, YI L, SU H, et al.PointNet++[C]//Proceedings of the 31st International Conference on Neural Information Processing Systems.New York: ACM, 2017:5105–5114.

[36]WANG Y, SOLOMON J.Deep closest point: Learning representations for point cloud registration[C]//2019 IEEE/CVF International Conference on Computer Vision (ICCV).Piscataway, NJ: IEEE, 2019: 3522–3531.

[37]CHOY C, PARK J, KOLTUN V.Fully convolutional geometric features[C]//2019 IEEE/CVF International Conference on Computer Vision(ICCV).Piscataway, NJ: IEEE, 2019: 8957–8965.

[38]WANG Y, SUN Y B, LIU Z W, et al.Dynamic graph CNN for learning on point clouds[J].ACM Transactions on Graphics, 2019,38(5): 1–12.

[39]BLANCO-CLARACO J L, MORENODUEÑAS F Á, GONZÁLEZ-JIMÉNEZ J.The Málaga urban dataset: High-rate stereo and LiDAR in a realistic urban scenario[J].International Journal of Robotics Research, 2014, 33(2): 207–214.

[40]DONG Z, YANG B S, LIU Y, et al.A novel binary shape context for 3D local surface description[J].ISPRS Journal of Photogrammetry and Remote Sensing, 2017, 130: 431–452.

[41]DEUGE M D, QUADROS A,HUNG C,et al.Unsupervised feature learning for classification of outdoor 3D scans[C]//Australasian conference on robotics and automation.Sydney,2013.

[42]王水仙, 邓朝晖, 葛吉民, 等.基于工业三维检测的点云配准技术研究进展[J].金刚石与磨料磨具工程, 2023, 43(3): 285–297.WANG Shuixian, DENG Zhaohui, GE Jimin,et al.Research progress of point cloud registration technology based on industrial 3D inspection[J].Diamond & Abrasives Engineering, 2023, 43(3):285–297.

[43]高继昆, 闫峰, 李季.三坐标测量机在整体叶盘叶片型面检测中的应用[J].航空制造技术, 2015, 58(22): 94–97.GAO Jikun, YAN Feng, LI Ji.Blisk blade profile inspection using CMM[J].Aeronautical Manufacturing Technology, 2015, 58(22): 94–97.

[44]张泽.飞机蒙皮外形结构光扫描测量关键技术研究[D].成都: 四川大学, 2021.ZHANG Ze.Research on key technology of optical scanning measurement of aircraft skin shape structure[D].Chengdu: Sichuan University,2021.

[45]李五朋, 田锡天, 耿俊浩, 等.飞机大部件装配外形数字化组合测量方法[J].航空制造技术, 2018, 61(8): 80–84.LI Wupeng, TIAN Xitian, GENG Junhao,et al.Digital combined measuring technology of aircraft large components outline[J].Aeronautical Manufacturing Technology, 2018, 61(8): 80–84.

[46]ZHOU Z L, LIU W, WU Q, et al.A combined measurement method for large-size aerospace components[J].Sensors, 2020, 20(17):4843.

[47]隋少春, 朱绪胜.飞机整机装配质量数字化测量技术[J].中国科学: 技术科学, 2020,50(11): 1449–1460.SUI Shaochun, ZHU Xusheng.Digital measurement technique for evaluating aircraft final assembly quality[J].Scientia Sinica (Technologica),2020, 50(11): 1449–1460.

[48]崔海华, 漏华铖, 田威, 等.轨道式爬行机器人制孔基准的视觉高精度定位[J].光学学报, 2021, 41(9): 179–188.CUI Haihua, LOU Huacheng, TIAN Wei,et al.High-precision visual positioning of holemaking datum for orbital crawling robot[J].Acta Optica Sinica, 2021, 41(9): 179–188.

[49]毕运波, 徐超, 樊新田, 等.基于视觉测量的沉头孔垂直度检测方法[J].浙江大学学报(工学版), 2017, 51(2): 312–318.BI Yunbo, XU Chao, FAN Xintian, et al.Method of countersink perpendicularity detection using vision measurement[J].Journal of Zhejiang University (Engineering Science), 2017, 51(2):312–318.

[50]张辉, 潘新, 李海伟, 等.面向航空锪窝孔制孔质量的手持式视觉检测方法[J].航空制造技术, 2022, 65(18): 71–78.ZHANG Hui, PAN Xin, LI Haiwei, et al.Hand-held visual inspection method for countersink hole quality measuring during aircraft assembling[J].Aeronautical Manufacturing Technology, 2022, 65(18): 71–78.

[51]王红平, 王宇, 赵世辰, 等.基于十字激光的双目视觉钻铆孔质量检测[J].中国激光, 2022, 49(21): 98–110.WANG Hongping, WANG Yu, ZHAO Shichen, et al.Quality inspection of countersunk holes using binocular vision with crossed laser lines[J].Chinese Journal of Lasers, 2022, 49(21):98–110.

[52]陈璐, 关立文, 刘春, 等.基于结构光三维视觉测量的机器人制孔姿态修正方法[J].清华大学学报(自然科学版), 2022, 62(1): 149–155.CHEN Lu, GUAN Liwen, LIU Chun,et al.Robotic hole drilling attitude correction method based on structured light 3-D visual measurements[J].Journal of Tsinghua University(Science and Technology), 2022, 62(1): 149–155.

[53]房运涛, 王晓东, 徐松, 等.万向支架微小螺纹副自动装配系统[J].中国机械工程, 2022, 33(6): 698–706.FANG Yuntao, WANG Xiaodong, XU Song, et al.Miniature thread pairs automatic assembly system for gimbals[J].China Mechanical Engineering, 2022, 33(6): 698–706.

[54]SUN W F, YI J Y, MA G, et al.A vision-based method for dimensional in situ measurement of cooling holes in aero-engines during laser beam drilling process[J].The International Journal of Advanced Manufacturing Technology, 2022, 119(5): 3265–3277.

[55]ZHUANG Z M, GUO Z J, YE Y A.Research on video target tracking technology based on improved SIFT algorithm[C]//Seventh International Conference on Electronics and Information Engineering.Nanjing, 2017: 225–229.

[56]PANEV S, VICENTE F, DE LA TORRE F, et al.Road curb detection and localization with monocular forward-view vehicle camera[J].IEEE Transactions on Intelligent Transportation Systems, 2019, 20(9): 3568–3584.

[57]王晓东, 崔世鹏, 徐征, 等.面向精密微装配的视觉复合定位[J].光学 精密工程,2023, 31(19): 2857–2866.WANG Xiaodong, CUI Shipeng, XU Zheng, et al.Visual composite positioning for precision microassembly[J].Optics and Precision Engineering, 2023, 31(19): 2857–2866.

[58]ZOU Z X, CHEN K Y, SHI Z W,et al.Object detection in 20 years: A survey[J].Proceedings of the IEEE, 2023, 111(3): 257–276.

[59]LIU L, OUYANG W L, WANG X G,et al.Deep learning for generic object detection:A survey[J].International Journal of Computer Vision, 2020, 128(2): 261–318.

[60]ZHANG K P, ZHANG Z P, LI Z F,et al.Joint face detection and alignment using multitask cascaded convolutional networks[J].IEEE Signal Processing Letters, 2016, 23(10):1499–1503.

[61]BAI Y C, ZHANG Y Q, DING M L,et al.SOD-MTGAN: Small object detection via multi-task generative adversarial network[C]//Computer Vision – ECCV 2018.New York: ACM,2018: 210–226.

[62]REN S Q, HE K M, GIRSHICK R,et al.Faster R-CNN: Towards real-time object detection with region proposal networks[J].IEEE Transactions on Pattern Analysis and Machine Intelligence, 2016, 39(6): 1137–1149.

[63]ZHU Y S, ZHAO C Y, WANG J Q,et al.CoupleNet: Coupling global structure with local parts for object detection[C]//2017 IEEE International Conference on Computer Vision(ICCV).Piscataway, NJ: IEEE, 2017: 4146–4154.

[64]BOCHKOVSKIY A, WANG C Y, LIAO H M.YOLOv4: Optimal speed and accuracy of object detection[EB/OL].[2020–04–23].https://arxiv.org/abs/2004.10934v1.

[65]JOCHER G, STOKEN A, BOROVEC J, et al.Ultralytics/yolov5: V3.1–bug fixes and performance improvements[J/OL].Zenodo,[2020–10–29].DOI: 10.5281/zenodo.4154370.

[66]徐诚极, 王晓峰, 杨亚东.Attention-YOLO: 引入注意力机制的YOLO检测算法[J].计算机工程与应用, 2019, 55(6): 13–23, 125.XU Chengji, WANG Xiaofeng, YANG Yadong.Attention-YOLO: YOLO detection algorithm that introduces attention mechanism[J].Computer Engineering and Applications, 2019,55(6): 13–23, 125.

[67]ZHU X K, LYU S C, WANG X, et al.TPH-YOLOv5: Improved YOLOv5 based on transformer prediction head for object detection on drone-captured scenarios[C]//2021 IEEE/CVF International Conference on Computer Vision Workshops (ICCVW).Piscataway, NJ: IEEE,2021: 2778–2788.

[68]CARION N, MASSA F, SYNNAEVE G, et al.End-to-end object detection with transformers[C]//Computer Vision – ECCV 2020.Cham: Springer International Publishing, 2020:213–229.

[69]CAO X P, YUAN P, FENG B L, et al.CF-DETR: Coarse-to-fine transformers for end-toend object detection[J].Proceedings of the AAAI Conference on Artificial Intelligence, 2022, 36(1):185–193.

[70]DAI L H, LIU H, TANG H, et al.AO2-DETR: Arbitrary-oriented object detection transformer[J].IEEE Transactions on Circuits and Systems for Video Technology, 2023, 33(5):2342–2356.

[71]XIA G S, BAI X, DING J, et al.DOTA: A large-scale dataset for object detection in aerial images[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition.Piscataway, NJ: IEEE, 2018: 3974–3983.

[72]WANG J W, YANG W, GUO H W, et al.Tiny object detection in aerial images[C]//2020 25th International Conference on Pattern Recognition (ICPR).Piscataway, NJ: IEEE, 2021:3791–3798.

[73]LI K, WAN G, CHENG G, et al.Object detection in optical remote sensing images:A survey and a new benchmark[J].ISPRS Journal of Photogrammetry and Remote Sensing, 2020,159: 296–307.

[74]DU D W, WEN L Y, ZHU P F, et al.VisDrone-DET2020: The vision meets drone object detection in image challenge results[C]//Computer Vision–ECCV 2020 Workshops.Cham:Springer International Publishing, 2020: 692–712.

[75]ZHU Z, LIANG D, ZHANG S H, et al.Traffic-sign detection and classification in the wild[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Piscataway,NJ: IEEE, 2016: 2110–2118.

[76]BENENSON R, OMRAN M,HOSANG J, et al.Ten years of pedestrian detection, what have we learned? [C]//Computer Vision–ECCV 2014 Workshops.Cham: Springer International Publishing, 2015: 613–627.

[77]YU X H, GONG Y Q, JIANG N, et al.Scale match for tiny person detection[C]//2020 IEEE Winter Conference on Applications of Computer Vision (WACV).Piscataway, NJ: IEEE, 2020: 1246–1254.

[78]ZHANG S F, XIE Y L, WAN J, et al.WiderPerson: A diverse dataset for dense pedestrian detection in the wild[J].IEEE Transactions on Multimedia, 2019, 22(2): 380–393.

[79]ZHANG S S, BENENSON R,SCHIELE B.CityPersons: A diverse dataset for pedestrian detection[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Piscataway, NJ: IEEE, 2017: 4457–4465.

[80]BONDI E, JAIN R, AGGRAWAL P, et al.BIRDSAI: A dataset for detection and tracking in aerial thermal infrared videos[C]//2020 IEEE Winter Conference on Applications of Computer Vision (WACV).Piscataway, NJ: IEEE,2020: 1736–1745.

[81]RAZAKARIVONY S, JURIE F.Vehicle detection in aerial imagery: A small target detection benchmark[J].Journal of Visual Communication and Image Representation, 2016,34: 187–203.

[82]LIN T Y, MAIRE M, BELONGIE S, et al.Microsoft COCO: Common objects in context[C]//Computer Vision–ECCV 2014.Cham:Springer International Publishing, 2014: 740–755.

[83]陶永, 高赫, 王田苗, 等.移动工业机器人在飞机装配生产线中的应用研究[J].航空制造技术, 2021, 64(5): 32–41, 67.TAO Yong, GAO He, WANG Tianmiao,et al.Application of mobile industrial robot in aircraft assembly production line[J].Aeronautical Manufacturing Technology, 2021, 64(5): 32–41, 67.

[84]程亮, 罗洲, 何赟泽, 等.视觉和激光SLAM发展综述与展望[J].中国测试.[2024–11–13].https://link.cnki.net/urlid/51.1714.TB.20241112.1419.013.CHENG Liang, LUO Zhou, HE Yunze, et al.Overview and prospects for the development of visual and laser SLAM[J].China Measurement& Test.[2024–11–13].https://link.cnki.net/urlid/51.1714.TB.20241112.1419.013.

[85]HALDIMANN R, ORF D.Utilization of a vision system to automate mobile machine tools[J].SAE International Journal of Materials and Manufacturing, 2014, 8(1): 63–66.

[86]李广, 孔飞飞, 王逍遥, 等.基于多视觉传感器融合的装配过程质量移动智能检测技术研究[J].现代制造工程, 2023(4): 116–123.LI Guang, KONG Feifei, WANG Xiaoyao,et al.Research on mobile intelligent inspection technology of assembly process quality based on multi vision sensor fusion[J].Modern Manufacturing Engineering, 2023(4): 116–123.

[87]MUR-ARTAL R, MONTIEL J M M, TARDÓS J D.ORB-SLAM: A versatile and accurate monocular SLAM system[J].IEEE Transactions on Robotics, 2015, 31(5): 1147–1163.

[88]NEWCOMBE R A, LOVEGROVE S J, DAVISON A J.DTAM: Dense tracking and mapping in real-time[C]//2011 International Conference on Computer Vision.Piscataway, NJ:IEEE, 2011: 2320–2327.

[89]TOURANI A, BAVLE H, SANCHEZLOPEZ J L, et al.Visual SLAM: What are the current trends and what to expect?[J].Sensors,2022, 22(23): 9297.

[90]TATENO K, TOMBARI F, LAINA I, et al.CNN-SLAM: Real-time dense monocular SLAM with learned depth prediction[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Piscataway, NJ: IEEE, 2017:6565–6574.

[91]BLOESCH M, CZARNOWSKI J, CLARK R, et al.CodeSLAM - learning a compact, optimisable representation for dense visual SLAM[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition.Piscataway, NJ: IEEE, 2018: 2560–2568.

[92]YANG N, VON STUMBERG L, WANG R, et al.D3VO: Deep depth, deep pose and deep uncertainty for monocular visual odometry[C]//2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).Piscataway, NJ: IEEE, 2020: 1278–1289.

[93]YANG N, WANG R, STÜCKLER J,et al.Deep virtual stereo odometry: Leveraging deep depth prediction for monocular direct sparse odometry[C]//Computer Vision–ECCV 2018.Cham: Springer International Publishing, 2018:835–852.

[94]BESCOS B, FÁCIL J M, CIVERA J, et al.DynaSLAM: Tracking, mapping, and inpainting in dynamic scenes[J].IEEE Robotics and Automation Letters, 2018, 3(4): 4076–4083.

[95]WANG J W, RÜNZ M, AGAPITO L.DSP-SLAM: Object oriented SLAM with deep shape priors[C]//2021 International Conference on 3D Vision (3DV).Piscataway: IEEE, 2021:1362–1371.

[96]LI R H, WANG S, GU D B.DeepSLAM: A robust monocular SLAM system with unsupervised deep learning[J].IEEE Transactions on Industrial Electronics, 2021, 68(4):3577–3587.

[97]BONARINI A, BURGARD W,FONTANA G, et al.RAWSEEDS: Robotics advancement throuhweb-publishing of sensorial and elaborated extensive data sets[C]//In proceedings of IROS.2009.

[98]GEIGER A, LENZ P, STILLER C, et al.Vision meets robotics: The KITTI dataset[J].International Journal of Robotics Research, 2013,32(11): 1231–1237.[9 9] H A N D A A, W H E L A N T,MCDONALD J, et al.A benchmark for RGB-D visual odometry, 3D reconstruction and SLAM[C]//2014 IEEE International Conference on Robotics and Automation (ICRA).Piscataway,NJ: IEEE, 2014: 1524–1531.

[100]STURM J, ENGELHARD N,ENDRES F, et al.A benchmark for the evaluation of RGB-D SLAM systems[C]//2012 IEEE/RSJ International Conference on Intelligent Robots and Systems.Piscataway, NJ: IEEE, 2012: 573–580.

[101]MCCORMAC J, HANDA A,LEUTENEGGER S, et al.SceneNet RGB-D:Can 5M synthetic images beat generic ImageNet pre-training on indoor segmentation? [C]//2017 IEEE International Conference on Computer Vision (ICCV).Piscataway, NJ: IEEE, 2017:2697–2706.

[102]SHI X S, LI D J, ZHAO P P, et al.Are we ready for service robots? the OpenLORISscene datasets for lifelong SLAM[C]//2020 IEEE International Conference on Robotics and Automation (ICRA).Piscataway, NJ: IEEE, 2020:3139–3145.

[103]NGUYEN T M, YUAN S H, CAO M Q, et al.NTU VIRAL: A visual-inertial-ranginglidar dataset, from an aerial vehicle viewpoint[J].International Journal of Robotics Research, 2022,41(3): 270–280.

[104]季旭全, 王君臣, 赵江地, 等.基于机器人与视觉引导的星载设备智能装配方法[J].机械工程学报, 2018, 54(23): 63–72.JI Xuquan, WANG Junchen, ZHAO Jiangdi,et al.Intelligent robotic assembly method of spaceborne equipment based on visual guidance[J].Journal of Mechanical Engineering, 2018, 54(23):63–72.

[105]李鹏程, 张奇, 张大为, 等.融合视觉与力觉的卫星装配误差在线测量与补偿方法[J].航空制造技术, 2023, 66(7): 57–66.LI Pengcheng, ZHANG Qi, ZHANG Dawei,et al.Online measurement and compensation of satellite assembly errors based on vision and force sensing[J].Aeronautical Manufacturing Technology, 2023, 66(7): 57–66.

[106]ZHANG P, KAI Z, et al.High dynamic range 3D measurement based on structured light: A review[J].Journal of Advanced Manufacturing Science and Technology, 2021,1(2): 2021004.

[107]TRIYONOPUTRO J C, WAN W W, HARADA K.Quickly inserting pegs into uncertain holes using multi-view images and deep network trained on synthetic data[C]//2019 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS).Piscataway: IEEE, 2019:5792–5799.

[108]孙阳, 翟雨农, 杨应科, 等.视觉引导的大部件对接移载式定位器入位方法[J/OL].北京航空航天大学学报, [2025–01–05].https://doi.org/10.13700/j.bh.1001–5965.2023.0591.SUN Yang, ZHAI Yunong, YANG Yingke, et al.A visual guide method for large part butt transfer locator placement[J/OL].Journal of Beijing University of Aeronautics and Astronautics,[2025–01–05].https://doi.org/10.13700/j.bh.1001–5965.2023.0591.

[109]王明明, 罗建军, 袁建平, 等.空间在轨装配技术综述[J].航空学报, 2021, 42(1):523913.WANG Mingming, LUO Jianjun, YUAN Jianping, et al.In-orbit assembly technology:Review[J].Acta Aeronautica et Astronautica Sinica, 2021, 42(1): 523913.

[110]刘新玉, 郑联语, 蒋正源, 等.协作机器人辅助的空间展开机构桁架铰链微重力装配[J].计算机集成制造系统, 2023, 29(10):3380–3393.LIU Xinyu, ZHENG Lianyu, JIANG Zhengyuan, et al.Microgravity assembly method for truss hinges of space deployable mechanism assisted by collaborative robot[J].Computer Integrated Manufacturing Systems, 2023, 29(10):3380–3393.

[111]贾庆轩, 段嘉琪, 陈钢.机器人在轨装配无标定视觉伺服对准方法[J].航空学报, 2021, 42(6): 424063.JIA Qingxuan, DUAN Jiaqi, CHEN Gang.Uncalibrated visual servo of space robots performing on-orbit assembly alignment task[J].Acta Aeronautica et Astronautica Sinica, 2021,42(6): 424063.

[112]COLLEWET C, MARCHAND E.Photometric visual servoing[J].IEEE Transactions on Robotics, 2011, 27(4): 828–834.

[113]黄梦洁, 叶磊, 易凡骁, 等.面向机器人控制的直接视觉伺服技术发展综述[J/OL].控制理论与应用.[2024–03–06].https://link.cnki.net/urlid/44.1240.TP.20240229.2228.050.HUANG Mengjie, YE Lei, YI Fanxiao, et al.A review of the development of direct vision servo technology for robot control[J].Control Theory and Applications.[2024–03–06].https://link.cnki.net/urlid/44.1240.TP.20240229.2228.050

[114]SILVEIRA G, MALIS E.Unified direct visual tracking of rigid and deformable surfaces under generic illumination changes in grayscale and color images[J].International Journal of Computer Vision,2010, 89(1): 84–105.

[115]TEULIÈRE C, MARCHAND E.A dense and direct approach to visual servoing using depth maps[J].IEEE Transactions on Robotics,2014, 30(5): 1242–1249.

[116]COLLEWET C, MARCHAND É,CHAUMETTE F.Asservissement visuel basé sur des informations photométriques[C]//16e congrès francophone AFRIF-AFIA Reconnaissance des Formes et Intelligence Artificiell.Amiens, 2008.

[117]AHLIN K, JOFFE B, HU A P, et al.Autonomous leaf picking using deep learning and visual-servoing[J].IFAC-PapersOnLine, 2016,49(16): 177–183.

[118]BATEUX Q, MARCHAND E,LEITNER J, et al.Training deep neural networks for visual servoing[C]//2018 IEEE International Conference on Robotics and Automation (ICRA).Piscataway, NJ: IEEE, 2018: 3307–3314.

[119]GAO J, HE Y Z, CHEN Y M, et al.Learning end-to-end visual servoing using an improved soft actor-critic approach with centralized novelty measurement[J].IEEE Transactions on Instrumentation and Measurement, 2023, 72:2514512.

[120]缪晨萱, 宋迎军, 靳卫兵, 等.基于机器视觉的航空发动机错漏装检测技术[J].航空动力, 2023(6): 54–56.MIAO Chenxuan, SONG Yingjun, JIN Weibing, et al.Misassembly detection technology for aero engine based on machine vision[J].Aerospace Power, 2023(6): 54–56.

[121]王明军, 杨军, 李成山, 等.机器视觉在航空发动机装配过程中的应用研究[J].航空动力, 2024(4): 75–78.WANG Mingjun, YANG Jun, LI Chengshan,et al.Research on the application of machine vision in aero engine assembly process[J].Aerospace Power, 2024(4): 75–78.

[122]董元发, 肖清海, 查靓, 等.手工装配中微小金属件漏装模糊自适应视觉检测方法[J].现代制造工程, 2019(3): 108–114, 147.DONG Yuanfa, XIAO Qinghai, ZHA Jing,et al.Fuzzy adaptive vision inspection method for micro metal parts leakage in manual assembly[J].Modern Manufacturing Engineering, 2019(3):108–114, 147.

[123]王振宇, 张祥春, 严佳, 等.飞机装配过程错漏装检测技术研究进展[J].无损检测, 2024, 46(11): 73–80, 94.WANG Zhenyu, ZHANG Xiangchun, YAN Jia, et al.Progress in detection technology of errors and omissions in aircraft assembly process[J].Nondestructive Testing Technologying, 2024,46(11): 73–80, 94.

[124]李静寅.车载导航仪自动装配线视觉检测与感知[D].杭州: 浙江大学, 2021.LI Jingyin.Visual detection and perception of automatic assembly line of vehicle navigator[D].Hangzhou: Zhejiang University, 2021.

[125]BURRESI G, LORUSSO M,GRAZIANI L, et al.Image-based defect detection in assembly line with machine learning[C]//2021 10th Mediterranean Conference on Embedded Computing (MECO).Piscataway, NJ: IEEE, 2021:1–5.

[126]WU Y, LU Y J.An intelligent machine vision system for detecting surface defects on packing boxes based on support vector machine[J].Measurement and Control, 2019, 52(7–8): 1102–1110.

[127]LI Y H, WU T, HAN Y, et al.Recognition of incorrect assembly of internal components by X-ray CT and deep learning[J].Nuclear Instruments and Methods in Physics Research Section A: Accelerators, Spectrometers,Detectors and Associated Equipment, 2019, 920:88–94.

[128]张悦, 孙胜利, 刘会凯, 等.航天器制造过程多余物控制机器视觉方法综述[J].计算机测量与控制, 2019, 27(2): 1–5, 51.ZHANG Yue, SUN Shengli, LIU Huikai, et al.A survey of machine vision methods for control of remainders in intelligent manufacturing process of aerospace products[J].Computer Measurement& Control, 2019, 27(2): 1–5, 51.

[129]刘会凯, 孙胜利, 张悦, 等.基于机器视觉技术的多余物控制方法综述[J].航空精密制造技术, 2019, 55(1): 15–18.LIU Huikai, SUN Shengli, ZHANG Yue,et al.Survey of control methods for remainders based on machine vision technology[J].Aviation Precision Manufacturing Technology, 2019, 55(1):15–18.

[130]陈静.复杂背景下器件多余物成像检测的若干关键技术研究[D].武汉: 华中科技大学, 2010.CHEN Jing.Research on some key technologies of imaging detection of device redundancy in complex background[D].Wuhan:Huazhong University of Science and Technology,2010.

[131]ZHAO Q J, KONG Y H, SHENG S J, et al.Redundant object detection method for civil aircraft assembly based on machine vision and smart glasses[J].Measurement Science and Technology, 2022, 33: 105011.

[132]ZHANG X, YANG Y H, HAN Z G, et al.Object class detection: A survey[J].ACM Computing Surveys, 2013, 46(1): 1–53.

[133]史燕燕, 史殿习, 乔子腾, 等.小样本目标检测研究综述[J].计算机学报, 2023,46(8): 1753–1780.SHI Yanyan, SHI Dianxi, QIAO Ziteng, et al.A survey on recent advances in few-shot object detection[J].Chinese Journal of Computers, 2023,46(8): 1753–1780.

[134]许夙晖, 慕晓冬, 赵鹏, 等.利用多尺度特征与深度网络对遥感影像进行场景分类[J].测绘学报, 2016, 45(7): 834–840.XU Suhui, MU Xiaodong, ZHAO Peng, et al.Scene classification of remote sensing image based on multi-scale feature and deep neural network[J].Acta Geodaetica et Cartographica Sinica, 2016, 45(7): 834–840.

[135]易炟, 陈东方, 王晓峰.基于特征耦合注意力机制的小样本目标检测方法[J/OL].计算机技术与发展, 2024: 1–8.[2024–12–10].http://kns.cnki.net/KCMS/detail/detail.aspx? filename=WJFZ20241209005&dbname=CJFD&dbcode=CJ FQ.YI Da, CHEN Dongfang, WANG Xiaofeng.Small sample target detection method based on feature coupling attention mechanism[J/OL].China Industrial Economics, 2024: 1–8.[2024–12–10].http://kns.cnki.net/KCMS/detail/detail.aspx? fi lename=WJFZ20241209005&dbname=CJFD&db code=CJFQ.

[136]张紫茵, 邢砾云, 张瑾, 等.太赫兹复合材料无损检测技术及其应用[J].太赫兹科学与电子信息学报, 2015, 13(4): 562–568.ZHANG Ziyin, XING Liyun, ZHANG Jin,et al.Terahertz composite nondestructive testing technology and application[J].Journal of Terahertz Science and Electronic Information Technology,2015, 13(4): 562–568.

[137]JUN J, JHANG K Y.Indirect method for measuring absolute acoustic nonlinearity parameter using surface acoustic waves with a fully non-contact laser-ultrasonic technique[J].Applied Sciences, 2020, 10(17): 5911.

[138]吴昊, 刘志平, 杜勇, 等.超声红外热波成像在CFRP板螺栓孔损伤检测的研究[J].红外技术, 2019, 41(8): 786–794.WU Hao, LIU Zhiping, DU Yong, et al.Study on damage detection of bolt holes in CFRP plate by ultrasonic infrared thermal wave imaging[J].Infrared Technology, 2019, 41(8): 786–794.

[139]KHANNA N, PUSAVEC F,AGRAWAL C, et al.Measurement and evaluation of hole attributes for drilling CFRP composites using an indigenously developed cryogenic machining facility[J].Measurement, 2020, 154:107504.

[140]KATUNIN A, WRONKOWICZKATUNIN A, DRAGAN K.Impact damage evaluation in composite structures based on fusion of results of ultrasonic testing and X-ray computed tomography[J].Sensors, 2020, 20(7): 1867.

[141]XU Y F, HAO H B, CITRIN D S, et al.Three-dimensional nondestructive characterization of delamination in GFRP by terahertz time-of-flight tomography with sparse Bayesian learning-based spectrum-graph integration strategy[J].Composites Part B:Engineering, 2021, 225: 109285.

[142]孙保燕, 陈文.三维激光扫描和红外检测融合技术的工程应用[J].长江科学院院报, 2020, 37(2): 170–173, 178.SUN Baoyan, CHEN Wen.Engineering applications of fusion of 3D laser scanning and infrared detection technology[J].Journal of Yangtze River Scientific Research Institute, 2020,37(2): 170–173, 178.

[143]WANG Q, LIU Q H, XIA R C,et al.Automatic defect prediction in glass fiber reinforced polymer based on THz-TDS signal analysis with neural networks[J].Infrared Physics& Technology, 2021, 115: 103673.