航空发动机运行过程中需要通过可调静子叶片(Variable stator vane,VSV)调节机构实现航空发动机压气机的安全稳定运行和高效输出。其中连杆是调节静子叶片角度的重要部件,其装配紧固性不良会导致VSV 调节机构的控制失效,甚至会导致发动机的喘振或停车[1–2]。在发动机的装配、检测、维护等各个环节中,需要对连杆的装配紧固性进行质量控制。为保证连杆紧固性,需要安装防松钢丝,目前仍由人工观察螺纹旋向来确定防松钢丝的安装方向,但人工检错费时费力且易出错。因此,急需一种智能检错方法来代替人工检错,从而提高检错的准确性和可靠性。

目前许多研究者致力于装配正确性视觉检测的研究,以提高装配效率和质量,降低人工经验对装配和检测环节的影响。传统采用的检测方法有模板匹配、角点检测、SIFT 特征点匹配及人工特征提取[3]等,这些方法在复杂背景下的装配检测过程中难以发挥良好的作用。近年来,基于深度学习的目标识别技术在复杂背景情况下的检测识别准确率和效率均大幅度提升,尤其从He 等[4]利用残差连接提出ResNet 后,深度学习开始迅速发展,使后续Mask-RCNN[5]、YOLO[6]、RetinaNet[7]等目标检测器在ImageNet、MS COCO 等大规模图像数据集上相较于传统算法表现出绝对优势,因此基于深度学习的方法在装配正确性视觉检测中的研究也越来越多。赵耀霞等[8]使用深度卷积神经网络对内部工件进行分类,结合工件投影角度检测,完成了对工件内部零件缺漏和错位的识别。魏中雨等[9]先使用Mask-RCNN 网络对装配零件进行分类和定位来判断是否漏装,将零件分割图二值化、Canny 算子提取轮廓后,利用图像的Hu 矩特征与正确的零件图像轮廓对比来判断装配是否正确。Sun 等[10]使用YOLOv5s 来识别螺栓、螺母和标记,根据标记偏离的角度来判断螺栓是否松动。Chen 等[11]设计了一个基于深度图像的多视角装配过程深度神经网络,实现了对机械装配过程不同视角新增部件的变化检测,从而判断装配正确性。郭宇杰等[12]使用Faster-RCNN 网络对多角度引信投影图像进行定位分类零构件,根据定位结果进行CT 反演,实现了弹药引信零件的漏缺和错位检测。Li 等[13]设计了一个卷积神经网络并使用增强现实眼镜辅助来检测线缆连接器的孔位识别及其真实装配状态,将孔位分布进行排序后,与每个孔位理想安装状态的分布排序对比得知错/漏装导线孔位。这些研究工作都将深度学习方法运用到装配检测领域中,并取得了良好效果。但目前航空发动机领域的装配质量控制严重依赖人工操作技能,智能化的检测技术滞后于其他工业领域,还缺乏深入研究[14]。

综上考虑,针对航空发动机VSV调节机构的连杆防松钢丝装配状态人工检错效率低且易出错的问题,本文提出一种基于多模型级联的智能检错方法来代替人工检错。首先使用改进的YOLOv5 模型检测连杆与螺纹的位置并进行简单分类,再根据类别不同将原图中对应区域分别送入不同的分类网络,最后对结果进行后处理得出防松钢丝的装配状态是否正确。试验表明本文提出的智能检错方法精度高,可靠性强。

1 问题描述与解决方案

1.1 问题描述与分析

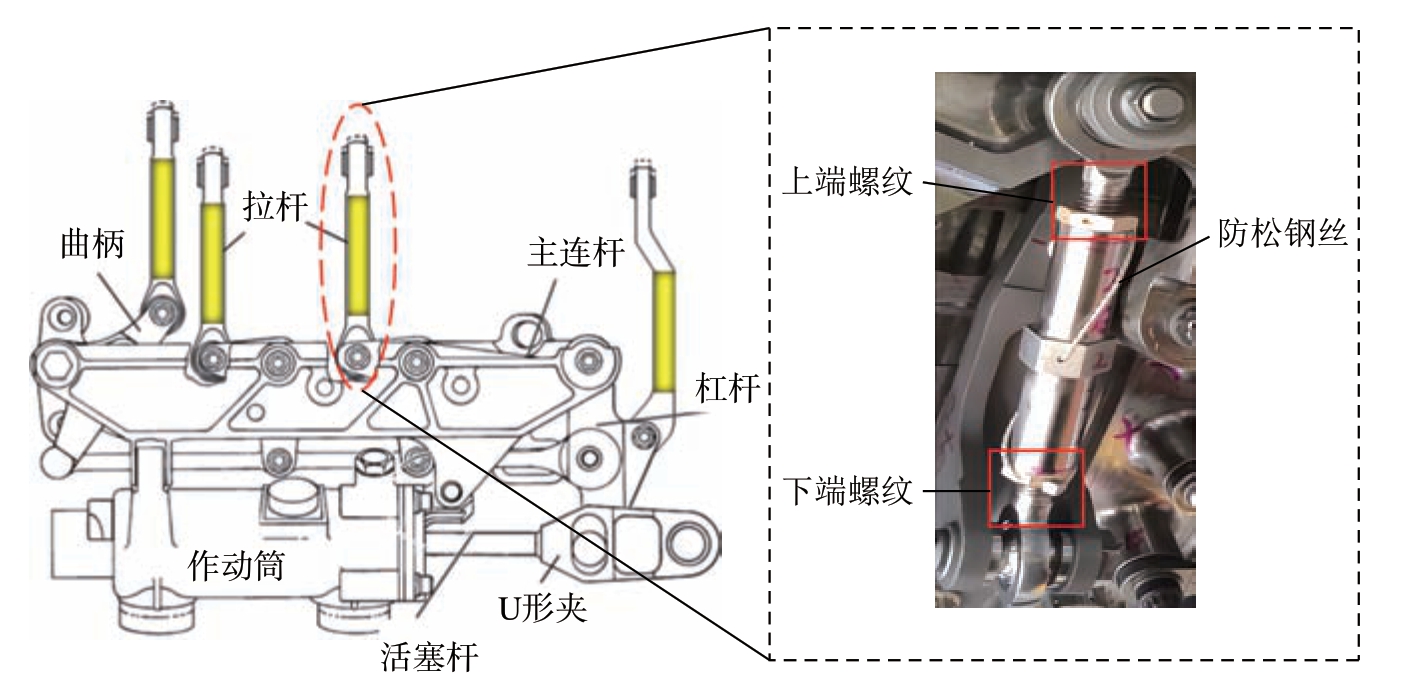

VSV 调节机构连杆作为系统的重要组成部分,位于图1 中的拉杆所在处。连杆由金属杆和两端的鱼眼螺栓组成,其中鱼眼螺栓的规格相同但旋向相反。因此在安装防松钢丝时,应首先确定两端鱼眼螺栓的旋向,连杆上端螺纹是右旋,则下端螺纹必是左旋,防松钢丝应从两端向左连接到中间孔位。

图1 VSV 调节机构连杆示意图

Fig.1 Schematic diagram of the connecting rod of VSV adjusting mechanism

根据上述防松钢丝的安装流程可知,解决防松钢丝的检错问题,需要完成以下任务:检测连杆和螺栓螺纹的位置;识别防松钢丝的安装方向;以及上下螺栓螺纹的旋向。

对于第1 个任务,目前已有很多表现良好的目标检测模型,例如YOLO、Fast-RCNN、SSD[15]等,可以有效地定位连杆和螺栓螺纹的位置。然而,对于后面2 个任务,仅仅依靠这些目标检测模型很难达到较高的精度;这主要有两方面的原因。

(1)类间差别小,分类任务难度大。本文需要识别的防松钢丝安装方向和螺栓螺纹旋向,属于细粒度图像分类的范畴,即对目标进行更加详细的子类划分。例如,防松钢丝的安装方向有向左和向右两种,螺栓螺纹的旋向有左旋和右旋两种。这些类别之间的图像过于形似,甚至进行简单的仿射变换就能轻易转换。而目前的目标检测模型,多数只在粗粒度图像分类方面比较有效,即对类别区分度很大的物体可以进行识别判断。细粒度图像分类由于类间差别小,毫无疑问具有更高的难度[16]。

(2)图像的Resize 操作会丢失目标的部分信息。为了提高检测速度,目标检测模型通常需要将输入图片缩小到一定尺寸,例如YOLOv5 目前推荐的输入是640×640 和1280×1280。本文平板设备采集的图片尺寸为4000×3000,而本文中需要检测的包含鱼眼螺栓上的螺纹则属于小目标纹理特征,因此,过于激进的Resize 操作会改变图像的像素矩阵和频率分布,从而影响纹理特征的表达和提取[17]。

1.2 连杆防松钢丝装配状态的智能检错总体方案

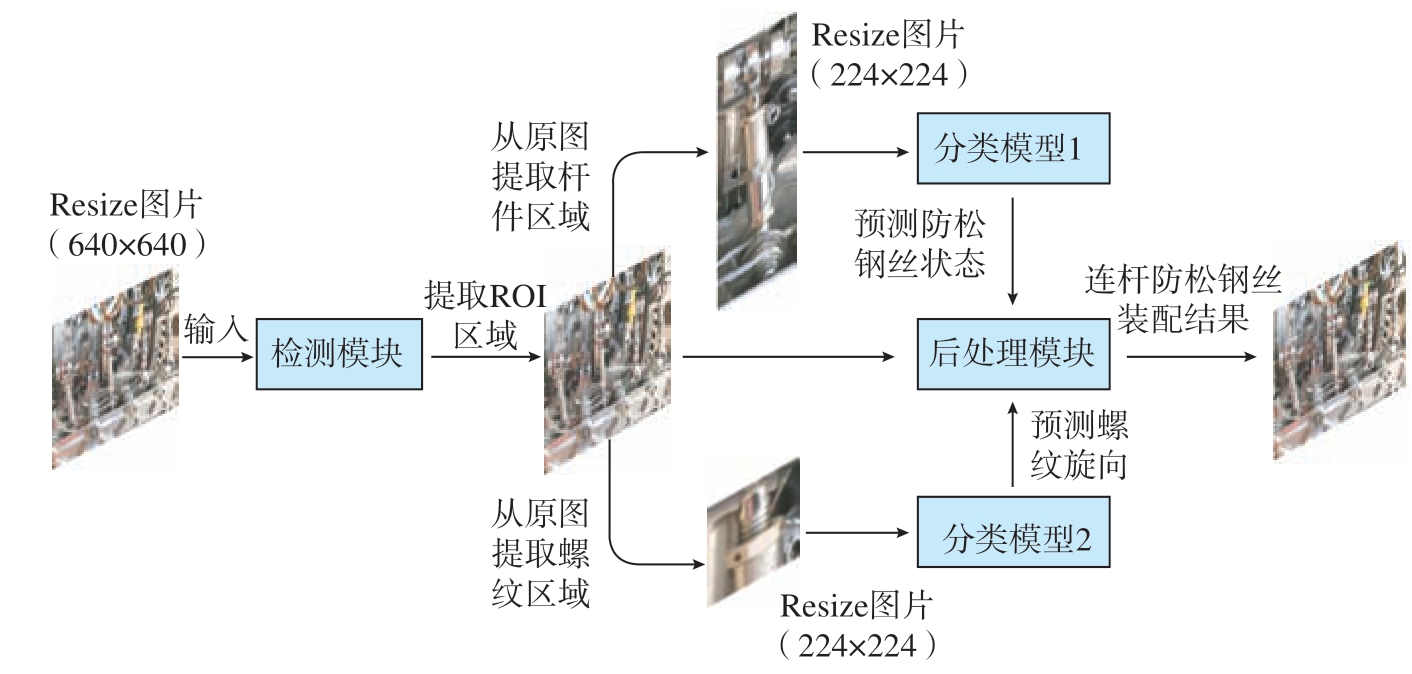

本文提出的连杆防松钢丝装配状态检错方法总体流程主要分为3个部分,由多个卷积神经网络集成,如图2 所示,具体步骤如下。

图2 整体方案流程图

Fig.2 Flowchart of the overall scheme

步骤1。杆件和螺纹目标检测。首先将设备采集到的分辨率为4000×3000 大小的图片Resize 为640×640,作为输入送到检测模块中,该检测模块采用的算法是针对性改进过的YOLOv5 检测模型,用于区分杆件上的鱼眼螺栓螺纹和连杆,并提取其感兴趣区域(Region of interest,ROI)。

步骤2。杆件上防松钢丝安装方向和螺纹旋向分类。从步骤1 中得到检测目标位置后在原图中截取对应的感兴趣区域,按照连杆螺纹类别调整尺寸大小为224×224 后送入对应的分类模型。图2 中两个分类模型均采用的是改进过的ConvNeXt[18]卷积神经网络,其中分类模型1 主要负责识别连杆防松钢丝的有无与安装方向;分类模型2 主要负责识别螺纹旋向。

步骤3。防松钢丝装配状态判定。将上一阶段的分类结果结合起来,得到连杆防松钢丝的装配结果并将其可视化在原图中,具体方法详见2.3 节。

2 算法原理

2.1 基于改进YOLOv5 的检测模块

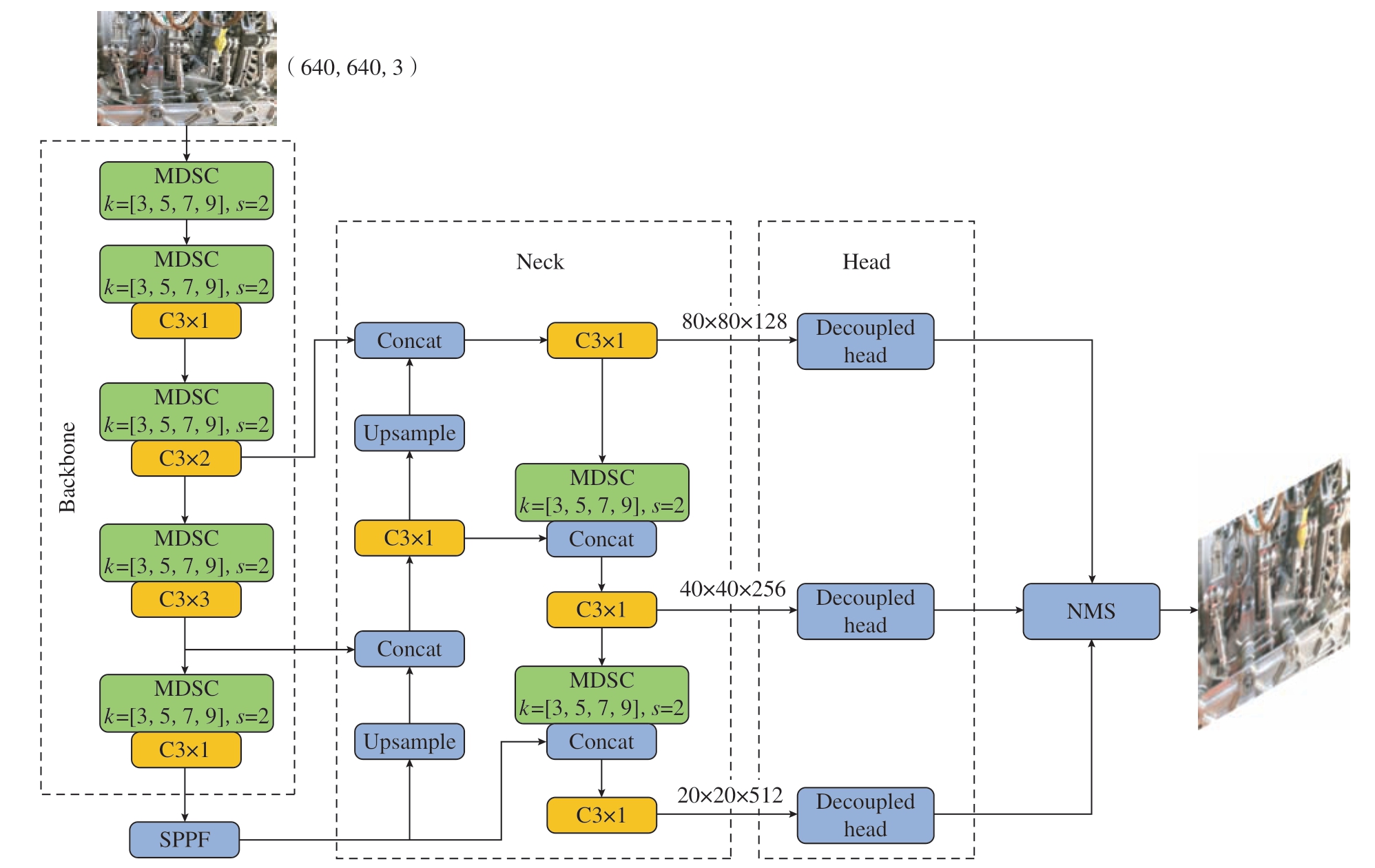

YOLOv5 目标检测算法模型主要由主干特征提取层(Backbone)、特征加强融合层(Neck)和检测头层(Head)3 部分构成,根据模型大小缩放比例有5 个版本:n、s、m、x、l,模型大小也依次增大。图3 为未改进的YOLOv5 的算法原理图。

图3 YOLOv5 算法原理

Fig.3 Principles of the YOLOv5 algorithm

本文所检测目标的背景复杂且目标与背景相似度高依旧会导致算法错/漏检率高。针对这个问题,本文进行了以下改进,具体工作如下。

(1)下采样模块改进。由于模型下采样过程中会丢失大量的关键特征信息,这是造成算法错/漏检的原因之一。为了解决这个问题,本文针对YOLOv5 的下采样模块,设计了混合深度可分离卷积(Mixing depthwise separable convolution,MDSC)模块。该模块使用不同卷积核大小的卷积进行下采样,并按照深度可分离卷积(Depthwise separable convolution,DSC)的方式进行特征融合。这样不仅可以增加整个模型的感受野、优化下采样特征、避免特征信息丢失[19],还可以大大降低模型的参数量和计算量,使模型更加高效。

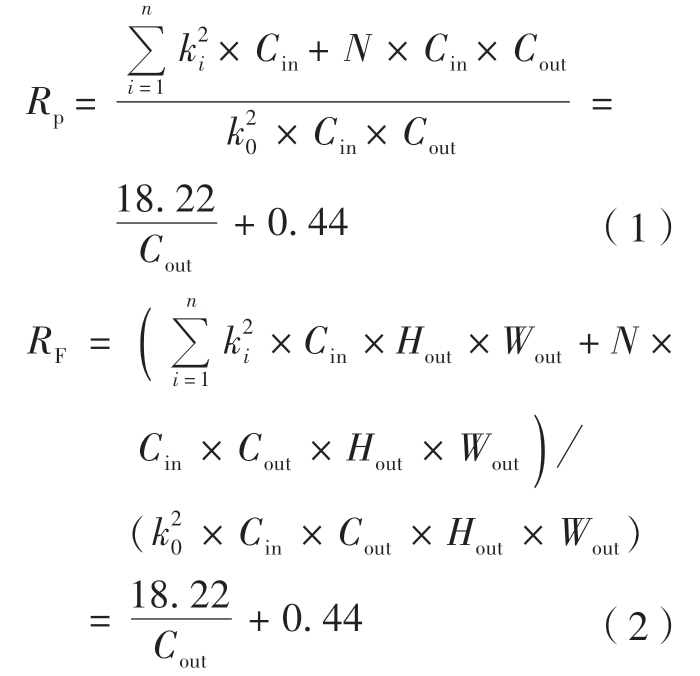

(2)检测头改进。为了解决YOLOv5 检测层中任务耦合和空间不对齐的问题,本文设计了一种轻量化的检测层解耦头,有效地提升了网络检测性能。YOLOv5 的检测层仅使用了1 个1×1 的卷积,将预测框定位、置信度预测和分类3 种任务耦合在一起。这导致定位任务和分类任务的特征不匹配,造成空间不对齐的问题,影响网络检测性能。本文的方法将定位任务和分类任务分离,分别进行特征提取和预测,以实现任务的解耦。与最早针对这个问题改进的YOLOX[20]的解耦头相比,本文的方法在提升性能的同时大大降低了模型的参数量和计算量。

从性能和检测速度方面考虑,选定轻量化的YOLOv5s 版本作为基线模型进行改进,改进YOLOv5s 的结构如图4 所示。

图4 改进YOLOv5s 模型结构图

Fig.4 Structure diagram of the improved YOLOv5s model

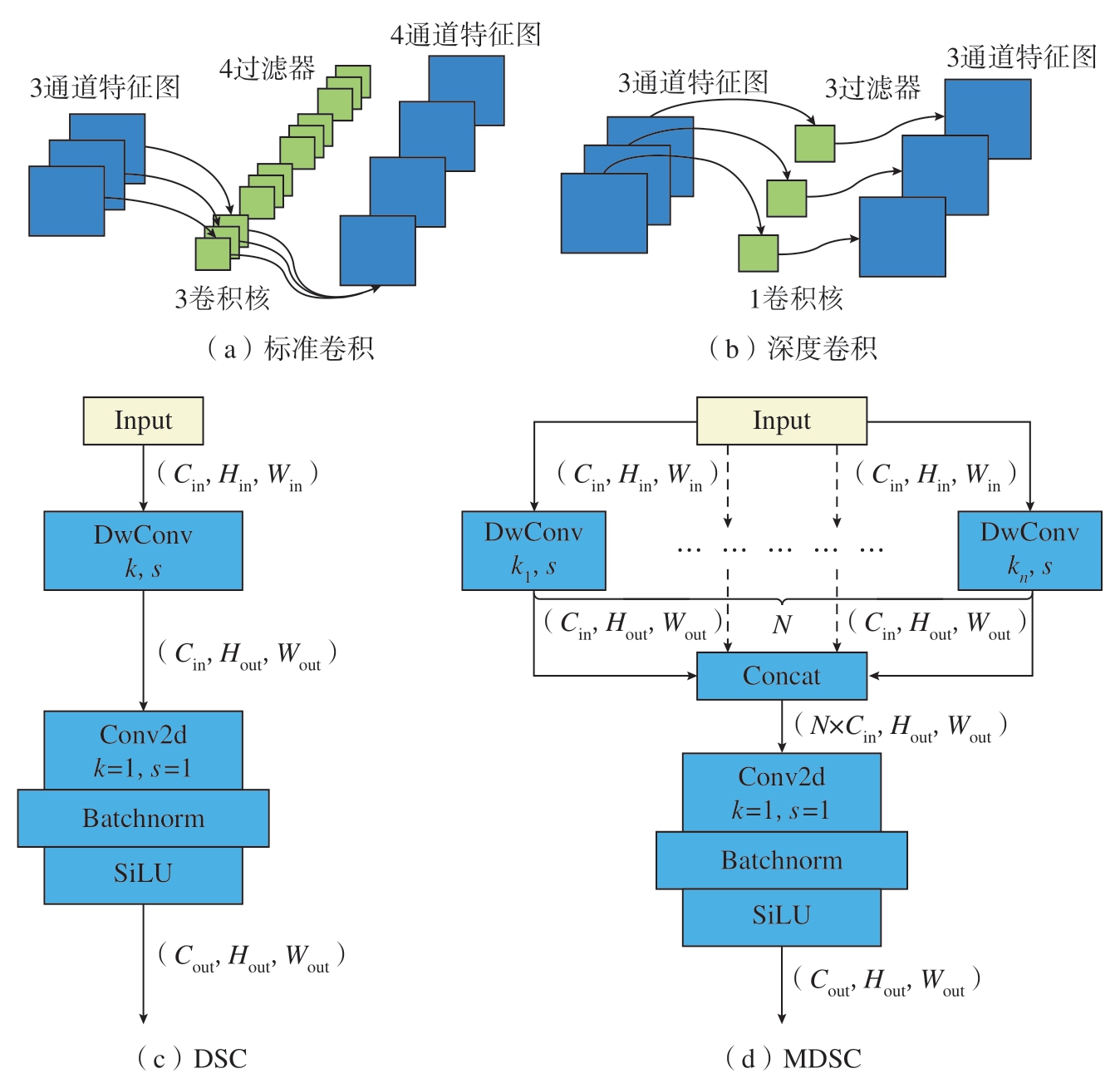

2.1.1 混合深度可分离卷积

标准卷积由若干个过滤器组成,其中过滤器由输入特征图上各通道对应的卷积核组成。图5(a)为3通道输入、4 通道输出的标准卷积过程,标准卷积参数量很大,尤其是模型的深层卷积参数量甚至能达到整个模型参数的一半,此情况下增大卷积核的大小无疑给整个模型带来巨大负担。Google 团队提出的Xception[21]和MobileNet[22]就曾用DSC 来替代标准卷积。DSC 由深度卷积和1×1标准卷积构成。其中,深度卷积(图5(b))每个过滤器只有1 个卷积核且只处理1 张特征图,然后将所有卷积核的输出再进行拼接得到输出特征图。本文在DSC(图5(c))的基础上混合不同大小的卷积核提出MDSC,其结构如图5(d)所示,特征图经过不同卷积核大小的深度卷积后采用1×1 卷积核进行通道融合并改变其输出通道。

图5 不同的卷积结构和原理

Fig.5 Different convolution structures and principles

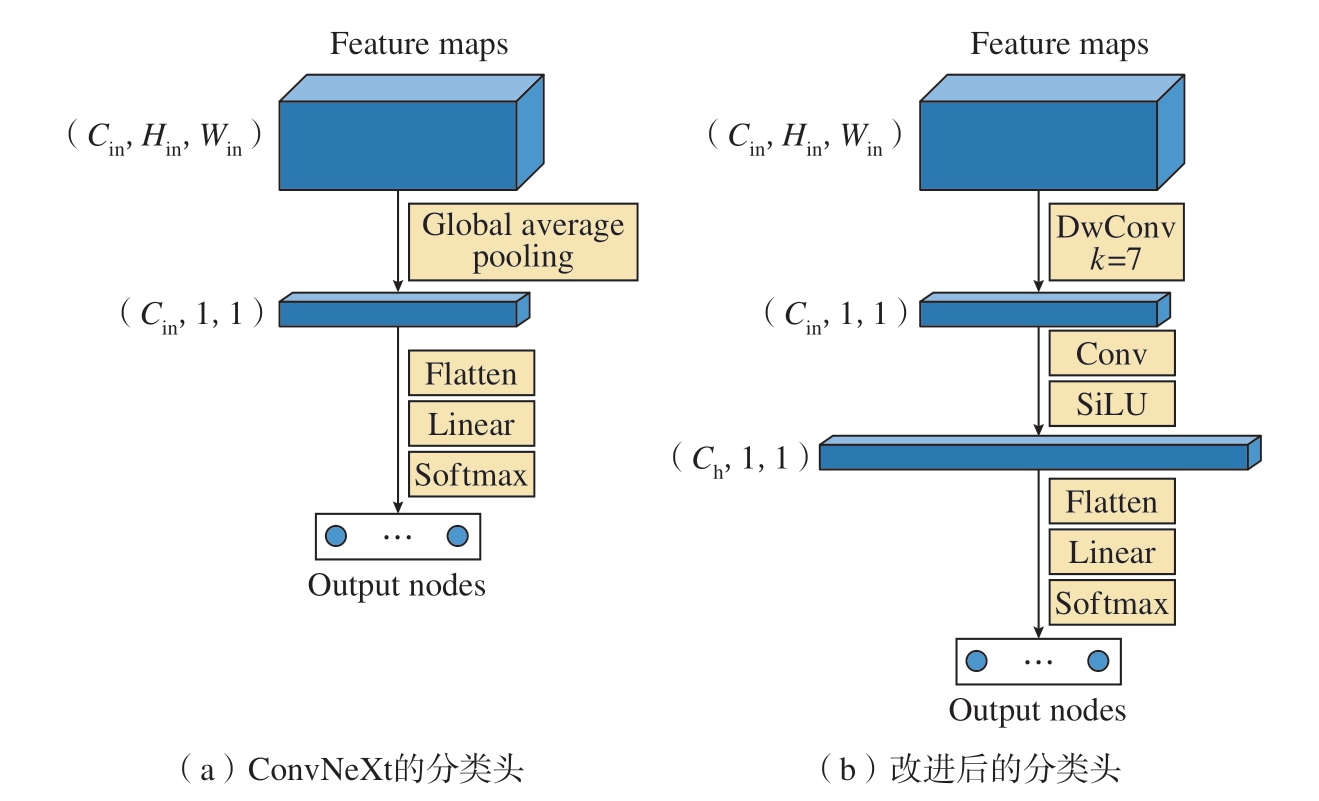

本文使用了3×3、5×5、7×7、9×9 大小的混合卷积核的MDSC 代替3×3 的标准卷积,其参数量之比和计算量之比分别为

式中,Rp、RF 分别为2 种卷积核参数量之比和计算量之比;Cin、Cout 分别为输入、输出特征图通道数;Hout、Wout 分别为输出特征图的高和宽。由计算结果可知,MDSC 参数量与计算量均小于标准卷积且随着网络宽度增大,此现象越明显。

2.1.2 轻量化解耦头

为避免YOLOv5 算法中耦合头在多任务处理的空间中不对齐的问题,本文借鉴了YOLOX 解耦头结构并进行轻量化改进,如图6 所示。在每个分支使用混合了不同大小卷积核的MDSC 来提取特征,最后一层输出特征图上的每一个像素点对应3 个锚框,每个锚框的定位、置信度及分类任务分别由解耦头的3 个分支进行预测。

图6 改进前后解耦头结构对比

Fig.6 Comparison of decoupled head structures before and after improvement

在训练过程中,包含目标的正样本与背景数量的负样本数量差距明显。为解决这个问题,置信度分支上使用了Varifocal Loss[23]来代替二元交叉熵损失,其定义为

式中,q 为目标值大小;p 为预测值大小;α 为负样本权重;γ 为调整因子。

对于前景点,其Ground-truth(已经标注好且正确的数据)的q 被设定为生成的边界框与其Ground-truth之间的交并比(IoU),其中IoU 的计算采用CIoU 算法[24];而对于背景点,所有类的目标q 都设为0。其中Varifocal Loss 仅通过将负样本(q = 0)的损失以p γ 比例化来减少其损失贡献,而不会以同样的方式降低正样本的权重。另一方面,用训练目标q 对正样本进行加权,把训练的重点放在高质量的正样本上。本文试验中α=0.25,γ=1.5。

2.2 基于改进ConvNeXt 的分类模型

基于Transformer 技术的Swin Transformer 在各种大视觉任务中取得了良好的效果,超越了传统的卷积神经网络。然而,FaceBookAI 研究所通过借鉴Swin Transformer 的设计思路[25],基于卷积神经网络改进提出了ConvNeXt。ConvNeXt 不仅在视觉任务上再次刷新了Swin Transformer 的记录,而且在小数据集上也表现出了更好的泛化能力,卷积操作也更适合本文中连杆和螺纹空间关系特征的提取。

因此,选择ConvNeXt 最轻量化的Tiny 版本为基础作为图2 总体方案中的分类模型进行改进,其结构和网络细节如图7 所示。为进一步提升模型的精度,直接沿用ConvNeXt-T网络的Backbone(特征提取层),采用迁移学习的方式加载模型在大规模数据集ImageNet 的预训练权重,并结合改进后的分类头针对特定任务的微调进行训练。迁移学习可以将模型在大数据集上特征提取的性能传递到新模型中,可提高模型的训练效率,避免模型陷入局部最优,从而提升模型的泛化性和鲁棒性。

图7 ConvNeXt 模型网络结构

Fig.7 Network structure of ConvNeXt model

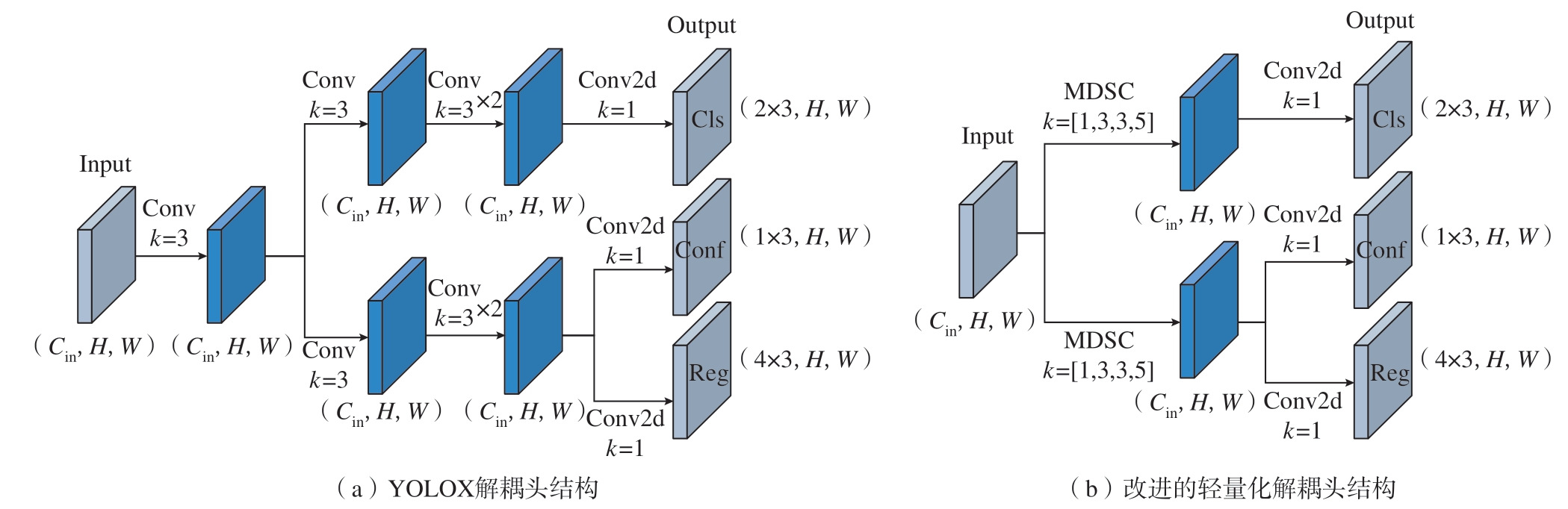

ConvNeXt 模型分类头的结构如图8(a)所示。ConvNeXt 网络主干输出的二维特征图在每一个通道中经过全局平均池化(Global average pooling)后得到一个均值,然后各通道的均值经过展平层(Flatten)、线性连接层(Linear)以及Softmax 归一化层即得到各类别概率值。全局平均池化对于减少模型参数量有一定作用,但会丢失特征图的空间信息,对于细粒度图像分类,尤其是对本文中空间关系分类有很大影响。因此本文对分类头进行了改进,使用深度卷积代替全局平均池化,为增强其非线性分类能力还添加了一层包含SiLU 激活函数的全连接层,具体结构如图8(b)所示。

图8 改进前后分类头结构对比

Fig.8 Comparison of classification head structures before and after improvement

2.3 后处理模块和防松钢丝装配比对检错

为了判别连杆防松钢丝的装配状态,本文采用了以下3 步操作:首先,将无序的螺纹特征框与对应的连杆框进行匹配,并剔除无效的螺纹框和连杆框,以提高检测精度;其次,根据螺纹框的旋向结果,综合判断防松钢丝的装配情况;最后,对比防松钢丝的实际装配状态与理想装配状态,即可得到连杆防松钢丝的装配结果。每步操作的具体过程和原理如下。

2.3.1 螺纹框匹配

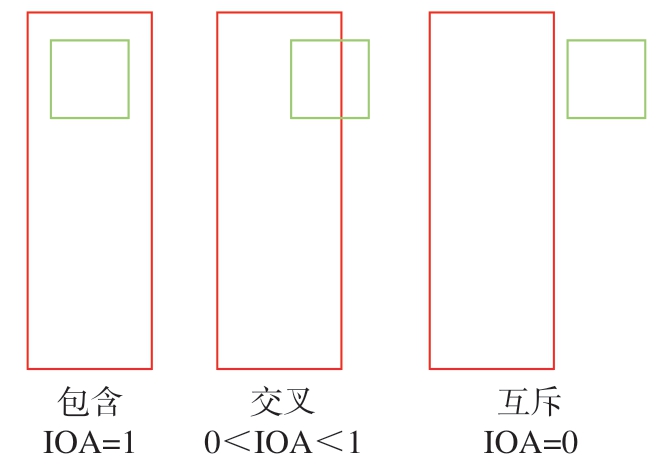

从检测结果和实际情况来看,连杆框与所对应的螺纹框一般属于包含关系,与无关的螺纹框属于互斥关系,但也存在不完全重叠的交叉关系,如图9 所示。考虑到这种交叉情况,本文提出了区域交叉(Intersection of areas,IoA)指标作为连杆框和螺纹框匹配程度的衡量,其值为连杆框与螺纹框重叠面积与螺纹框面积之比,具体计算方式如下

图9 连杆框与螺纹框的不同位置关系与对应的IoA 值

Fig.9 Different position relationships between the connecting rod and threaded anchor frame and the corresponding IoA values

式中,Z 为连杆标签;T 为螺纹标签。以图片左上顶点为原点,(xZ1,yZ1)和(xZ2,yZ2)分别为连杆框左上角和右下角的坐标;(xT1,yT1)和(xT2,yT2)分别为螺纹框左上角和右下角的坐标。

针对交叉重叠的情况,可设定1个IoA 的阈值i,IoA 大于i 则认为该螺纹框与连杆框相匹配,反之则不匹配,本文中i 值设定为0.4。螺纹框的匹配操作完成后,将没有互相匹配的螺纹框、连杆框剔除,这些目标框属于低质量的锚框,剔除后可避免将背景误检为目标框,有助于提高检测准确率。

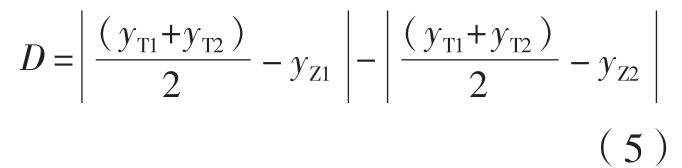

2.3.2 理想装配结果计算

对于连杆框所匹配的螺纹框,首先要确定其在连杆的位置是属于上螺纹或者下螺纹,其衡量标准为螺纹框中心与连杆上边框和下边框的距离之差D,即

D>0 时,螺纹框为下螺纹,反之则为上螺纹。防松钢丝的理想安装方向与下螺纹的旋向同向,与上螺纹旋向异向。每个螺纹框均可判定防松钢丝的理想安装方向,但以类别置信度最高的螺纹框为标准,其类别置信度计算公式为

式中,P(class/object)为分类网络的螺纹旋向预测概率;P(object)为检测网络对于螺纹框的置信度值。

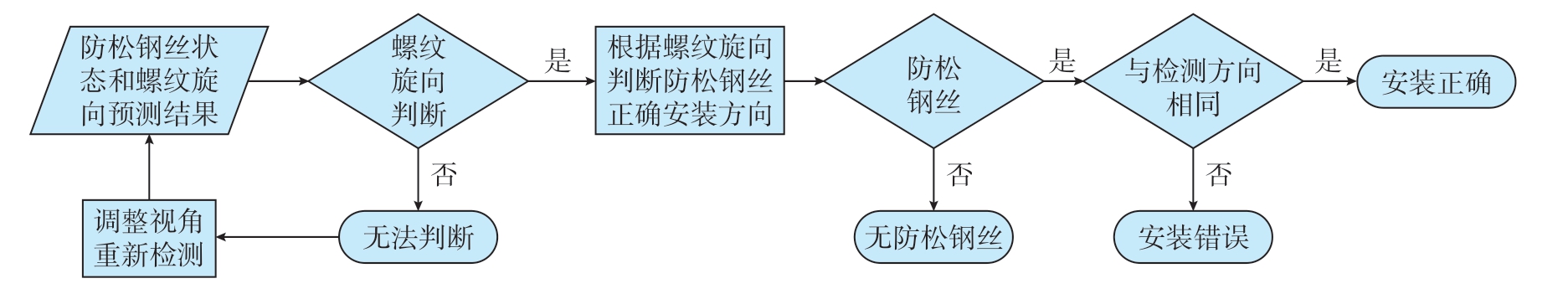

2.3.3 比对检错流程

在螺纹框匹配以及理想装配结果计算完成后,可与实际防松钢丝的装配状态比对进行检错,其比对检错流程如图10 所示。可按照图10 所示流程对防松钢丝的装配质量进行评估,主要分为无法判断、无防松钢丝、防松钢丝安装错误、安装正确4 类。

图10 防松钢丝装配结果比对检错流程图

Fig.10 Flowchart of comparison and error detection of assembly results for anti-loosening wire

3 结果与分析

为了验证本文所提出智能检错方法的优越性能,试验将从3 个方面进行。首先,为体现检测模型性能,对基于YOLOv5 模型的改进方法的有效性进行对比试验;其次,为体现分类模型的性能,分别在螺纹数据集和连杆数据集上进行验证;最后,通过对比不同模型集成方案的检测来验证整体智能检错方案的性能。所有模型训练和检测的环境均为Windows11 操作系统、i5–13500H、32 GB 内存、NVIDIA RTX4050(8 GB显存),深度学习框架PyTorch1.13。数据集采集设备为华为matepad11后置相机,用于训练和测试的数据集采用不同角度、尺度和环境条件的清晰照片和视频关键帧;其中包含少量与检测目标无关的照片作为背景图片。

3.1 连杆和螺纹检测性能分析

3.1.1 数据集信息与试验参数

试验中使用的数据集共有2342张图片,图片尺寸为4160×3120 或1920×1080,按照6:2:2 划分为训练集、验证集与测试集;分为连杆标签Z 和螺纹标签T 2 个类别,数据集相关信息如图11 所示,可知,该数据集特点为类别分布不均衡、大宽高比目标和小目标居多、位置分布较分散。因此,本文中的目标检测任务具有一定的挑战性。为避免模型在小数据集上有过拟合的风险,训练过程中均使用了数据增强以提升模型的鲁棒性,数据增广方式有旋转、错切、平移、缩放、翻转、变换色彩空间、模糊、高斯噪声、Mosaic[26]技术、Mixup[27]技术等,具体效果如图12 所示。为更好地比较各模型性能,主要超参数均要保持一致,试验中均加载了预训练权重,具体超参数如表1 所示。

表1 检测模型在训练过程中的主要超参数

Table 1 Main hyperparameters of the detection model during training

优化算法 初始学习率 IoU 训练轮次 批次大小 权重衰减 图片尺寸 标签平滑[28]SGD 0.01 0.5 300 32 5×10–4 640×640 0.1

图11 数据集相关信息

Fig.11 Information of the dataset

图12 数据增广效果

Fig.12 Data enhancement effect

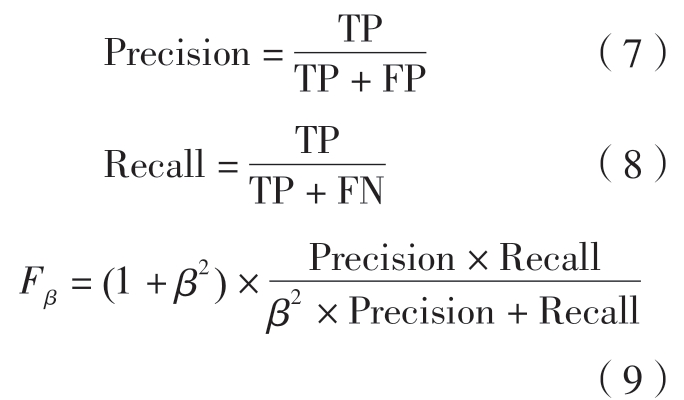

3.1.2 试验评估指标

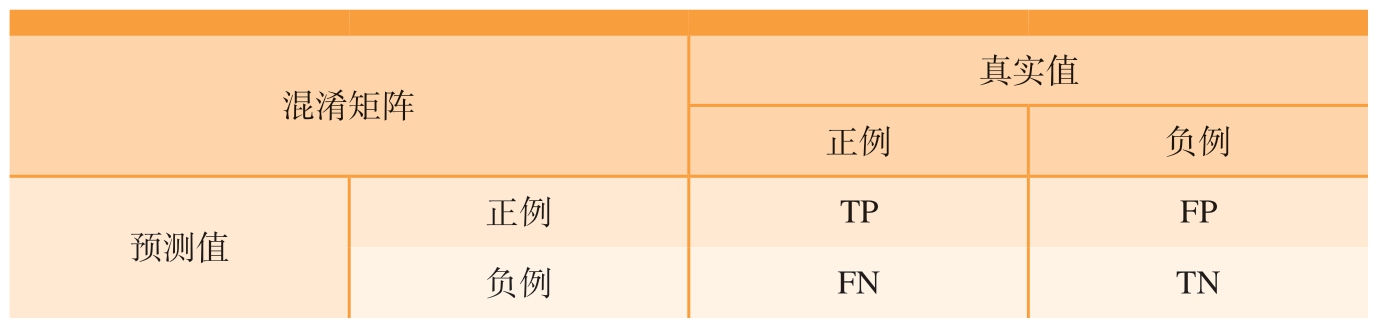

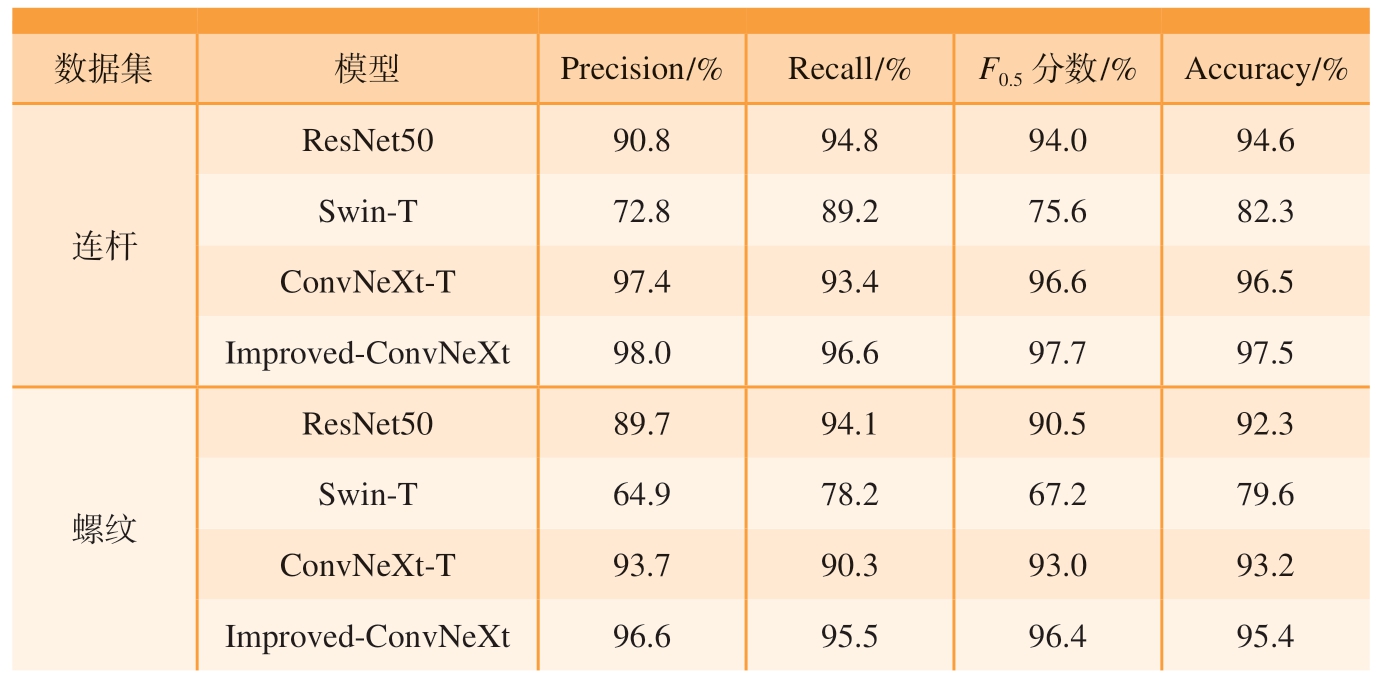

试验采用精确率Precision、召回率Recall、各类别平均精度的均值mAP、模型参数量Param.、计算量GFLOPs 以及F2 分数(即β =2 时的Fβ)作为试验指标。其中参数量和计算量代表着模型复杂度,其大小与模型的检测速度呈负相关;精确度以预测结果为判断依据,即预测为正例的样本中预测正确的比例;召回率以实际样本为判断依据,即实际为正例的样本中被预测为正确的比例;F2 分数是将精确率和召回率进行加权调和来综合反馈模型总体水平的指标。上述指标的计算分别为

式中的TP、FP、FN 含义及关系如表2 所示,Fβ 是一种综合评价精确率和召回率的指标,根据β值的不同,给予两者不同的权重。β值越大,说明召回率的权重越高;β 值越小,说明精确率的权重越高。本文检测任务中更关注召回率,即尽量检测出所有的目标。因此,选择β =2 作为评价标准。同时,为了降低误检的影响,在2.3.1 节的后处理模块中剔除低质量目标。

表2 混淆矩阵

Table 2 Confusion matrix

混淆矩阵真实值正例 负例预测值正例 TP FP负例 FN TN

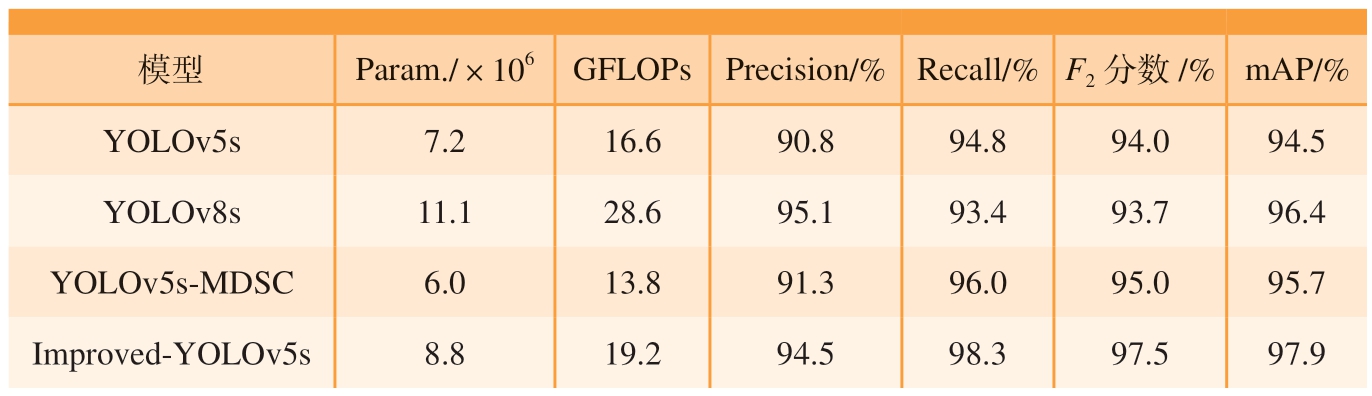

以精确率Precision 为纵坐标轴,召回率Recall 为横坐标轴,可以得到反应模型性能的P–R 曲线。P–R 曲线与坐标轴围成的面积为平均精度AP(mAP),表示为

3.1.3 数据分析

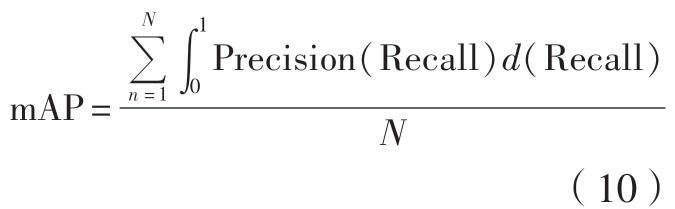

为了验证MDSC 和改进解耦头的性能,以YOLOv5s 原始模型为基准方法,采用消融试验进行验证,参与试验的模型有YOLOv5s、只改进下采样模块的YOLOv5s-MDSC以及同时采用解耦头和MDSC 的Improved-YOLOv5s;与目前最新的目标检测模型YOLOv8[29]进行对比验证,选取YOLOv8s 版本,消融试验对比结果如表3 和图13 所示。

表3 不同模型在测试集上的性能表现

Table 3 Performance of different models on the test set

模型 Param./×106 GFLOPs Precision/% Recall/% F2 分数/% mAP/%YOLOv5s 7.2 16.6 90.8 94.8 94.0 94.5 YOLOv8s 11.1 28.6 95.1 93.4 93.7 96.4 YOLOv5s-MDSC 6.0 13.8 91.3 96.0 95.0 95.7 Improved-YOLOv5s 8.8 19.2 94.5 98.3 97.5 97.9

图13 不同模型在测试集上的P–R 曲线图

Fig.13 P–R curves of different models on the test set

从表3 可以看出,YOLOv8s 在mAP 上所反映的总体性能要高于YOLOv5s 模型,但在连杆螺纹检测任务上的重要指标F2 分数上却稍弱于YOLOv5s,模型参数量与计算量远大于YOLOv5s,因此相较于YOLOv8,YOLOv5无疑更适合本文所提出的检测任务。从消融试验中3 个模型的性能对比可以看出,YOLOv5s-MDSC模型的F2 分数相较于YOLOv5s 模型增大了1%,mAP 增大了1.2%,并且更轻量化;耦合头替换为解耦头的改进使Improved-YOLOv5s 相较于YOLOv5s-MDSC 的F2 分 数、mAP分别增大了2.5%和2.2%,相较于YOLOv5s 的F2 分数和mAP 分别增大了3.5%和3.4%,但参数量和计算量有所增大。这表明针对本文任务所提出的MDSC 模块和解耦头均对基于YOLOv5s 模型的性能有提升效果,Improved-YOLOv5s 的F2 分数和mAP 分别达到了97.5%和97.9%,均高于YOLOv8s 的相应值。且由图13 可知,Improved-YOLOv5s 的P–R曲线完全包围了其他模型,体现了改进YOLOv5s 的良好性能。

3.2 分类模型性能分析

3.2.1 数据集信息和试验参数

本文中分类模型需要对连杆防松钢丝实际安装状态和螺纹旋向进行判别,但这两个任务的难度和数据增广方式有一定差别,为达到最佳分类性能,分别制作了连杆数据集和螺纹数据集,均从检测数据集的目标区域裁剪而来。

连杆数据集共计21276 张图片,按照7:2:1 划分为训练集、验证集和测试集,共分为3 类:防松钢丝向左安装ZL、防松钢丝向右安装ZR 和其他ZH(包含无防松钢丝连杆图片和无关背景图片)。连杆数据集对图片方向有很强的敏感性,因此左右翻转以及大幅度的旋转等数据增广方式均不可使用,试验中采用的数据增广方式有±15°的旋转、色彩空间变换、上下翻转、模糊、直方图均衡化、高斯噪声等。

螺纹数据集共计23158 张图片,同样按照7:2:1 划分为训练集、验证集和测试集,共分为3 类:左旋螺纹TL,右旋螺纹TR 和其他TH(包含无法判别的螺纹和无关背景图片)。螺纹数据集对方向也具有敏感性,但不同的是其数据增广可以进行任意图像旋转但不能进行图像翻转,试验中采用的数据增广方式为旋转、色彩空间变换、模糊、直方图均衡化、高斯噪声等。

为更好地比较各模型性能,主要超参数均要保持一致,试验中均加载了预训练权重,具体超参数如表4 所示。

表4 分类模型在训练过程中的主要超参数

Table 4 Main hyperparameters of the classification model during training

注:Dropout 表示在前向传播中,让某个神经元的激活值以一定的概率p 停止工作,使模型不会太依赖某些局部特征,泛化性更强。

数据集 优化算法 初始学习率 Dropout 训练轮次批次大小权重衰减 图片尺寸 标签平滑连杆 SGD 0.002 0.5 300 64 5×10–4 224×224 0.1螺纹 SGD 0.003 0.5 300 64 5×10–4 224×224 0.1

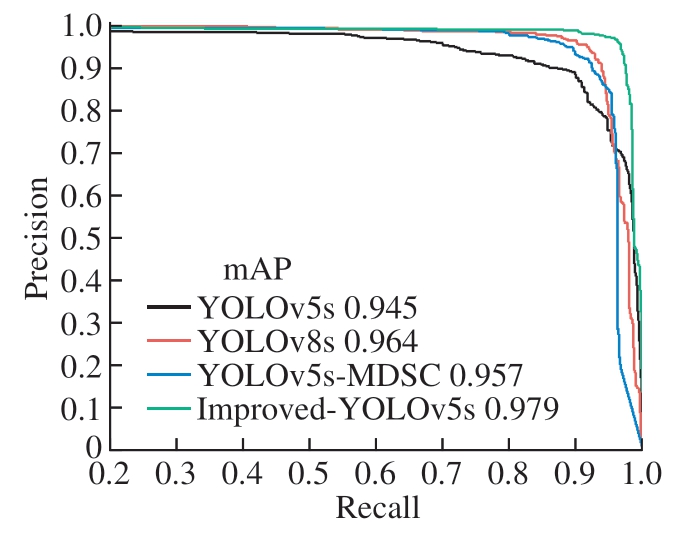

3.2.2 数据分析

本次试验使用的数据集的其他类均包含了与判别任务无关的负样本来提升整体模型的泛化性,因此采用非其他类的精确率Precision、召回率Recall 和更加侧重精确率的F0.5分数以及反映整体性能的总体准确率Accuracy 作为评价指标。其中,总体准确率Accuracy 可表示为

为验证改进ConvNeXt 模型(Improved-ConvNeXt)的性能,试验中比较了经典模型ResNet50、Swin Transformer模型的tiny版本(Swin-T)以及ConvNeXt 模型的Tiny 版本(ConvNeXt-T)在连杆数据集和螺纹数据集测试集上的性能,如表5 所示。

表5 各模型在数据集测试集中的性能表现

Table 5 Performance of different models on the test sets of the data sets

数据集 模型 Precision /% Recall /% F0.5 分数/% Accuracy /%连杆ResNet50 90.8 94.8 94.0 94.6 Swin-T 72.8 89.2 75.6 82.3 ConvNeXt-T 97.4 93.4 96.6 96.5 Improved-ConvNeXt 98.0 96.6 97.7 97.5螺纹ResNet50 89.7 94.1 90.5 92.3 Swin-T 64.9 78.2 67.2 79.6 ConvNeXt-T 93.7 90.3 93.0 93.2 Improved-ConvNeXt 96.6 95.5 96.4 95.4

在这4 个模型中,Swin-T 模型是唯一基于Transformer 技术的神经网络,而其他3 个均为卷积神经网络,但Swin-T 在连杆和螺纹数据集上的性能却远弱于另外3 个卷积神经网络,分析可能的原因是数据集过小导致无法充分发挥Transformer 的性能,另外Transformer 针对本文数据集空间关系特征的提取能力弱,而卷积神经网络的卷积核善于提取纹理特征、空间关系特征。从表5 可以看出,Improved-ConvNeXt 模型在2 个数据集中的各个指标均为最高,其中在连杆数据集中的F0.5 分数和Accuracy 分 别 比ConvNeXt-T 模 型高1.1%和1.0%,在螺纹数据集上则分别高3.4%和2.2%,验证了本文分类头改进的有效性以及其良好的分类性能。

3.3 总体模型集成方案的性能分析

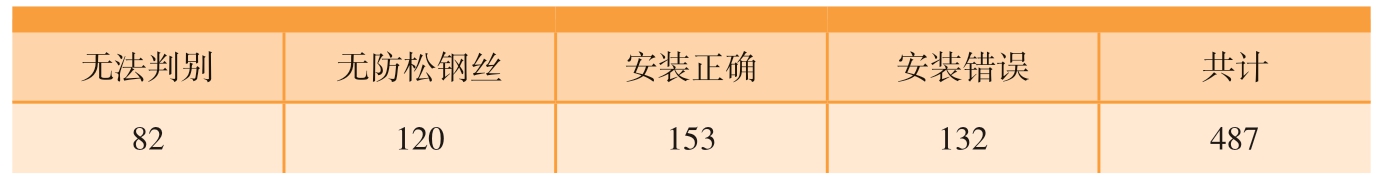

为了测试整个模型方案的泛化性,在航空发动机装配现场实地采集了200 张图片,图片尺寸均为4160×3120,采集过程中要求其拍摄角度均在–25°~25°之间。总体模型集成方案最终结果的数据集分布如表6 所示;以防松钢丝安装方向和螺纹旋向预测分类方式的中间结果如表7所示。

表6 总体模型集成方案最终结果的数据集分布

Table 6 Data set distribution of final results for overall model-integrate scheme

无法判别 无防松钢丝 安装正确 安装错误 共计82 120 153 132 487

表7 总体模型集成方案除后处理外的中间结果的数据集分布

Table 7 Data set distribution of intermediate results excluding the post processing for the overall model-integrate scheme

ZL ZR ZH TL TR TH 共计186 181 120 368 379 227 1461

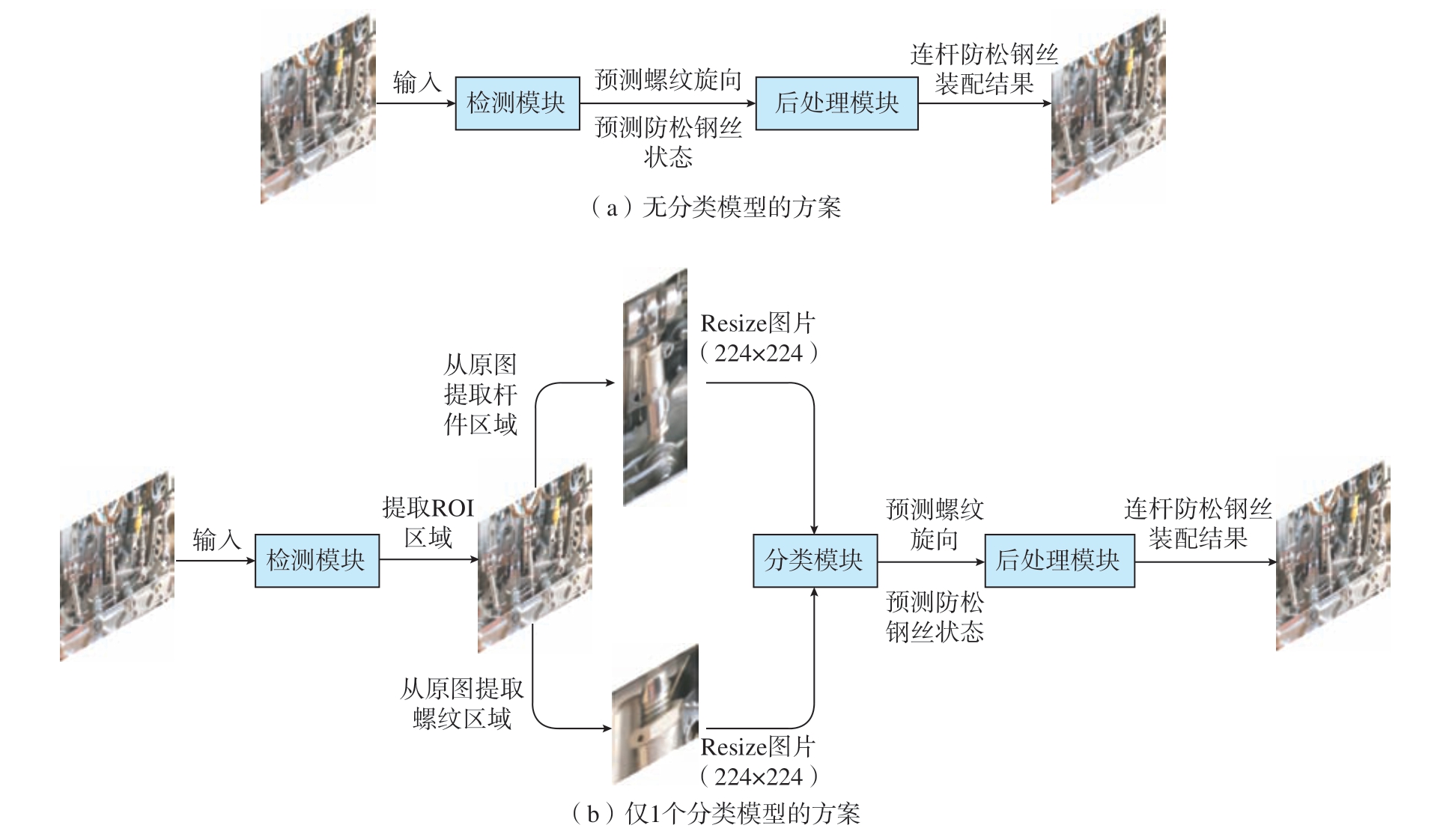

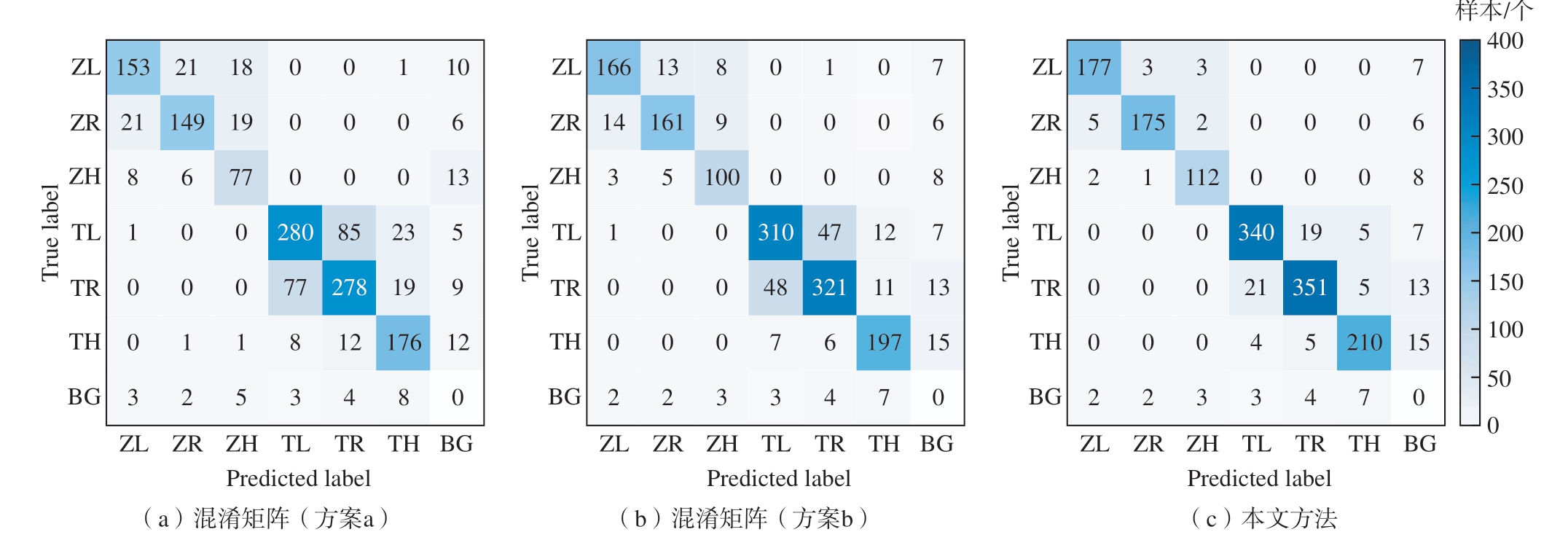

利用该数据集对本文中的多模型集成智能检错方法进行性能测试,并与不同的模型集成方案进行分析比较,其他集成方案的结构如图14所示。其中图14(a)所示方案由检测模型直接输出螺纹旋向类别和防松钢丝状态;而图14(b)方案不同于本文方法的点在于其杆件和螺纹输入到同一个分类模型中进行处理。各方案中间结果分类的混淆矩阵如图15 所示,其中BG 为背景;在最终结果分类上的性能表现如表8 所示。各方案中采用的模型均为本文方法中改进的模型。

表8 不同模型集成方案在最终结果分类上的性能表现

Table 8 Performance of different model-integrate scheme on final outcome classification

方案 图片尺寸 FPS/(帧·s–1)AP/%mAP/%无法判断 无防松钢丝 安装正确 安装错误1280×1280 15.5 86.4 77.5 76.1 78.9 79.7 640×640 28.5 80.4 68.9 73.7 71.8 73.7 b 640×640 11.2 85 82.9 87.3 89.2 86.1本文方法 640×640 9.6 92.1 92.7 92.5 93.6 92.7 a

图14 其他模型集成方案结构图

Fig.14 Structures of other model-integrate schemes

图15 各模型集成方案在中间结果分类中的混淆矩阵

Fig.15 Confusion matrix for each model-integrate scheme on intermediate outcome classification

对于连杆防松钢丝检错任务,若要提高最终判别的准确率,需要检测目标的能力、目标框位置回归和对目标分类均有所提升,由3.2.1 节中的试验结果可知,改进YOLOv5s 在前两项任务中的性能表现良好,并且由表8 可知,改进YOLOv5s 模型在提高了输入图像的分辨率之后,一定程度上缓解了Resize 操作造成的影响,使a 方案的性能有所提高。但从图15 和表8 可以看出,目标检错和漏检的几率依旧很高,并且各类别之间很容易互相混淆,因此无法胜任空间关系的细粒度图像分类。b 方案的分类任务由相同改进的ConvNeXt网络进行处理,其性能有了一定提升,但由于连杆防松钢丝方向分类与螺纹旋向分类两个分类任务耦合在一起造成了类间差距不一致,例如ZL 与TR 的类间差异远大于ZL 与ZR 的类间差异,使模型在训练过程中过分关注类间差异大的类别之间的区分而造成类间差异小的类别相互混淆,图15 中的中间结果混淆矩阵中的数据也可证实这一结果。

而本文提出的智能检错方法解决了1.1 节中分析的两点问题,降低了Resize 操作的影响并提升了相似目标间的分类能力,在最终结果的检错测试中,该方法的mAP 达到92.7%。

4 结论

(1)为替代航空发动机VSV 调节机构连杆的人工检错,本文提出了一种基于多模型级联的智能检错方法。在发动机实际装配环境的测试中,该智能检错方法的模型综合性能mAP 值达到92.7%,表现出良好的性能。

(2)针对连杆和螺纹特征检测任务,选用了YOLOv5s 模型进行改进,提出了MDSC 替代原来下采样模块的标准卷积,设计了一种轻量化的解耦头来代替原来的耦合头。经过试验验证了上述改进均对模型性能有所提升,改进后的YOLOv5s 模型在连杆、螺纹检测数据集上的mAP达到了97.9%,相对于YOLOv5s、YOLOv8s 分别提高了3.4%和1.5%。

(3)针对螺纹旋向分类和连杆防松钢丝实际安装状态分类的问题,二者均采用ConvNeXt-T 模型,使用7×7 的深度卷积取代了分类头的全局平均池化,增强了空间信息,经试验验证其性能得到提升,在连杆分类数据集和螺纹分类数据集上的准确率分别达到97.5%和95.4%。

(4)设计了检测网络和分类网络结果的后处理模块,筛选出质量高的螺纹框和连杆框,并得到最终检错结果,提高了整体模型的泛化性和鲁棒性。

[1] 金帅, 张振兴, 李家瑞, 等.航空发动机喘振故障外场诊断与分析[J].航空发动机, 2021, 47(S1): 53–56.

JIN Shuai, ZHANG Zhenxing, LI Jiarui,et al.Field diagnosis and analysis of aeroengine surge fault[J].Aeroengine, 2021, 47(S1): 53–56.

[2] 崔金辉, 韩鹏江.航空发动机消喘措施试验验证[J].航空发动机, 2022, 48(5):58–64.

CUI Jinhui, HAN Pengjiang.Experimental verification of surge suppression actions for aeroengine[J].Aeroengine, 2022, 48(5): 58–64.

[3] UROUKOV I, SPELLER R.A preliminary approach to intelligent X-ray imaging for baggage inspection at airports[J].Signal Processing Research, 2015, 4: 1.

[4] HE K M, ZHANG X Y, REN S Q, et al.Deep residual learning for image recognition[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition(CVPR).Nevada: IEEE, 2016: 770–778.

[5] HE K M, GKIOXARI G, DOLLAR P,et al.Mask R-CNN[C]//2017 IEEE International Conference on Computer Vision (ICCV).Venice: IEEE, 2017: 2961–2969.

[6] REDMON J, DIVVALA S, GIRSHICK R, et al.You only look once: Unified, real-time object detection[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition(CVPR).Nevada: IEEE, 2016: 779–788.

[7] LIN T Y, GOYAL P, GIRSHICK R, et al.Focal loss for dense object detection[C]//2017 IEEE International Conference on Computer Vision (ICCV).Venice: IEEE, 2017: 2980–2988.

[8] 赵耀霞, 吴桐, 韩焱.基于卷积神经网络的复杂构件内部零件装配正确性识别[J].电子学报, 2018, 46(8): 1983–1988.

ZHAO Yaoxia, WU Tong, HAN Yan.Identifying the correctness of fit of internal components based on a convolutional neural network[J].Acta Electronica Sinica, 2018,46(8): 1983–1988.

[9] 魏中雨, 黄海松, 姚立国.基于机器视觉和深度神经网络的零件装配检测[J].组合机床与自动化加工技术, 2020(3): 74–77,82.

WEI Zhongyu, HUANG Haisong, YAO Liguo.Component assembly inspection based on deep neural network[J].Modular Machine Tool & Automatic Manufacturing Technique,2020(3): 74–77, 82.

[10] SUN Y H, LI M X, DONG R W,et al.Vision-based detection of bolt loosening using YOLOv5[J].Sensors, 2022, 22(14): 5184.

[11] CHEN C J, LI C Z, LI D N, et al.Mechanical assembly monitoring method based on depth image multiview change detection[J].IEEE Transactions on Instrumentation Measurement, 2021, 70: 3096872.

[12] 郭宇杰, 陈平, 魏交统, 等.基于CT 反演的引信装配正确性快速检测技术[J].测控技术, 2023, 42(3): 87–92.

GUO Yujie, CHEN Ping, WEI Jiaotong,et al.Fast detection technology of fuze assembly correctness based on CT inversion[J].Measurement & Control Technology, 2023,42(3): 87–92.

[13] LI S F, ZHENG P, ZHENG L Y.An AR-assisted deep learning-based approach for automatic inspection of aviation connectors[J].IEEE Transactions on Industrial Informatics,2021, 17(3): 1721–1731.

[14] 黄小东, 宁勇, 刘杰, 等.航空发动机智能化装配技术体系构建探索[J].航空发动机, 2020, 46(1): 91–96.

HUANG Xiaodong, NING Yong, LIU Jie,et al.Research on construction of intelligent assembly technology system of aeroengine[J].Aeroengine, 2020, 46(1): 91–96.

[15] LIU W, ANGUELOV D, ERHAN D, et al.SSD: Single shot multibox detector[C]//Proceedings of Computer Vision–ECCV 2016:14th European Conference.Amsterdam: ECCV,2016: 21–37.

[16] WEI X S, SONG Y Z, MAC AODHA O, et al.Fine-grained image analysis with deep learning: A survey[J].IEEE Transactions on Pattern Analysis and Machine Intelligence, 2022, 44(12): 8927–8948.

[17] RUKUNDO O.Effects of image size on deep learning[J].Electronics, 2023,12(4): 985.

[18] LIU Z, MAO H Z, WU C Y, et al.A ConvNet for the 2020s[C]//2022 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).Nevada: IEEE, 2022:11966–11976.

[19] SOOD S, SINGH H.Effect of kernel size in deep learning-based convolutional neural networks for image classification[J].ECS Transactions, 2022, 107(1): 8877–8884.

[20] GE Z, LIU S T, WANG F, et al.YOLOX: Exceeding YOLO series in 2021[EB/OL].(2021–08–06)[2023–12–18].https://doi.org/10.48550/arXiv.2107.08430.

[21] CHOLLET F.Xception: Deep learning with depthwise separable convolutions[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Hawaii: IEEE,2017: 1251–1258.

[22] HOWARD A G, ZHU M L, CHEN B,et al.MobileNets: Efficient convolutional neural networks for mobile vision applications[EB/OL].(2017–04–17)[2023–12–18].https://doi.org/10.48550/arXiv.1704.04861.

[23] ZHANG H Y, WANG Y, DAYOUB F, et al.VarifocalNet: An IoU-aware dense object detector[C]//2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition(CVPR).Tennessee: IEEE, 2021: 8514–8523.

[24] DONG C, DUOQIAN M.Control distance IoU and control distance IoU loss for better bounding box regression[J].Pattern Recognition, 2023, 137: 109256.

[25] LIU Z, LIN Y T, CAO Y, et al.Swin transformer: Hierarchical vision transformer using shifted windows[C]//2021 IEEE/CVF International Conference on Computer Vision(ICCV).Montreal: IEEE, 2021: 10012–10022.

[26] BOCHKOVSKIY A, WANG C Y,LIAO H Y M.YOLOv4: Optimal speed and accuracy of object detection[EB/OL].(2020–04–23)[2023–12–18].https://doi.org/10.48550/arXiv.2004.10934.

[27] ZHANG H, CISSE M, DAUPHIN Y N, et al.Mixup: Beyond empirical risk minimization[EB/OL].(2020–04–23)[2023–12–18].https://doi.org/10.48550/arXiv.1710.09412.

[28] SZEGEDY C, VANHOUCKE V,IOFFE S, et al.Rethinking the inception architecture for computer vision[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Nevada: IEEE, 2016:2818–2826.

[29] LOU H T, DUAN X H, GUO J M,et al.DC-YOLOv8: Small-size object detection algorithm based on camera sensor[J].Electronics,2023, 12(10): 2323.