蒙皮对缝广泛分布于飞机表面,对缝间隙、阶差测量是装配质量检测的重要内容。传统接触式塞规、塞尺对缝检测效率低且会对蒙皮造成损伤。手持式自动化测量设备在一定程度上提高了效率,但仍存在可达性较差、工人操作熟练度要求高等问题[1–4]。因此机器人夹持测量设备的自动化方式受到广泛关注,该方法可以在保证精度的同时提高检测效率[5]。然而,目前机器人运动控制多采用离线编程和示教再现两种模式,其准备工作繁杂、柔性差、跟踪精度差。非接触式对缝结构光视觉检测法因跟踪低成本、抗干扰能力强、精度高等优点而受到众多研究者的关注[6–8]。张洪瑶等[9]通过将离线编程和激光扫描结合提高了对缝检测的自动化程度,但该法离线编程工作量大,无法根据待测目标变化做出相应调整。许大帅等[10]利用结构光测量间隙及阶差,同时采用室内GPS(indoor GPS,iGPS)对传感器进行实时跟踪以快速测得目标数据,但iGPS 设备成本高、对场地要求高。王文辉[11]利用视觉传感技术实现了基于移动机器人的上壁板对缝自主追踪,该系统兼顾对缝跟踪和测量功能,极大提高了测量效率,但由于机器人结构所限,难以用于机身、机头等复杂曲面蒙皮处。

现阶段基于结构光视觉传感器的蒙皮对缝跟踪技术的研究较少。但众多学者对基于传感器引导的自动化焊接展开了大量研究并取得一定成果,该领域的相关研究方法和取得的成功对于实现飞机蒙皮对缝的自主跟踪具有很好的借鉴意义[12–15]。Zou 等[16]将单图像的特征点提取算法和基于时空上下文学习的快速目标跟踪算法结合,实现了焊缝精准跟踪。Tran 等[17]将传统的图像处理方法和时空上下文卡尔曼滤波算法结合,提取焊接过程中激光条纹被大电弧和飞溅噪声阻挡时的焊缝特征点。Guo 等[18]提出一种基于改进目标检测模型中心网的提取方法,能够从有时变噪声的常见焊接图像中准确提取焊缝特征点。

本文提出一种基于结构光视觉传感器的蒙皮对缝跟踪技术。采用传统的形态学方法提取蒙皮对缝特征并确定对缝跟踪区域。针对传统形态学方法实时性不足的问题,利用对缝图像的光流信息来跟踪对缝特征,并在特征点识别偏差较大时提取对缝特征以对光流跟踪模型进行矫正,从而提高精度。构建视觉传感器跟踪位姿求解模型,并结合修正后手眼标定参数准确得到机器人跟踪位置和姿态信息,实现机器人对蒙皮对缝的精准跟踪。

1 对缝跟踪系统架构

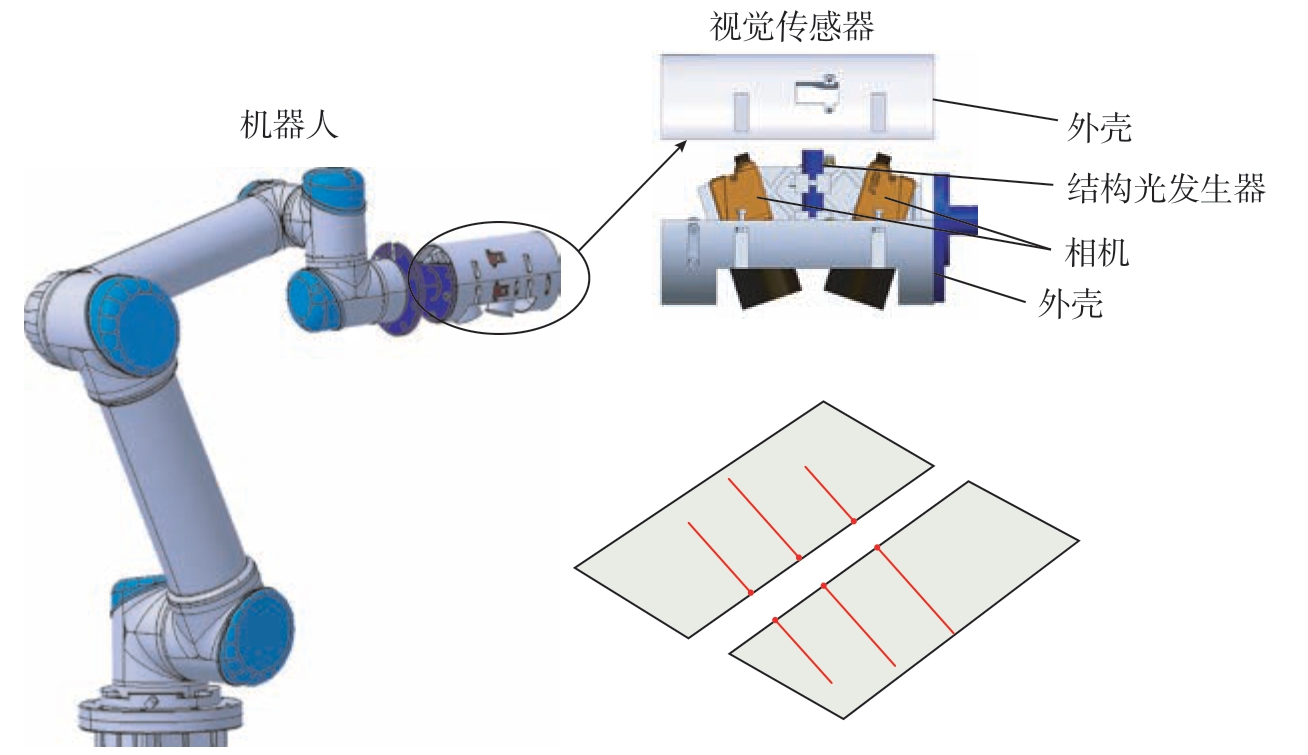

本文设计并搭建了对缝自主跟踪系统,如图1 所示,该系统主要由协作式六轴机器人和结构光视觉传感器构成。视觉传感器由2 个工业相机、1 个三线结构光发生器和上下2 个半圆柱外壳组成。三线结构光与对缝边缘干涉产生的6 个端点蕴含着当前位置对缝的跟踪信息,可根据其坐标计算出机器人的跟踪轨迹和姿态。因此将6 个干涉端点作为对缝特征点,探究如何快速准确地提取出对缝特征点的坐标。

图1 对缝自主跟踪系统架构

Fig.1 Autonomous tracking system architecture of seam

系统工作原理如下。结构光视觉传感器安装在机器人末端,其中,结构光发生器激发的结构光束与蒙皮对缝边缘产生干涉,双目相机用于实时采集结构光对缝干涉图像。从结构光对缝干涉图像中提取对缝特征点后,通过视觉传感器跟踪位姿求解模型计算目标位置和姿态,然后将机器人运动量传输到机器人控制器,便可将机器人引导至目标位置。

2 对缝特征点检测算法

对缝特征提取的精度直接影响到对缝跟踪的精度。传统的形态学方法可以准确地从图像中提取对缝特征点,因此,首先采用传统的形态学方法提取对缝特征点并确定对缝跟踪区域。但是对缝跟踪过程中,传统的形态学方法实时性不足,难以满足蒙皮对缝特征的高效率提取需求。因此,本文使用光流跟踪算法实时计算对缝特征点的位置。

2.1 通过形态学方法提取特征点

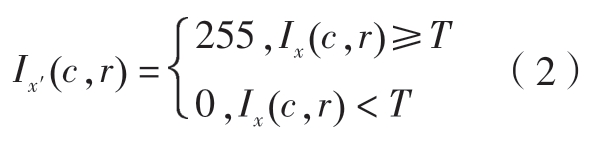

形态学方法可以准确地提取特征点,其算法过程如图2 所示。

图2 基于形态学方法的特征提取算法

Fig.2 Feature extraction algorithm based on morphological methods

首先,对图像进行滤波来抑制图像中的噪声,高斯滤波后的灰度值I1(c,r)为

式中,Src 为5×5 大小,中心为(c,r)的高斯滤镜蒙版;I0(c,r)为滤镜蒙版所覆盖的像素灰度值,即原始图像(c,r)处像素灰度值。

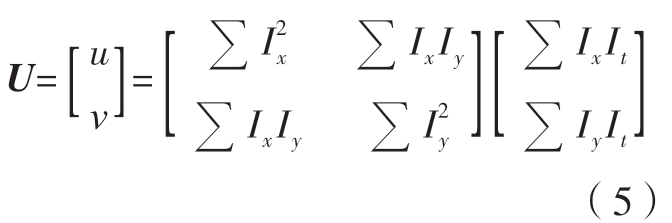

高斯滤波处理后,通过阈值分割将图像中的像素点分割为灰度值为255 和0,以简化后续的图像处理。分割阈值通过最大类间方差法计算得到,设定图像中某一像素点对应的像素灰度值为Ix(c,r),分割阈值为T,则分割后的图像灰度值Ix′(c,r)满足:

大尺寸图像通常会带来巨大的计算负担,并降低对缝跟踪系统的实时性能。采用提取感兴趣区域(Region of interest,ROI)的方法来减小待处理图像的尺寸,设定结构光条纹区域为感兴趣区域,识别出结构光条纹的边界点,并根据边界点坐标进行ROI 提取。由于结构光对缝干涉图像的主要信息分布于结构光条纹的中心处,所以用上述方法提取ROI 可在最大程度上保留图像的有效信息。面对图像中的干扰光条的问题,采用Blob 分析方法计算光条的连通域,去除连通域较小的干扰光条,以此来保证图像关键信息提取的精度,减少数据处理量,简化后续的图像处理工作。

完成以上步骤后,为了准确提取对缝特征点,将结构光条纹替换为结构光条中心线,结构光条中心线提取的精度决定了对缝特征点的提取精度。首先,使用Zhang–Suen 图像细化算法得到光条中心骨架像素点,再采取改进的灰度重心法进行进一步修正,使得结构光条中心线提取的精度达到亚像素级精度。在获得结构光条中心线后,开始提取对缝特征点坐标。观察提取的图像可知,对缝特征点在其邻域中除自身外只有一个灰度值为255 的像素点。根据此特征,遍历图像中的像素点从而提取特征点。使用形态学方法提取对缝特征点的过程如图3 所示。

图3 基于形态学方法的特征提取过程

Fig.3 Feature extraction process based on morphological methods

2.2 通过光流算法提取特征点

Lucas–Kanade 光流法是一种对相邻两帧图像进行差分计算的估计算法。该算法首先在当前帧中选择目标像素点,然后在先前帧中寻找对应点,在两帧之间计算这两个点之间的运动矢量来计算光流。随后,采用运动矢量来更新先前帧位置,并重复这个过程来跟踪目标像素点坐标。使用光流法时,要求被跟踪目标运动量小、相邻两帧图像之间亮度或者颜色恒定、相邻图像像素运动空间一致3 个前提条件。

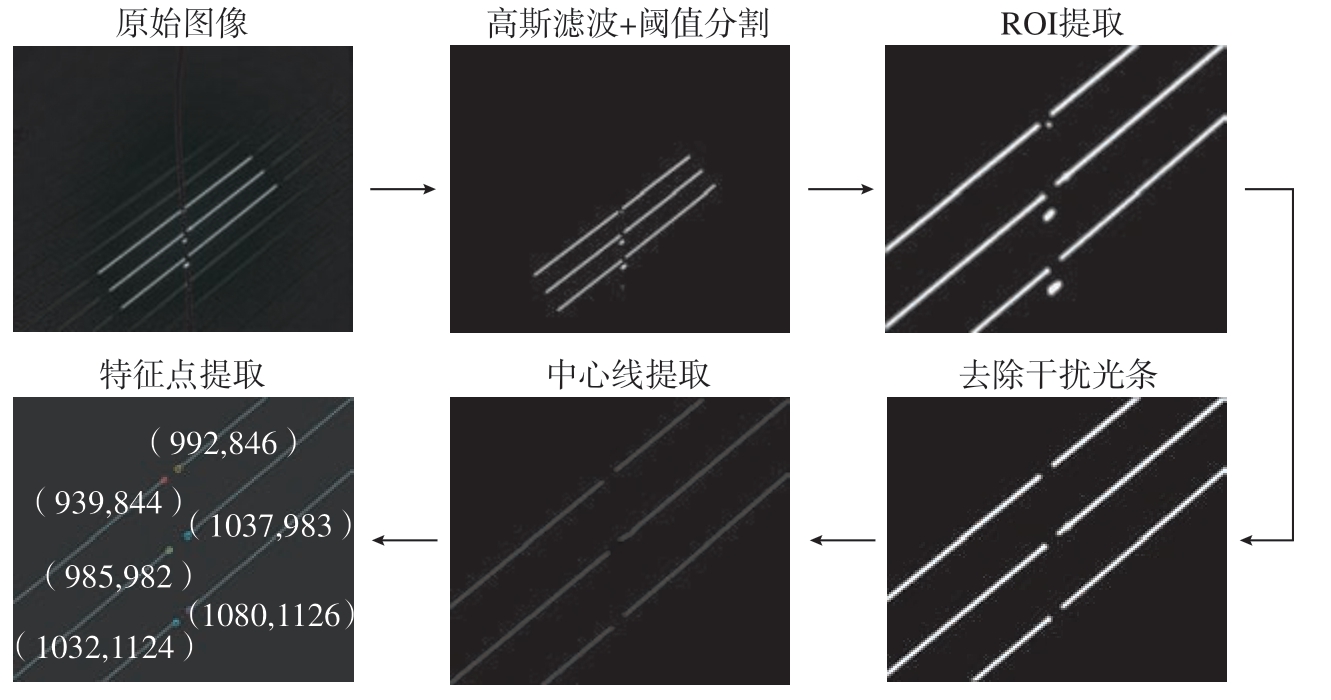

连续采集图像时相邻帧采集时间极短,图像中相关干涉端点的移动微小,即满足目标运动量小这一条件。蒙皮表面的反射率等特性变化较小,相邻帧间的图像中干涉端点的亮度恒定。在对缝跟踪过程中,对缝特征点的周围区域构成了空间环境,其中包括结构光条纹的其他点,相邻两幅图像中结构光条纹的变化非常小。因此,特征点空间背景相对稳定,可保证相邻两帧图像特征点的空间一致性。故由Lucas–Kanade 光流法得到

式中,I(x,y,t)是图像特征点(x,y)在t 时刻的灰度值,I(x+Δx,y+Δy,t+Δt)是在t+Δt 时刻运动到新位置(x+Δx,y+Δy)处的灰度值。在运行过程中,相邻帧之间图像特征点运动微小且连续,所以可对上式进行一阶泰勒展开,忽略二阶无穷小,可推导得光流约束方程如下

式中,![]() 分别表示x、y

分别表示x、y![]() 方向的光流速度;

方向的光流速度;![]() 分别代表像素灰度值对x、y、t 的偏导数。相邻帧之间的物体表面形貌近似恒定,由此可以得出局部区域的像素点具有空间一致性,建立邻域像素的系统方程以求解中心像素的运动,即获取两帧图像间该点的光流矢量为

分别代表像素灰度值对x、y、t 的偏导数。相邻帧之间的物体表面形貌近似恒定,由此可以得出局部区域的像素点具有空间一致性,建立邻域像素的系统方程以求解中心像素的运动,即获取两帧图像间该点的光流矢量为

由此可得相邻两帧的特征点坐标关系为

式中,Pi 是第i 帧特征点在图像坐标系中的坐标;Pi+1 是第i+1 帧特征点在图像坐标系中的坐标;U 是第i 帧图像到第i+1 帧图像的光流矢量。将上述方法应用于对缝特征点,即可实现对6 个对缝特征点的逐帧实时跟踪。

2.3 对缝特征点检测算法流程

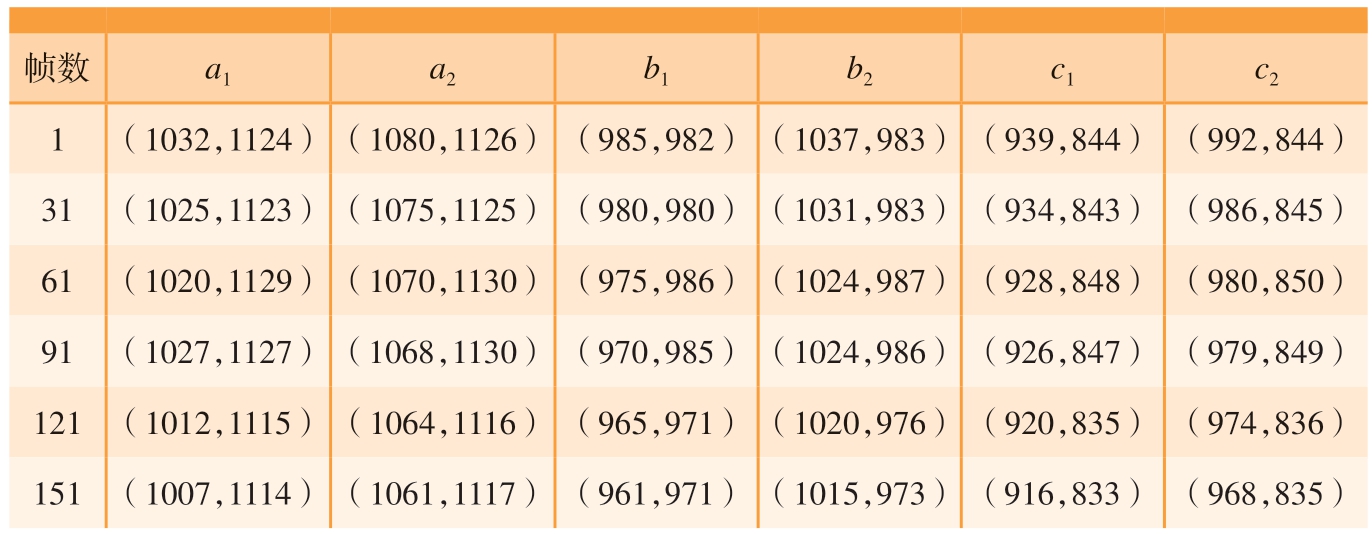

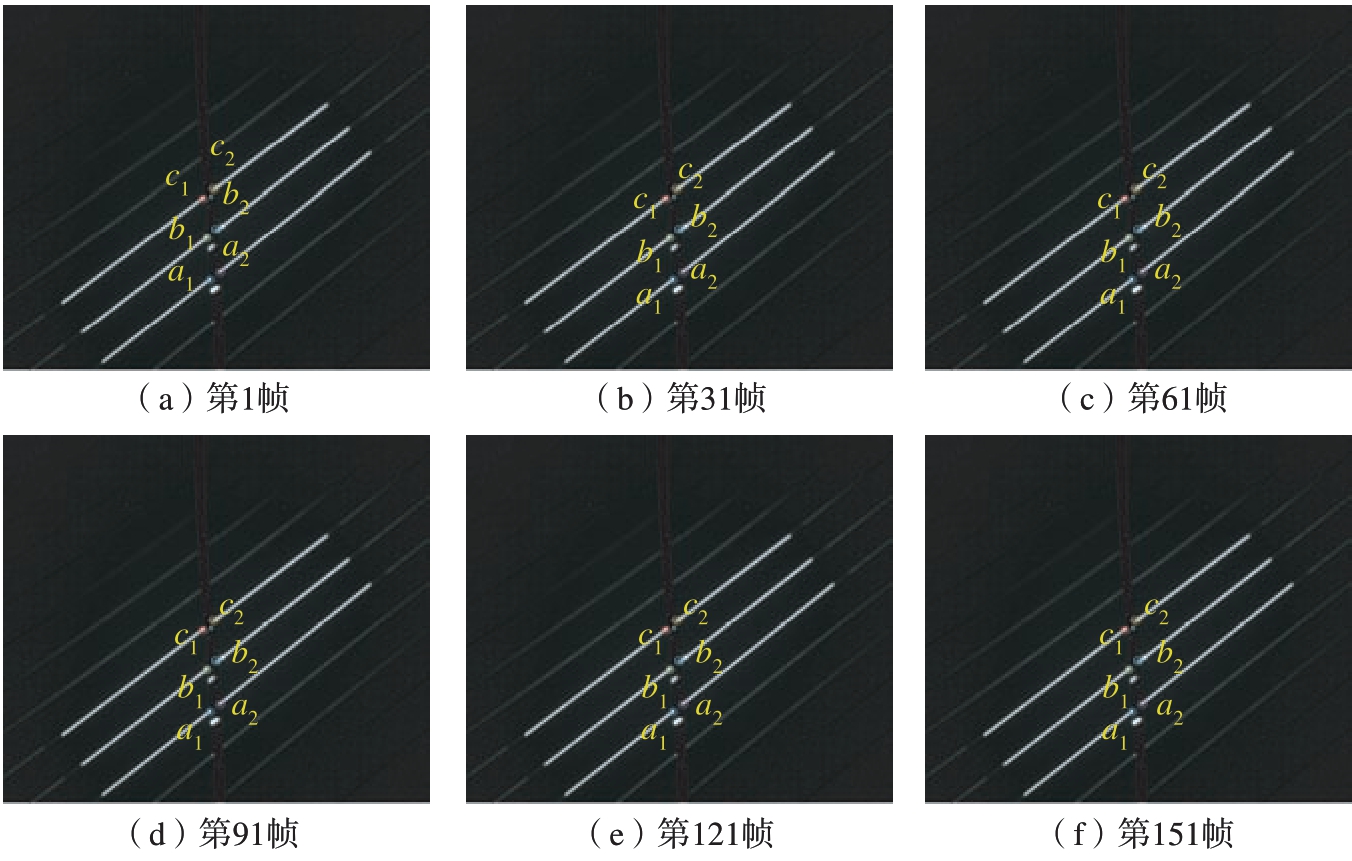

采集第1 帧图像时,通过形态学方法提取特征点坐标,然后采用光流法计算得到下一帧图像中对应的特征点坐标。同时将当前帧的特征点坐标与初始特征点坐标对比,当偏差超出阈值,则再次通过形态学方法提取特征点坐标,并使用该特征点坐标为输入,以此来修正光流跟踪模型,如此往复,直至处理完最后一帧图像。使用上述方法提取跟踪过程中的对缝特征点坐标,机器人的运动速度为7 mm/s,视觉传感器的图像采集帧率为30 帧/s,特征点提取效果如图4 所示,其中a1、a2、b1、b2、c1 和c2为结构光条与对缝边缘产生的3 对干涉端点,其坐标值如表1 所示。

表1 特征点坐标

Table 1 Feature point coordinates

帧数 a1 a2 b1 b2 c1 c2 1 (1032,1124)(1080,1126) (985,982) (1037,983) (939,844) (992,844)31 (1025,1123)(1075,1125) (980,980) (1031,983) (934,843) (986,845)61 (1020,1129)(1070,1130) (975,986) (1024,987) (928,848) (980,850)91 (1027,1127)(1068,1130) (970,985) (1024,986) (926,847) (979,849)121 (1012,1115) (1064,1116) (965,971) (1020,976) (920,835) (974,836)151 (1007,1114) (1061,1117) (961,971) (1015,973) (916,833) (968,835)

图4 特征点提取效果

Fig.4 Feature point extraction effect

3 对缝跟踪控制方法

当使用结构光视觉传感器获得对缝位置时,需要控制机器人使其准确地移动到对缝位置。本文将对缝位置直接发送到机器人控制器,然后使用机器人插补算法来控制机器人的运动,这需要完成高精度的手眼标定。

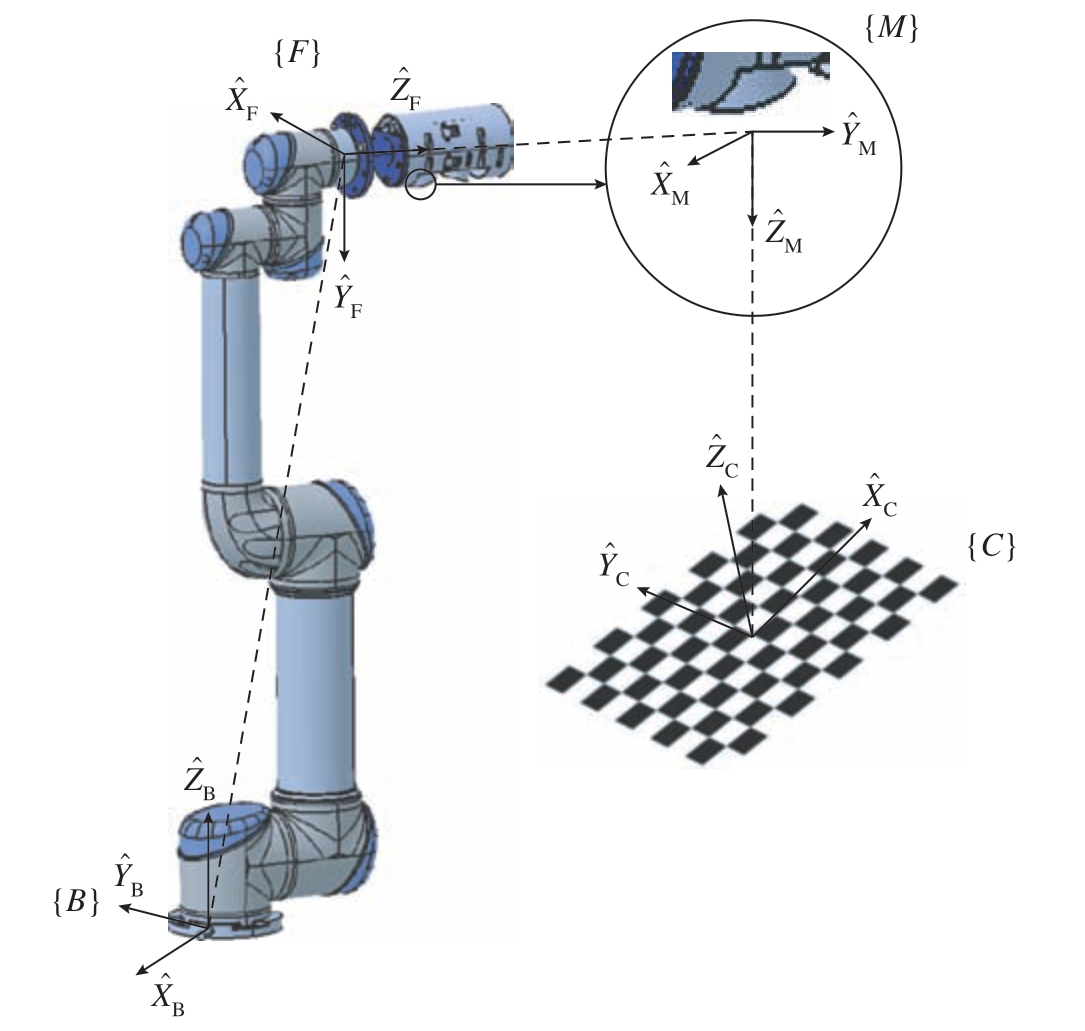

3.1 基于实测数据的手眼标定参数修正

如图5 所示,视觉传感器固定于机器人法兰盘处,随着机器人的运动而运动,属于典型的Eye-in-Hand 型关系。借助于辅助标定板,根据机器人基坐标系{B}和标定板坐标系{C}之间相对关系保持恒定的约束条件,计算得机器人法兰坐标系{F}和视觉系统测量坐标系{M}之间的转换关系。

图5 手眼标定模型

Fig.5 Eye-in-hand calibration model

在手眼标定的过程中,机器人基坐标系{B}和机器人法兰坐标系{F}之间的转换关系![]() 由机器人示教器中读取,机器人绝对定位误差使得

由机器人示教器中读取,机器人绝对定位误差使得![]() 矩阵参数失去准确性。因此为了提高手眼标定的精度,需要修正手眼标定得出的结果。假设准确的手眼标定矩阵为T,与未修正之前的矩阵转换关系为

矩阵参数失去准确性。因此为了提高手眼标定的精度,需要修正手眼标定得出的结果。假设准确的手眼标定矩阵为T,与未修正之前的矩阵转换关系为![]() ,其中,J 为上述两者之间的修正矩阵。设计多组试验来求解修正矩阵J,试验步骤如下。

,其中,J 为上述两者之间的修正矩阵。设计多组试验来求解修正矩阵J,试验步骤如下。

(1)选定一个靶标点,该点在机器人基坐标系下的坐标为(x,y,z)。

(2)控制视觉传感器以一定的顺序变换姿态来采集靶标点图像,并在每次拍摄时记录法兰坐标系相对于基坐标系的位姿矩阵。

从上述采集到的图像中提取出靶点在像素坐标系下的坐标(ui,vi),由上述视觉系统标定参数得到靶点在相机坐标系下的坐标(xmi,ymi,zmi),通过手眼标定矩阵参数可进一步获得靶点在机器人基坐标系下的坐标(xbi,ybi,zbi)。

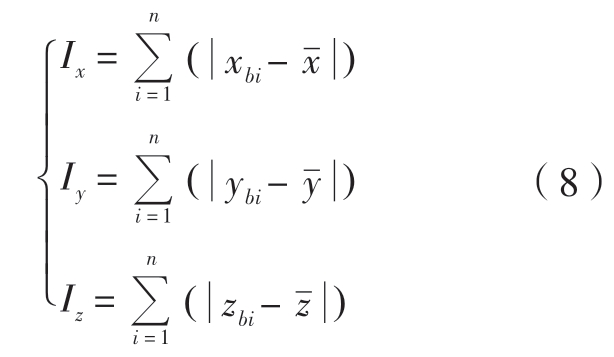

从视觉传感器在不同位姿下采集的图像中提取的靶标点坐标和实际坐标在直线上的总体偏移Δt 满足

式中,( ,

, ,

, )为(xbi,ybi,zbi)坐标集的平均坐标。Δt 主要是由矩阵

)为(xbi,ybi,zbi)坐标集的平均坐标。Δt 主要是由矩阵![]() 平移部分的相关参数不准确而引起的。根据从视觉传感器在不同位姿下采集的图像中提取的靶标点坐标与其平均坐标之间的差异波动,即可构建一个表达其倾斜程度的模型,即

平移部分的相关参数不准确而引起的。根据从视觉传感器在不同位姿下采集的图像中提取的靶标点坐标与其平均坐标之间的差异波动,即可构建一个表达其倾斜程度的模型,即

由于倾斜而造成的误差Δr 满足

Δr 体现了从视觉传感器在不同位姿下采集的图像中提取的靶标点坐标,在随着视觉传感器有序运动过程中与靶标点实际坐标之间的误差波动情况,主要是由矩阵![]() 旋转部分的相关参数的不准确而引起的。

旋转部分的相关参数的不准确而引起的。

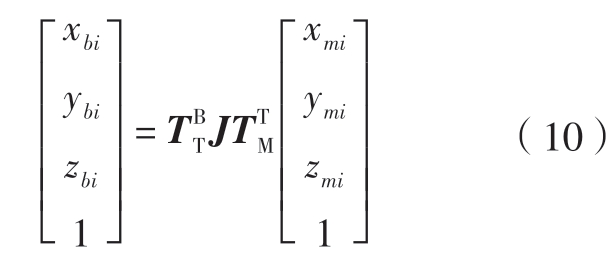

通过修正矩阵J 来修正手眼标定参数:

当Δt 与Δr 最小时,通过式(10)可得靶标点坐标和靶标点实际坐标的差距最小。修正矩阵J 的旋转向量为RJ,平移向量为TJ,则需要确定当Δt 与Δr 最小时对应的RJ 和TJ,可通过最优化搜索的方法来确定RJ和TJ。

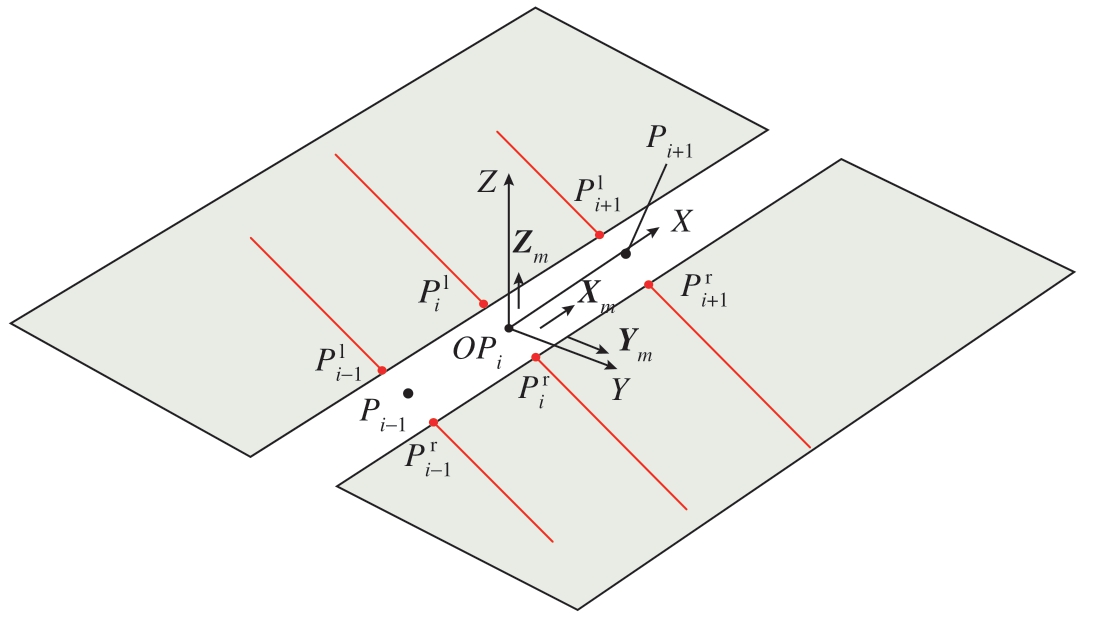

3.2 机器人跟踪位置和姿态求解

在保证手眼标定精度的前提下,可根据对缝特征点构建视觉传感器跟踪位姿求解模型,如图6 所示,将计算出的视觉传感器的实时跟踪位姿直接发送到机器人控制器,然后使用机器人插补算法来控制机器人的运动,从而完成对缝跟踪运动。

图6 跟踪位姿求解模型

Fig.6 Tracking pose solving model

结构光视觉传感器的跟踪轨迹由离散的轨迹特征点构成,根据2.3节中的方法提取6 个对缝特征点在像素平面的坐标,再经过视觉重建和手眼关系转换可获得机器人基坐标系的坐标,从而计算在机器人基坐标系下视觉传感器的运动位置如下

结构光视觉传感器跟踪姿态由视觉传感器前进矢量Xm 和检测矢量Zm 以及对缝法线矢量Ym 确定为

其中,轨迹特征点Pi 处的前进矢量Xm为轨迹在该点的单位切向量;视觉传感器的检测矢量Zm 要求与结构光平面平行并且指向蒙皮对缝;ni 为对缝特征点拟合平面的法向量;对缝法线矢量Ym 与视觉传感器前进矢量Xm、视觉传感器检测矢量Zm 为两两正交关系,组成右手矢量集合。由此可得某轨迹特征点P(x,y,z)处对应的视觉传感器的位置和姿态为

将识别出的对缝特征点坐标代入视觉传感器跟踪位姿求解模型,并将计算结果通过修正后手眼标定参数转换到机器人基坐标系中,即可得到准确的机器人跟踪位置和姿态信息。

4 试验结果与分析

为验证方法有效性,搭建对缝跟踪试验平台如图7 所示。本系统采用Universal Robots 公司的UR5 型机器人(重复定位精度±0.03 mm);工业相机是大恒图像公司的MER–502–79U3C 相机,其分辨率为2448×2048,最高帧率为79 帧/s;相机镜头是康标达公司的M0814–MP2 镜头,焦距为8 mm;结构光发生器是Osela Streamline Laser 系列的三线结构光发生器,波长为637 nm。

图7 对缝跟踪试验平台

Fig.7 Seam tracking experimental platform

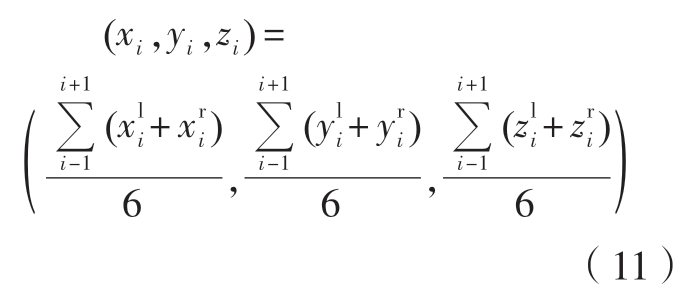

4.1 对缝跟踪位置精度验证

辅助试验设备如图8 所示,其中,图8(a)为对缝跟踪标准试验件的实物图。试验件的整体尺寸大小为350 mm×500 mm,加工制造精度为±0.050 mm。试验件上同时有直线对缝和曲线对缝,曲线对缝的理论轨迹为正弦函数曲线,两条对缝始末点间的距离均为450 mm。

图8 辅助试验设备

Fig.8 Auxiliary experimental equipment

视觉传感器通过转接环与机器人法兰连接,如图8(b)所示。转接环靠近机器人法兰盘的一侧设计了用于放置激光跟踪仪靶球座的基准孔(直径8 mm),通过基准孔可将机器人的相关坐标系与激光跟踪仪的测量坐标系建立联系。使用激光跟踪仪测量试验件基准点上的靶球坐标,利用坐标转换方法,将试验件上两条对缝的理论轨迹转换到机器人基坐标系中。视觉传感器以30 帧/s的帧率进行图像采集,以7 mm/s 的速度进行运动,完成整条对缝的扫描测量工作。将测量过程中视觉传感器的运动轨迹与三维数模中的理论轨迹进行对比从而获得轨迹误差。

4.1.1 直线对缝特征位置精度

以跟踪直线对缝为例,视觉传感器的工具中心点(Tool central point,TCP)位置坐标是通过机器人法兰坐标系的位姿解算得到的。在跟踪过程中,通过机器人示教器可读取当前状态下机器人法兰坐标系的位姿,解算出视觉传感器的TCP 坐标,将轨迹点拟合的轨迹与理论轨迹对比即可得到跟踪位置的误差。此外,将本文所用方法与鲁小翔[8]和王文辉[11]的方法进行比较,以此来验证方法的精确性。

直线对缝跟踪轨迹误差如图9所示。可知,在对缝跟踪过程中,使用本文方法拟合得到的对缝轨迹上的TCP 坐标到理论轨迹的位置最大误差不超过0.365 mm,平均误差为0.195 mm,明显优于另两种方法。

图9 直线对缝跟踪轨迹误差

Fig.9 Trajectory error of straight seam tracking

4.1.2 曲线对缝特征位置精度

按照上述试验步骤,对试验件上的曲线对缝进行跟踪试验,曲线对缝跟踪轨迹误差如图10 所示。可知,在对缝跟踪过程中,使用本文方法拟合得到的对缝轨迹上的TCP 坐标到理论轨迹的位置最大误差不超过0.465 mm,平均误差为0.305 mm,明显优于另两种方法。

图10 曲线对缝跟踪轨迹误差

Fig.10 Trajectory error of curve seam tracking

综合直线对缝和曲线对缝的跟踪试验结果可知,直线对缝跟踪的平均位置误差为0.195 mm,曲线对缝跟踪的平均位置误差为0.305 mm。相对于直线对缝跟踪来说,在进行曲线对缝跟踪时,机器人运动姿态调整的次数增多、幅度增大,从而导致累积的误差增大,即表现为曲线对缝跟踪的位置精度比直线对缝跟踪的位置精度差。

4.2 对缝跟踪姿态精度验证

在跟踪过程中,除了保证视觉传感器TCP点沿着对缝轨迹运动之外,还要保证跟踪过程中视觉传感器以理想的跟踪姿态进行运动,因此需要对试验件上的两条对缝进行视觉传感器姿态跟踪精度试验,以确保跟踪姿态的精度。

试验件对缝轨迹跟踪理想姿态如图11 所示。其中,直线对缝的理想跟踪姿态是确定唯一的,因此,以跟踪前进方向为X 轴,试验件平面为XOY 平面,法向为Z 轴建立坐标系,以此表示视觉传感器的理想跟踪姿态。曲线对缝的理想跟踪姿态随着轨迹运动而变化,以当前轨迹的切线方向为X 轴,试验件平面为XOY 平面,法向为Z 轴建立坐标系,以此表示视觉传感器的理想跟踪姿态。

图11 对缝轨迹跟踪理想姿态示意图

Fig.11 Schematic diagram of ideal posture for seam trajectory tracking

4.2.1 直线对缝特征姿态精度

以跟踪直线对缝为例,在跟踪过程中,通过机器人示教器得到当前状态下的机器人法兰坐标系的位姿,通过工具坐标系标定得到的转换关系可解算出视觉传感器的姿态。对应的理想跟踪姿态可以从数模中提取得到。将二者通过相关坐标系进行转换统一,随后计算二者在X 轴、Y轴和Z 轴上的角度偏差来验证姿态跟踪精度。

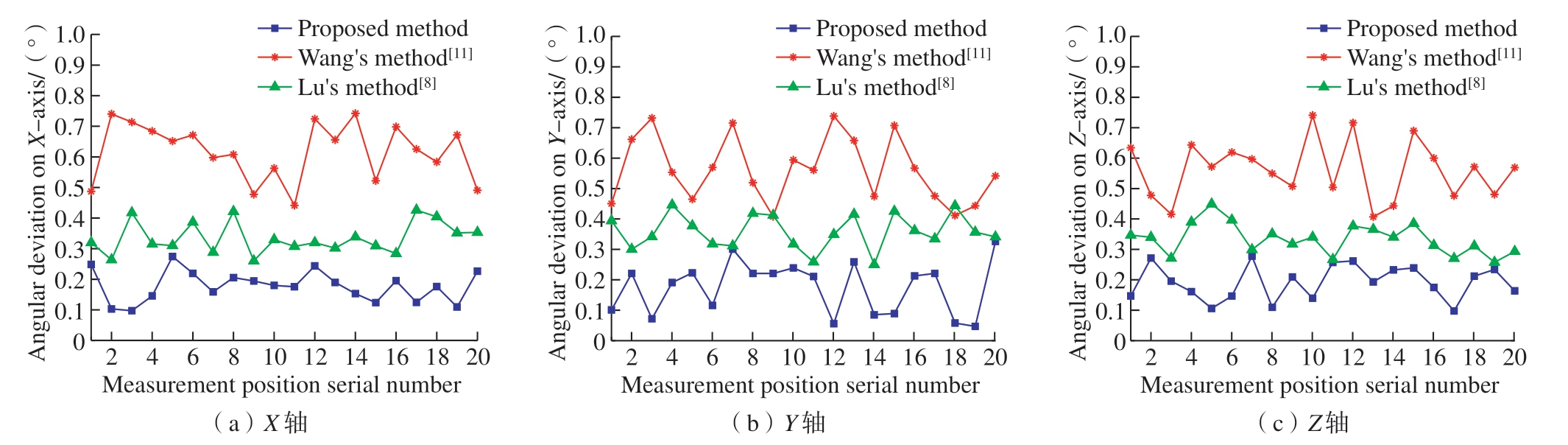

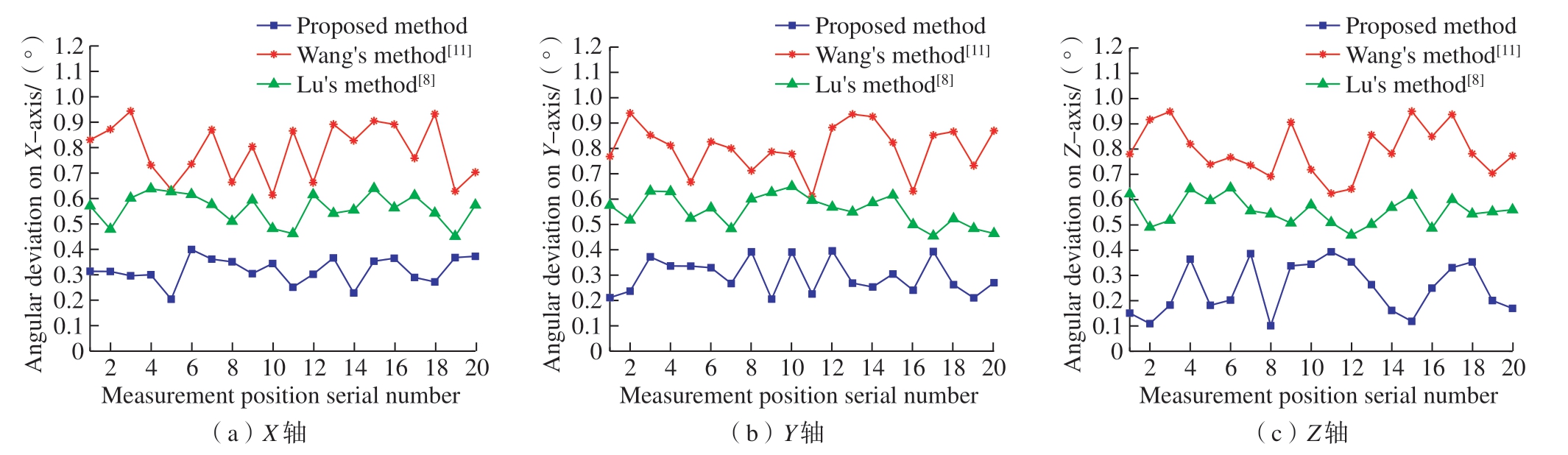

直线对缝跟踪姿态误差如图12所示,在跟踪过程中,视觉传感器的实际跟踪姿态与对应的理想跟踪姿态在X 轴方向上的跟踪姿态偏差角度最大不超过0.3°,平均偏差角度为0.239°;在Y 轴方向上的跟踪姿态偏差角度最大不超过0.3°,平均偏差角度为0.209°;在Z 轴方向上的跟踪姿态偏差角度最大不超过0.3°,平均偏差角度为0.231°。本文方法明显优于另两种方法。

图12 直线对缝跟踪姿态误差

Fig.12 Straight seam tracking attitude error

4.2.2 曲线对缝特征姿态精度

曲线对缝跟踪姿态误差如图13所示。可知,在跟踪过程中,视觉传感器的实际跟踪姿态与对应的理想跟踪姿态在X 轴方向上的跟踪姿态偏差角度最大不超过0.45°,平均偏差角度为0.341°;在Y 轴方向上的跟踪姿态偏差角度最大不超过0.45°,平均偏差角度为0.374°;在Z 轴方向上的跟踪姿态偏差角度最大不超过0.45°,平均偏差角度为0.355°。

图13 曲线对缝跟踪姿态误差

Fig.13 Curve seam tracking attitude error

综合直线对缝和曲线对缝的姿态跟踪试验结果可知,直线对缝的实际跟踪姿态与理想跟踪姿态,在X轴、Y 轴和Z 轴方向上的平均角度偏差分别为0.239°、0.209°和0.231°;曲线对缝的实际跟踪姿态与理想跟踪姿态,在X 轴、Y 轴和Z 轴方向上的平均角度偏差分别为0.341°、0.374°和0.355°。相对于直线对缝跟踪,在进行曲线对缝跟踪时,机器人运动姿态调整的次数增多、幅度增大,从而导致累积的误差增大,即表现为曲线对缝跟踪的姿态精度比直线对缝跟踪的姿态精度差。

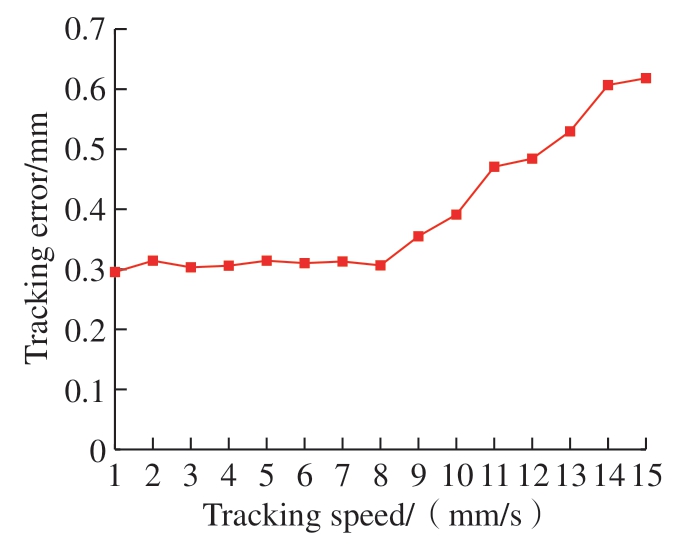

4.3 速度适应性验证

为了确定跟踪速度对于本文方法跟踪精度的影响,在不同跟踪速度下对跟踪精度进行验证,并确定最优的跟踪速度。以曲线对缝为检测目标,设定跟踪速度从1 mm/s 到15 mm/s,以1 mm/s 为间隔进行整数递增,并在每个速度下以整条曲线对缝的平均跟踪位置精度来表示对缝跟踪精度,试验结果如图14 所示。可知,当跟踪速度在1~8 mm/s 范围内时,对缝跟踪误差维持在一个较低的水平。当超出此范围后,跟踪速度将对跟踪和测量误差产生较大影响。主要有2 个原因: (1)当机器人移动速度较快时,相机受到图像采集帧率和快门速度的影响,难以采集清晰的图像; (2)机器人移动速度较快时,相邻帧之间图像产生较大的运动差,不满足相邻图像像素运动空间一致的条件,从而导致对缝跟踪误差较大。综合考虑对缝测量精度和跟踪效率并避免选择临界值,确定本系统测量精度最佳时的跟踪速度为7 mm/s,此条件下,对缝跟踪的位置精度大于0.500 mm,对缝跟踪的姿态精度大于0.5°。

图14 不同速度下的对缝跟踪误差

Fig.14 Seam tracking error at different speeds

5 结论

本文开发了一种基于结构光视觉的蒙皮对缝自主跟踪系统。针对跟踪系统开发中遇到的问题,提出了跟踪过程中对缝特征点实时提取和机器人运动控制的方法。

(1)采用传统的形态学方法提取蒙皮对缝特征并确定对缝跟踪区域。在对缝跟踪过程中,为了满足对缝特征点提取的实时性要求,利用对缝图像的光流信息来实时提取对缝特征点。

(2)构建视觉传感器跟踪位姿求解模型,并结合修正后手眼标定参数准确地解算出机器人跟踪位置和姿态信息,实现机器人对蒙皮对缝的精准跟踪。

(3)试验和分析表明,该跟踪系统具有良好的准确性和稳定性。当跟踪速度为7 mm/s 时,对缝跟踪的位置精度大于0.500 mm,对缝跟踪的姿态精度大于0.5°,表明该系统具有良好的跟踪效果。

[1] 刘芳, 夏桂锁, 温志辉, 等.飞机蒙皮缺陷检测的现状与展望[J].航空制造技术,2021, 64(23/24): 39–50.

LIU Fang, XIA Guisuo, WEN Zhihui, et al.Current status and prospect of defect detection of aircraft skin[J].Aeronautical Manufacturing Technology, 2021, 64(23/24): 39–50.

[2] 何潇, 杨鹏飞, 樊俊玲.飞机二次共固化蒙皮超声检测缺陷信号的识别方法[J].无损检测, 2020, 42(4): 31–35.

HE Xiao, YANG Pengfei, FAN Junling.Identification of defect signals of ultrasonic testing of aircraft secondary co-cured skin[J].Nondestructive Testing, 2020, 42(4): 31–35.

[3] XIA R B, ZHAO J B, ZHANG T Y, et al.Detection method of manufacturing defects on aircraft surface based on fringe projection[J].Optik, 2020, 208: 164332.

[4] FENG Z Y, MAO K Y, ZOU T C,et al.Discussion on airworthiness requirement of widespread fatigue damage—Safe-life methodology or damage-tolerance methodology[J].Procedia Engineering, 2014, 80: 392–398.

[5] LONG K, XIE Q, LU D N, et al.Aircraft skin gap and flush measurement based on seam region extraction from 3D point cloud[J].Measurement, 2021, 176: 109169.

[6] 张波.飞机蒙皮对缝特征提取及间隙阶差分析方法[D].南京: 南京航空航天大学, 2020.

ZHANG Bo.Methods for extracting feature and analyzing gap and flush of seam on aircraft skin[D].Nanjing: Nanjing University of Aeronautics and Astronautics, 2020.

[7] 张卡.面向飞机蒙皮接缝的线结构光检测技术研究[D].南京: 南京航空航天大学, 2011.

ZHANG Ka.Research on linear structured light detection technology for aircraft skin seams[D].Nanjing: Nanjing University of Aeronautics and Astronautics, 2011.

[8] 鲁小翔.飞机蒙皮对缝自动化视觉跟踪测量[D].南京: 南京航空航天大学,2020.

LU Xiaoxiang.Automated visual tracking measurement of aircraft skin seam alignment[D].Nanjing: Nanjing University of Aeronautics and Astronautics, 2020.

[9] 张洪瑶, 李论, 赵吉宾, 等.基于机器人——扫描仪测量的蒙皮对缝检测技术研究[J].工具技术, 2018, 52(8): 121–126.

ZHANG Hongyao, LI Lun, ZHAO Jibin, et al.Research on measurement technique of flush and gap between aircraft skins based on robot-3D laser scanner system[J].Tool Engineering,2018, 52(8): 121–126.

[10] 许大帅, 杜福洲.基于线结构光的飞机蒙皮对缝阶差与间隙测量技术研究[J].航空制造技术, 2017, 60(5): 77–81.

XU Dashuai, DU Fuzhou.Research on measurement technique of the stepped difference and gap between aircraft skins based on linear structural light[J].Aeronautical Manufacturing Technology, 2017, 60(5): 77–81.

[11] 王文辉.自主移动式对缝测量平台设计与开发[D].南京: 南京航空航天大学,2020.

WANG Wenhui.Design and development of autonomous movement platform for seam measurement[D].Nanjing: Nanjing University of Aeronautics and Astronautics, 2020.

[12] RYBERG A, ERICSSON M,CHRISTIANSSON A K, et al.Stereo vision for path correction in off-line programmed robot welding[C]//2010 IEEE International Conference on Industrial Technology.Chile:IEEE, 2010.

[13] JIN Z S, LI H C, ZHANG C H, et al.Online welding path detection in automatic tube-to-tubesheet welding using passive vision[J].The International Journal of Advanced Manufacturing Technology, 2017, 90(9): 3075–3084.

[14] 陆苗.基于结构光点云的焊缝定位与跟踪方法研究[D].南京: 南京航空航天大学, 2021.

LU Miao.Research on weld location and tracking method based on structured light point cloud[D].Nanjing: Nanjing University of Aeronautics and Astronautics, 2021.

[15] 邹焱飚, 周卫林, 陈向志.基于深度分层特征的激光视觉焊缝检测与跟踪系统研究[J].中国激光, 2017, 44(4): 0402009.

ZOU Yanbiao, ZHOU Weilin, CHEN Xiangzhi.Research of laser vision seam detection and tracking system based on depth hierarchical feature[J].Chinese Journal of Lasers, 2017, 44(4): 0402009.

[16] ZOU Y B, CHEN X Z, GONG G J,et al.A seam tracking system based on a laser vision sensor[J].Measurement, 2018, 127:489–500.

[17] TRAN T T, HA C.Non-contact gap and flush measurement using monocular structured multi-line light vision for vehicle assembly[J].International Journal of Control,Automation and Systems, 2018, 16(5): 2432–2445.

[18] GUO J C, ZHU Z M, SUN B W,et al.Principle of an innovative visual sensor based on combined laser structured lights and its experimental verification[J].Optics & Laser Technology, 2019, 111: 35–44.