为了减少液体晃动对压力容器的影响,需要在容器内部安装并焊接防浪板,以提高运输过程中的安全性与稳定性(压力容器通常指工作压力≥0.1 MPa,内直径≥150 mm 的密封容器,常用来盛装可燃可爆、易使人产生窒息的介质,一旦出现质量事故,就极有可能造成经济损失)。目前,人工焊接效率低、焊接精度差。传统工业机器人的示教编程限制了起始焊接点位,只能机械执行预设路径,无法满足容器内部复杂环境的路径规划[1],因此,在容器内部焊接需要新的焊接点定位方法。基于视觉传感的机器人自动焊接具有焊接精度高、抗干扰能力强、柔性化、智能化的优点[2],按照成像光源不同,视觉焊接点检测又分为被动视觉焊接点检测和主动视觉焊接点检测。

被动视觉焊接点检测是在自然光环境下,相机直接拍摄焊缝表面成像进行焊接表面参数检测[3]。刘涛等[4]设计了一种基于被动双目视觉的环形焊缝定位与跟踪系统,解决了非标罐体的环形焊缝识别的问题,试验结果表明,该系统平均误差为0.14 mm,可以准确识别焊缝位置。张世宽等[5]提出了语义分割与目标检测相结合的深度学习模型,用于焊缝图像检测,结果表明,该方法能检测出焊缝图像中的结构光条纹。但是被动视觉受限于自然光成像,反映焊缝与焊接点位置信息能力较差,工业现场常采用稳定的结构光作为主动光源的视觉传感器进行焊接点位置检测[6]。

主动视觉焊接点检测方法利用激光三维测量原理,采用特定波长的激光结构光投射至待焊接工件表面,激光在焊缝处发生形状变化形成焊缝特征[7]。Du 等[8]使用单目线激光传感器,利用卷积神经网络识别强噪声下的非经典焊缝特征,基于该算法的非标准焊缝识别准确率为98%。Fan 等[9]使用了一种带滤光片和额外LED 灯滤除强弧光的大部分噪声,获取了激光条纹和窄对接缝在内的图像。Li 等[10]使用了单目线激光传感器,提出了序列重力算法能够快速提取平滑焊缝线。

综上所述,基于激光三维测量原理的主动视觉焊接点检测方法具有更强的抗噪声性和更高的精度。目前成熟的激光三维焊接点检测方法适用于小型压力容器,而本文所研究的大型压力容器与防浪板形成的焊缝属于异型单端卷边焊缝和异型端接焊缝,两者都属于非标准焊缝,尚未研发出该焊缝下的主动视觉焊接点检测方法。

为了解决上述问题,本文设计了一种结构光视觉引导机器人的多特征融合三维焊接点位实时检测方法。以结构光视觉传感系统为主要测量设备,通过将线结构光束投射到焊缝表面,对采集到的焊缝图去除噪声并提取多个特征,结合多种后处理方式以及标定结果,实现机器人对三维焊接点的定位。

1 焊接点视觉检测平台硬件组成

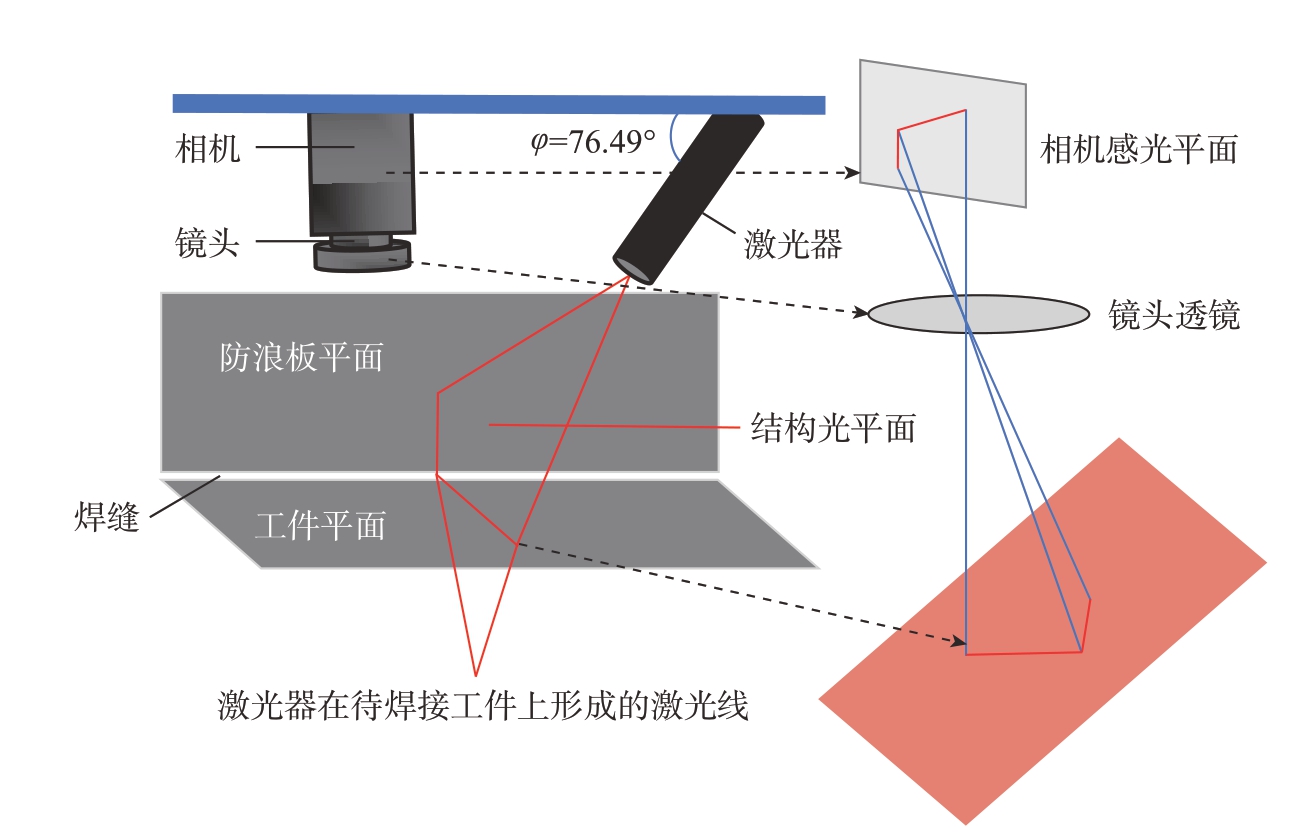

焊接点视觉检测平台由结构光视觉传感器、工业机器人、控制中心、焊机和悬臂梁组成,如图1所示。结构光视觉传感器作为末端测量系统,用于采集具有焊缝特征的图像。结构光视觉传感器由激光器、CMOS相机组成。相机与激光器存在一个固定夹角φ,当激光器发射的光条投射到待检测焊缝时,会产生一道折线投射到相机感光平面上,由相机采集。为保证激光光条处于相机感光平面中心位置,通过多次试验将φ 定为76.49°,激光发射端中心距镜头中心水平距离为92.600 mm,结构光视觉传感器工作原理如图2所示。

图1 焊接试验平台仿真图

Fig.1 Simulation diagram of welding experimental platform

图2 结构光视觉传感器基本原理

Fig.2 Structured light vision sensor fundamentals

2 三维焊接点检测原理

2.1 ROI 区域特征提取

为了获取关键焊接点位,需要对具有焊缝特征的图像进行特征提取,得到图像中两种特征的ROI。由于待焊接工件属于反光镜面型铝合金,激光会产生强烈的反光,传统的去噪方法是基于图像处理技术,通过人为设定特征去除噪音。这种方法适用性和实用性差,很难得到令人满意的效果。

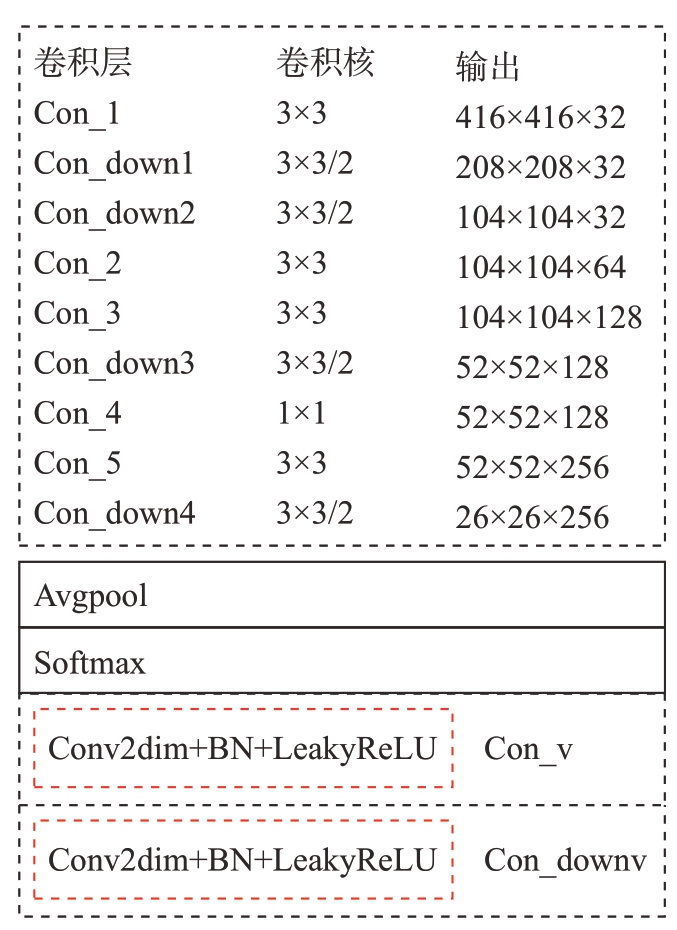

基于深度学习的数据驱动型定位回归算法具有特征区域识别、强噪声去除能力。YOLO(You only look once)系列网络对原图进行网格化,在网格的基础上生成候选框。由于本试验目标特征容易描述,并且标注尺寸适中,标注位置相对固定,适用于ROI 特征提取。对于主干网络Darknet19,由于Con_9 输出特征图具有描述光条特征的能力,Con_9 之后卷积层输出图像更加抽象,属于冗余数据,因此删除了Con_9 之后的卷积层,减少卷积层计算量。改进后的主干网络命名为cDarknet-9 网络结构,如图3所示。

图3 cDarknet-9 网络结构图

Fig.3 cDarknet-9 network structure diagram

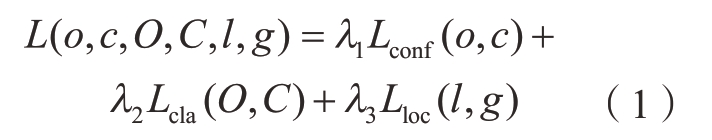

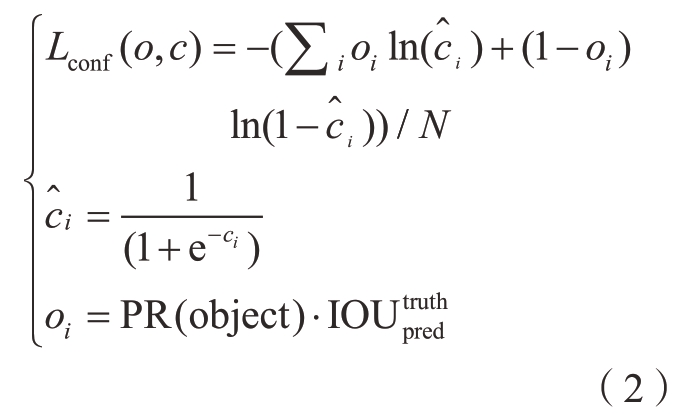

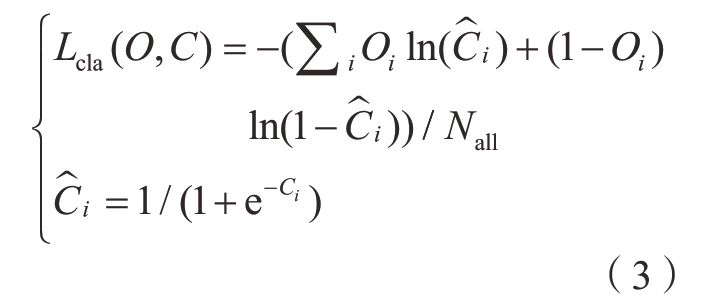

网络训练通过最小化损失函数求解和评估模型。网络损失函数L(o,c,O,C,l,g)由置信损失Lconf、分类损失Lcla、定位回归损失Lloc 组成,如式(1)所示。

式中,λ1、λ2、λ3为平衡系数;Lconf、Lcla、Lloc 计算如式(2)~(4)所示。

式中,![]() 为预测目标回归边界框与真实标注框的IOU 值;N为正样本总个数;i 表示预测目标回归边界框的个数; ci 表示Lconf 置信度。当预测候选框被认定为正样本时,oi为1,PR(object)为1;当预测候选框被认定为负样本时,oi为0,PR(object)为0。

为预测目标回归边界框与真实标注框的IOU 值;N为正样本总个数;i 表示预测目标回归边界框的个数; ci 表示Lconf 置信度。当预测候选框被认定为正样本时,oi为1,PR(object)为1;当预测候选框被认定为负样本时,oi为0,PR(object)为0。

式中,Ci为Lcla 置信度;Nall 表示预测候选框的个数。当预测候选框被认定为正样本时Oi = 1,否则为0。

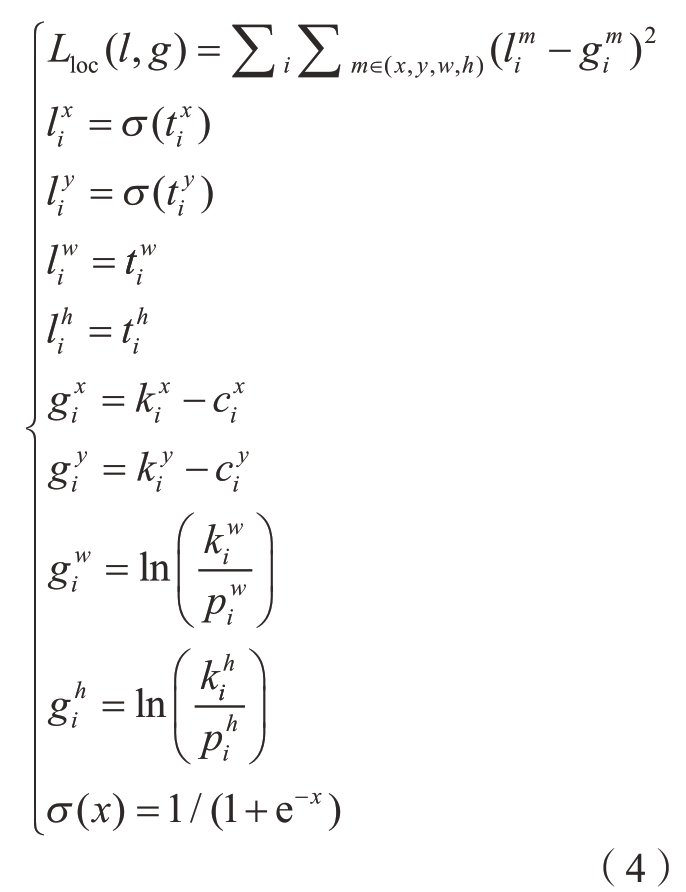

式中,![]() 为定位预测回归参数;

为定位预测回归参数; ![]() 为锚框的中心坐标;

为锚框的中心坐标;![]() 为锚框的宽和高;

为锚框的宽和高; ![]() 为真实框的中心坐标;

为真实框的中心坐标;![]() 为真实框的宽和高。

为真实框的宽和高。

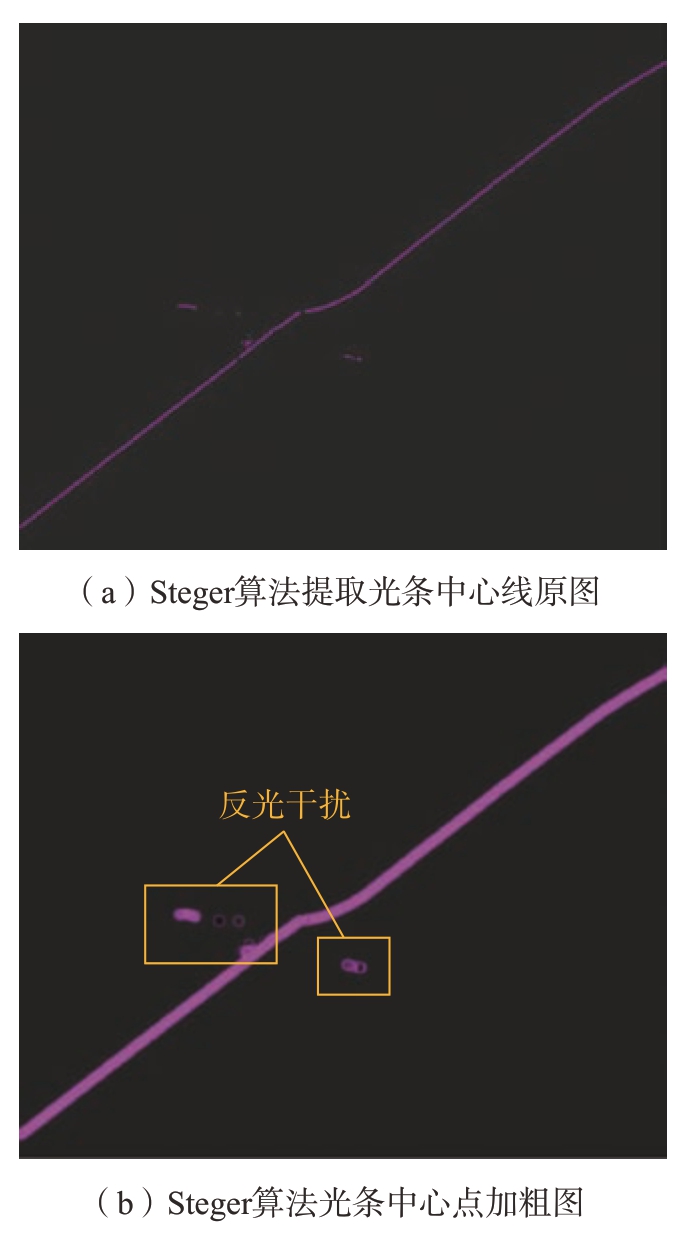

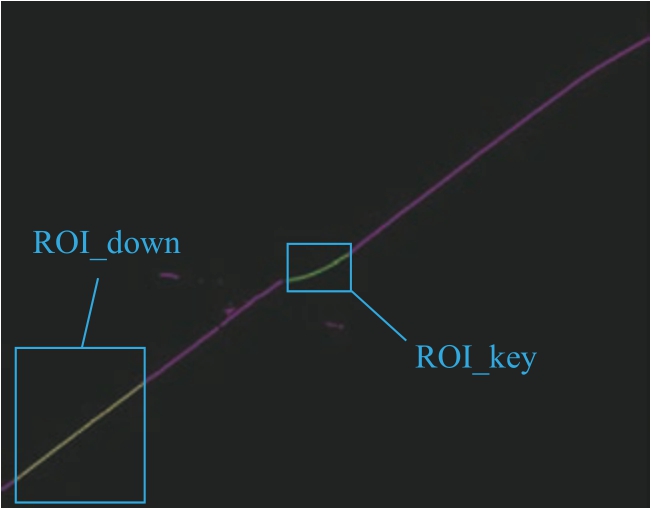

采用Hessian 矩阵的Steger 算法提取原图的光条中心易受反光干扰,如图4所示。利用定位回归网络识别到上光条感兴趣区域ROI_key和下光条感兴趣区域ROI_down,边框信息框出ROI 内的光条中心,具有抗反光的效果,如图5所示。

图4 Steger 算法光条中心提取

Fig.4 Steger algorithm light bar center extraction map

图5 定位回归网络光条中心提取图

Fig.5 Positioning regression network optical strip center extraction map

2.2 关键点位获取

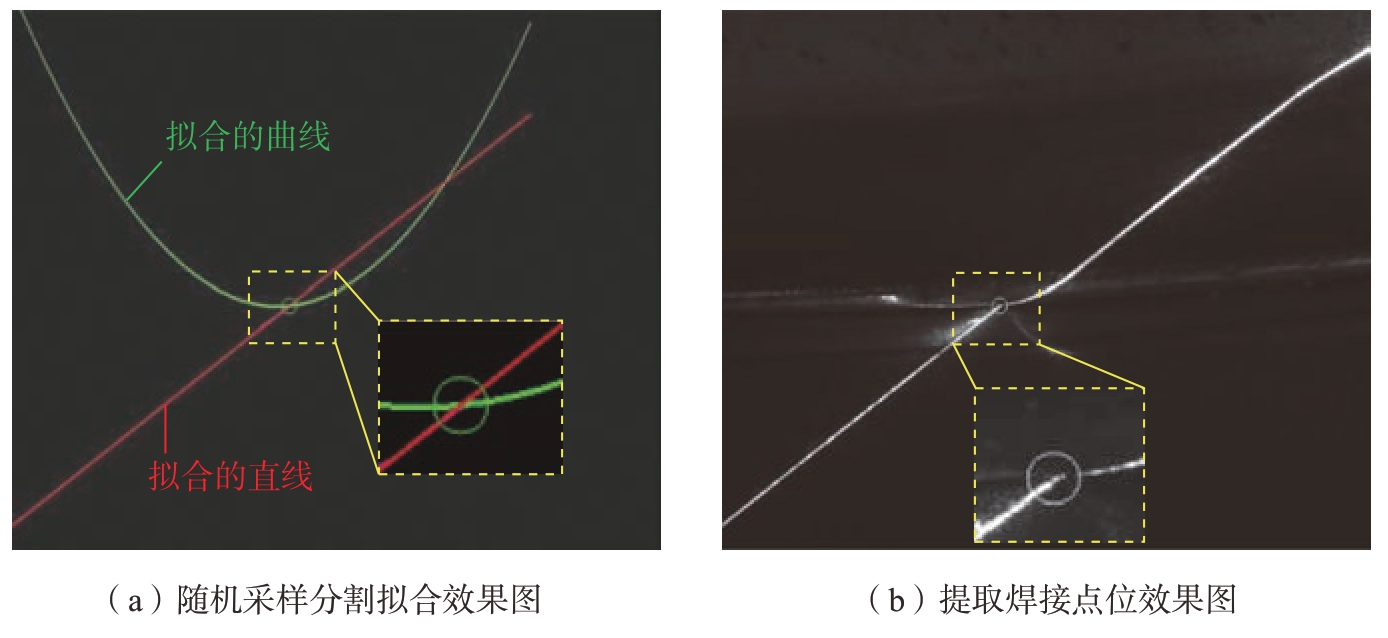

为了获取关键焊接点位,需要对提取到的ROI_down 内的光条中心点采用随机采样分割拟合直线,对ROI_key 内的光条中心点采用随机采样分割拟合二阶曲线,随机采样步骤如下。

步骤1:选择一个可以解释或者适应于观测数据的参数化模型(本文中模型为直线和二阶曲线),输入一组观测数据。

步骤2:选择观测数据中的一组子集,该子集称为初始子集,通过直线最小二乘法拟合模型或者二阶曲线最小二乘法拟合模型。

步骤3:用得到的模型去测试其他数据,如果某个点小于提前设置的最大容许误差(该点适用于模型),则认为该点为局内点。

步骤4:重复步骤3 直到有足够多的点被认为是局内点,如果没有足够多的点,则返回步骤1。

步骤5:用所有假设的局内点去重新估计模型,通过估计局内点与模型的错误率来评估模型。

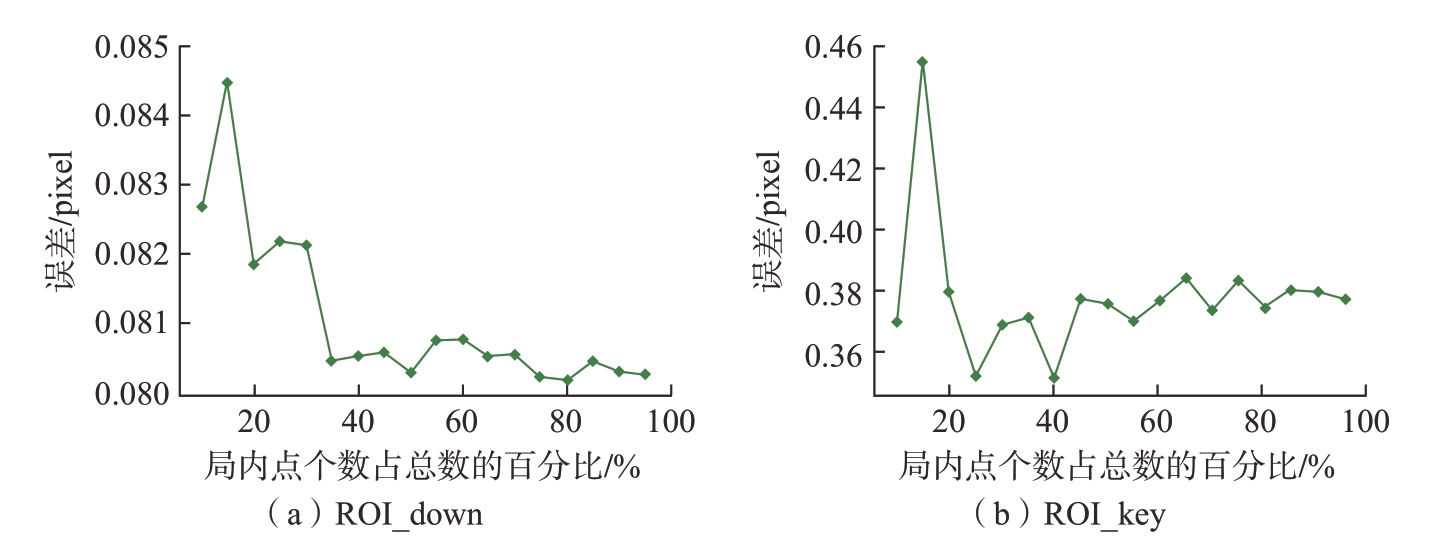

对于ROI_down,为了快速准确地达到拟合直线效果,设置初始子集个数与局内点的数据个数相同(期待第1 次拟合就能达到最佳效果),最大迭代次数为3 次,为了保证拟合精度,最大容许误差设定为3 pixel。探究局内点的个数对模型误差的影响,选取局内点个数占ROI_down 内光条中心点总数的10%~95%,中间间隔5%,选取200 张图像求取局内点的个数占比对应的平均模型误差,模型误差采用均方差评价,结果如图6(a)所示。当局内点个数占ROI_down 内光条中心点的总数的百分比为80%时模型误差最小。

对于ROI_key,为了尽快达到二阶曲线拟合效果,设置初始子集个数与局内点的数据个数相同。最大容许误差为3 pixel,最大迭代次数为20次。探究局内点的个数对模型误差的影响。选取局内点个数占ROI_key内光条中心点总数的10%~95%,中间间隔5%,选取300 张图像求取局内点的个数占比对应的平均模型误差,模型误差采用均方差评价,结果如图6(b)所示。当局内点个数占ROI_key 内光条中心点总数的百分比为40%时模型误差最小。

图6 ROI_down 和ROI_key 局内点个数对模型误差的影响

Fig.6 Effect of the number of points in ROI_down and ROI_key region on model error

求取ROI_down 内拟合的直线和ROI_key 内拟合的二阶曲线的交点,该交点即为关键焊接点位,如图7所示。

图7 关键焊接点位提取

Fig.7 Key welding point extraction

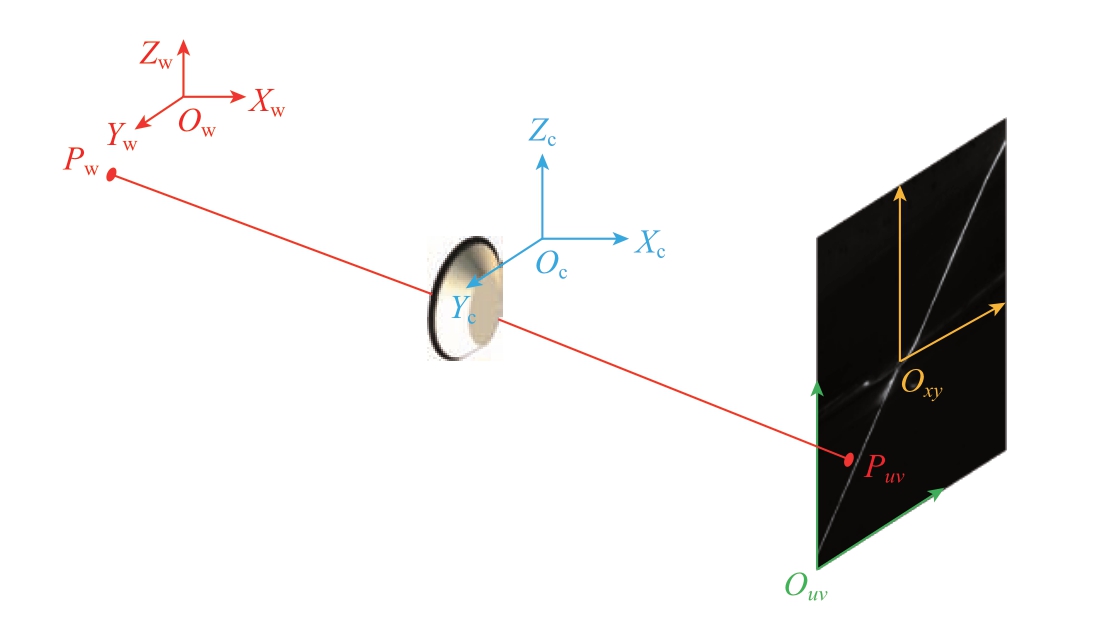

2.3 三维焊接点位提取

为了将像素坐标系下获取的关键焊接信息转换至世界坐标系下,需要使用单目相机标定、光平面标定。相机标定主要建立图像二维平面到三维相机坐标系场景的关系,假设空间存在一点Pw,点Pw 通过镜头的光心在图像上成像点为Puv。在映射到成像平面上的二维坐标过程中经历4 次坐标系转换:世界坐标系Ow–XwYwZw 到相机坐标系Oc–XcYcZc 的转换,相机坐标系Oc–XcYcZc 到图像坐标系Oxy–xy 的转换,图像坐标系Oxy–xy到像素坐标系Ouv–uv 的转换,转换过程如图8所示。

图8 坐标系转换关系

Fig.8 Coordinate system transformation relationship

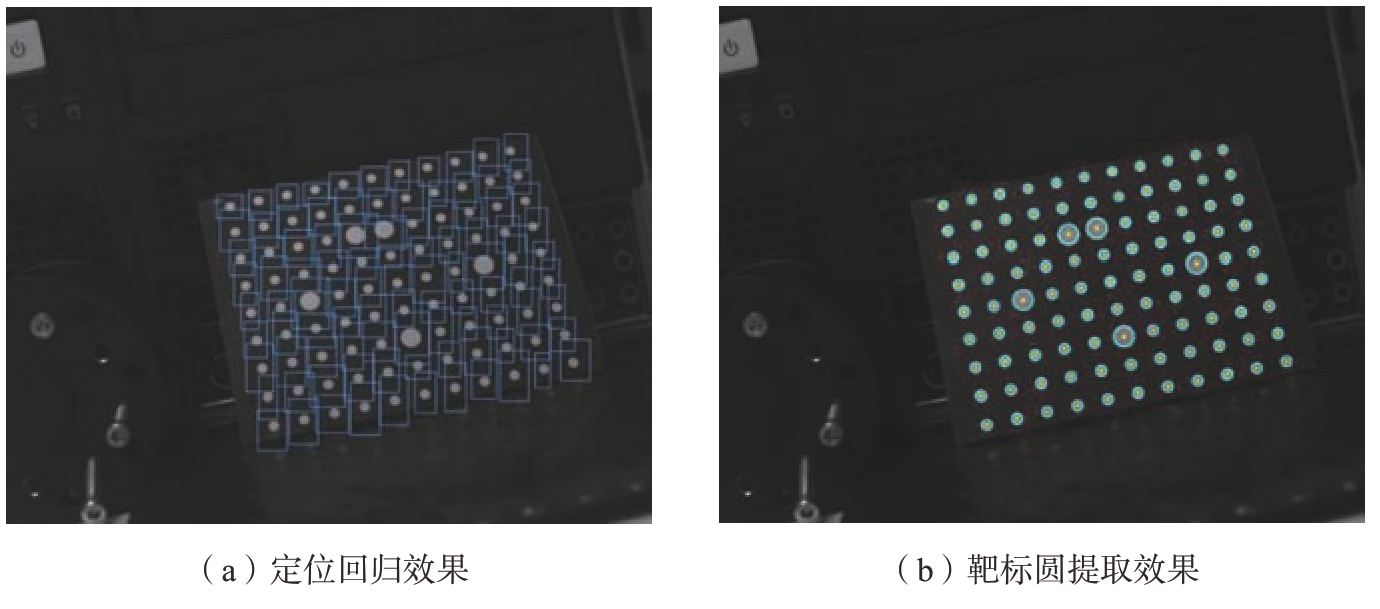

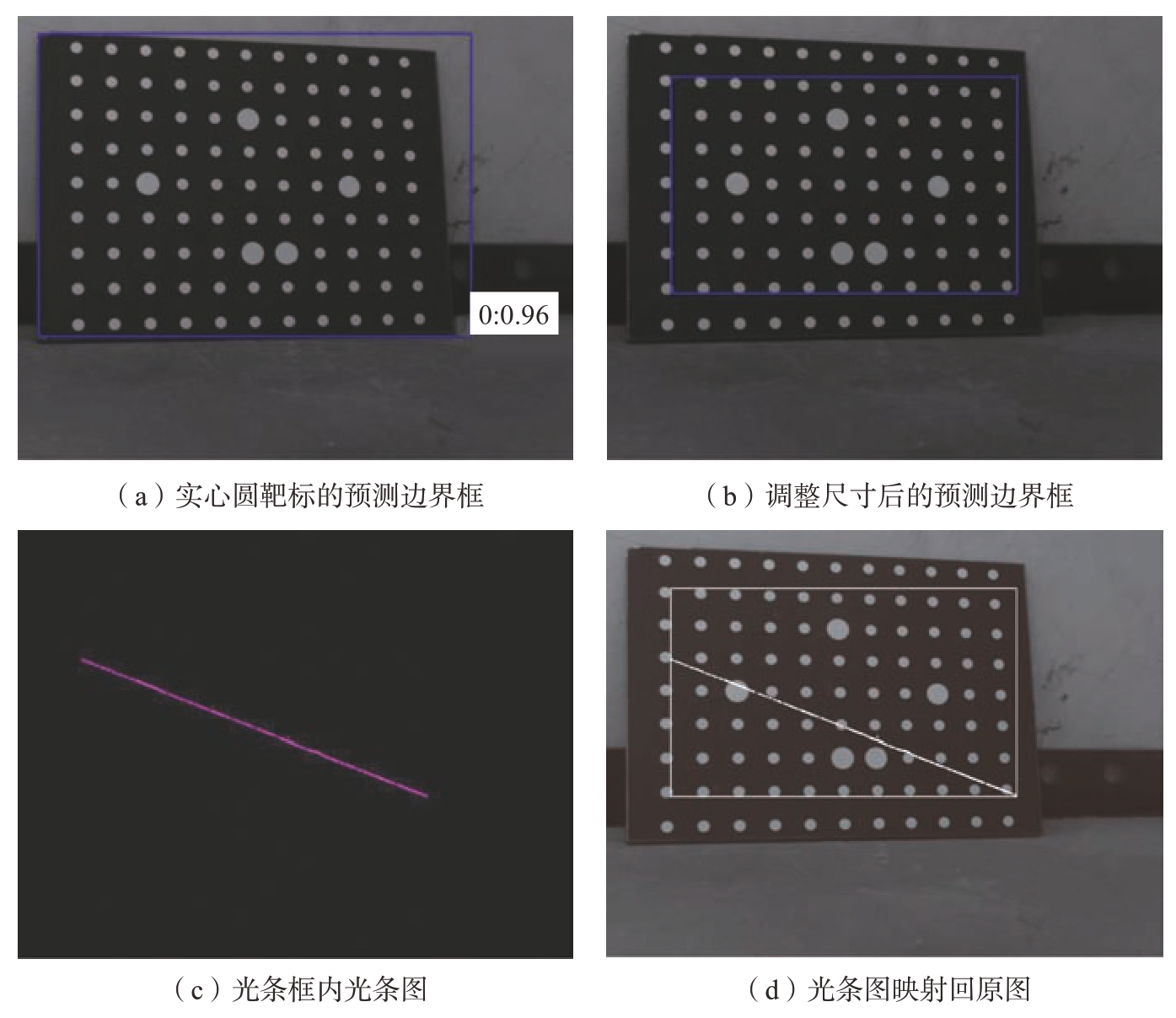

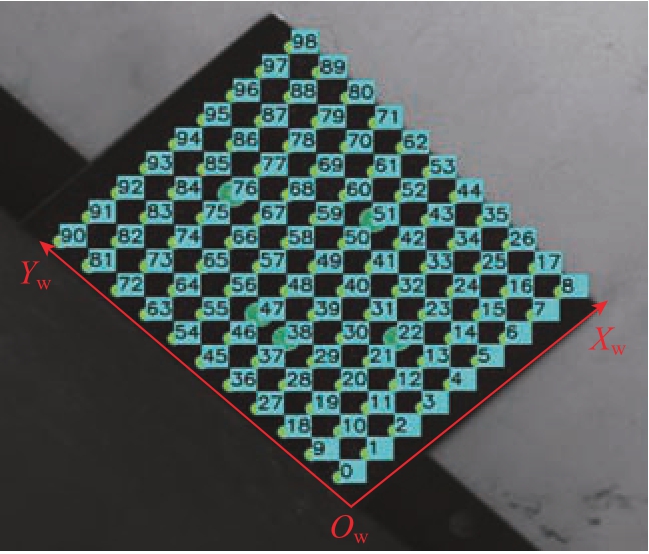

本研究使用实心圆靶标进行单目相机标定。在标定过程中,传统方法通过对图像去噪、Canny 边缘提取、闭口轮廓提取选出特征圆,这种非监督的方法难以做到特征区域的识别和分割,因此采用基于深度学习的图像定位识别回归方式,定位回归效果图和靶标圆提取效果如图9所示。

图9 基于深度学习的靶标圆提取方法

Fig.9 Target circle extraction method based on deep learning

根据提取结果,通过对靶标圆排序,利用张正友标定法解得内参和外参矩阵,完成相机标定。

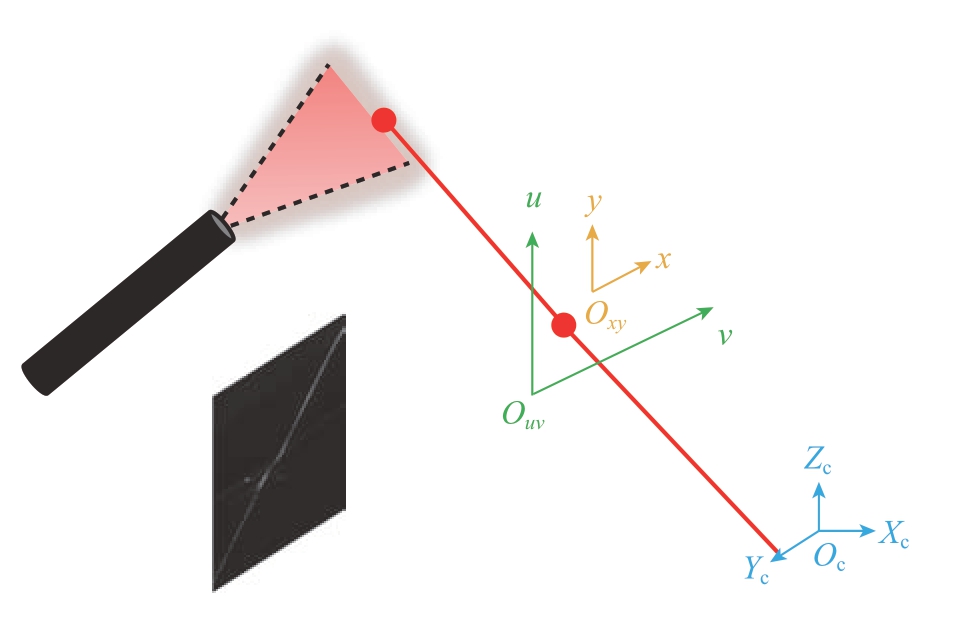

为了获取三维信息需要进行光平面标定,线结构光的测量模型如图10所示。通过已知相机的内参,如果已知结构光在相机坐标系下的平面方程,便可以获取像素坐标系下对应点在相机坐标系下的坐标。假设,线结构光在相机坐标系下的平面方程如式(5)所示,A、B、C、D为光平面参数,其中(A、B、C)为光平面法向量。线结构光在相机坐标系下的平面方程结合内参标定结果可建立式(6)所示的方程,通过求解该方程可以获取xc、yc、zc。其中f为相机焦距。

图10 线结构光测量模型

Fig.10 Line structured light measurement model

为了实现快速现场标定,且标定结果准确,本研究提出了无约束光平面标定方法,具体步骤如下。

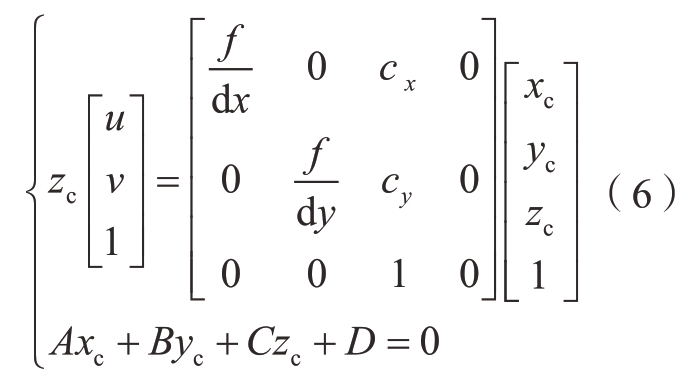

(1)摆放好实心圆靶标,利用特征提取网络提取出实心圆靶标的预测边界框,将预测边界框的宽高分别缩减200 pixel,将宽高分别缩减了200 pixel 的预测边界框称为光条框,用于框选光条,如图11(a)和(b)所示。

(2)降低相机曝光,开启激光器,利用基于Hessian 矩阵的Steger 算法提取光条框内的光条中心,如图11(c)所示。

(3)关闭激光器,对相机进行标定,在第1 幅图上建立世界坐标系。

(4)如图11(d)所示,由于光条框内的光条完全投射在第1 幅实心靶标图上,因此认为光条框内的光条中心点在世界坐标下Zw 全部为0,第1 幅图的第1 号靶标圆心在像素坐标系下坐标值为(u1,v1),第1 幅图的第1 号靶标圆心在世界坐标系下坐标为(9,0,0)(相邻圆心距9 mm),将其与旋转平移矩阵代入式(6)可解得zc。

图11 光平面标定过程

Fig.11 Optical plane calibration process

(5)将像素坐标系下光条框内光条中心坐标代入式(6),解出光条框内光条中心在相机坐标系下的坐标,并将结果保存。

(6)返回步骤(1)重复上述步骤至少两次,将得到的所有相机坐标下的光条中心拟合成平面,求取该平面下的法向量,该法向量即为线结构光在相机坐标系下的平面方程。

通过相机标定和光平面标定,获取了坐标系之间的转换关系,将像素坐标系下焊接点位(x,y)转换到世界坐标系(xw,yw,zw)下。

3 试验与误差分析

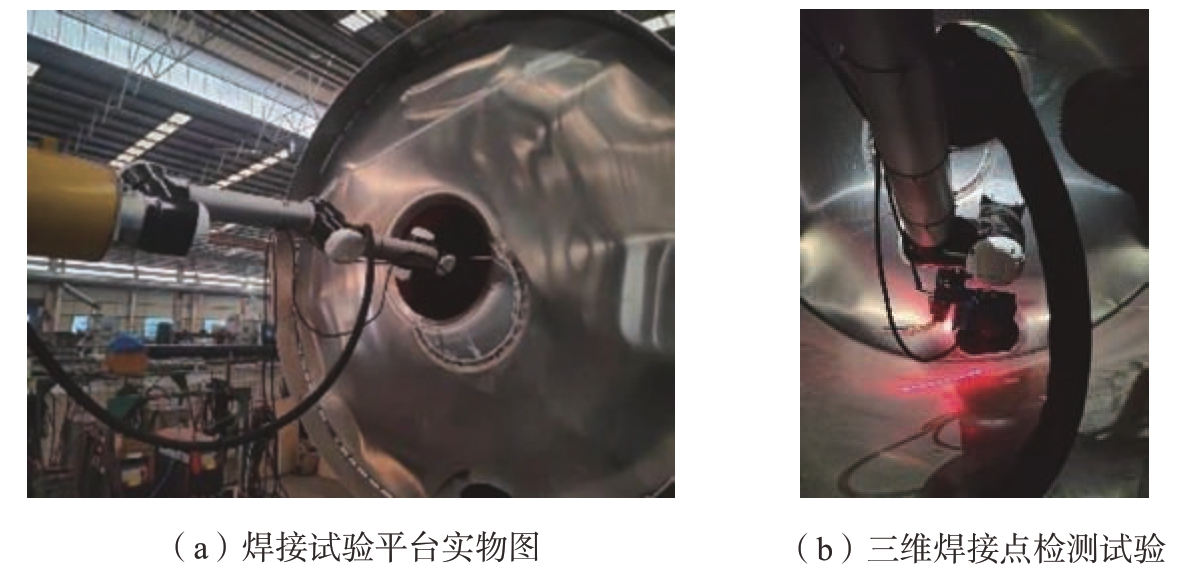

(1)搭建图12所示焊接点视觉检测平台。机器人选用“R–Sv10 协作机器人”,机械臂末端连接“Fast Mig X”焊机,相机选择焦距为12 mm 的镜头,靶面尺寸为(1/2)′(对角线尺寸为8.0 mm,水平尺寸为6.4 mm,垂直尺寸为4.8 mm)的工业相机。为了保证相机视野内没有遮挡,镜头的靶面尺寸应该大于或等于相机的靶面尺寸,选择镜头的靶面尺寸为(2/3)′。最终选型为海康威视130 W 像素相机MV–CA013–20GM,M1214–MP2 型号镜头。激光器使用波长为635 nm 的KYL635N10–22110型的激光器。

图12 工业现场焊接试验

Fig.12 Industrial field welding experiment

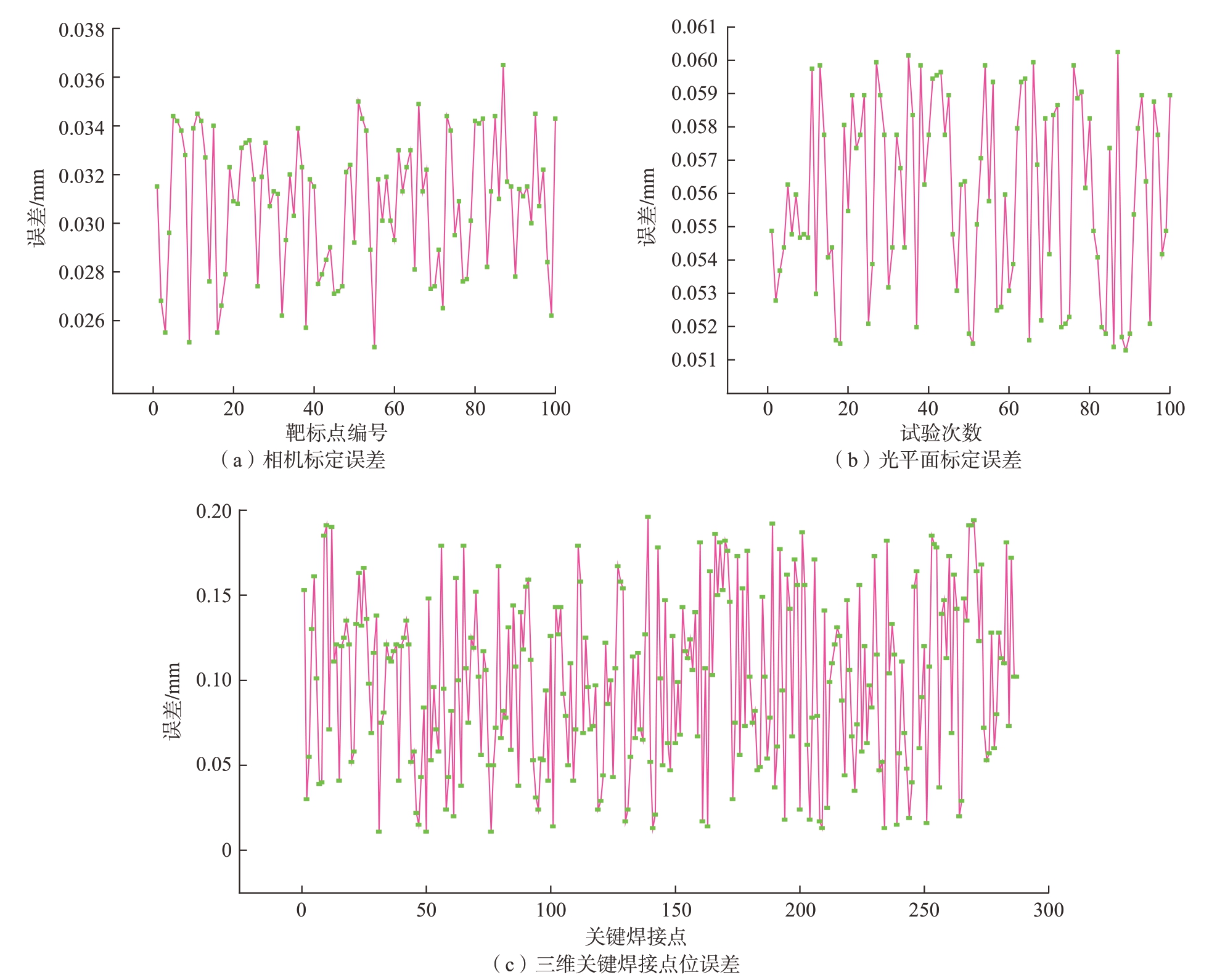

(2)为了验证上述方法的可行性和结果的精确性,对结果进行精度评价,所得误差如图13所示。

图13 误差分布

Fig.13 Error distribution

相机标定结果如表1所示。下面对相机标定进行精度评价,建立如图14所示的世界坐标系(Zw = 0),相邻圆心距9 mm,记录各个靶标圆心坐标(xw,yw),将所有像素坐标系下靶标圆心根据标定结果求取圆心(x.w,y.w),利用式(7)计算误差。得到的平均误差为0.037 mm,误差分布如图13(a)所示。

图14 世界坐标系

Fig.14 World coordinate system

表1 标定结果

Table 1 Calibration result

参数名称矩阵..内参矩阵■■■■■2533 433840670 71698 02533 55347 499 651245 0 0 1..■■■■■畸变校正矩阵[–0.0856772438 0.107370347–0.0000211832994 0.000991282286–2.29385161]-.0 9957669970 0251848903 0 088395603 0 0202076640 998183548 0...相机旋转矩阵■■■■■-.0567564107 0 0896644443 0 0547298938 0 994467139..-..■■■■■相机平移矩阵/mm[–63.8852844–43.3419418 321.692017]T

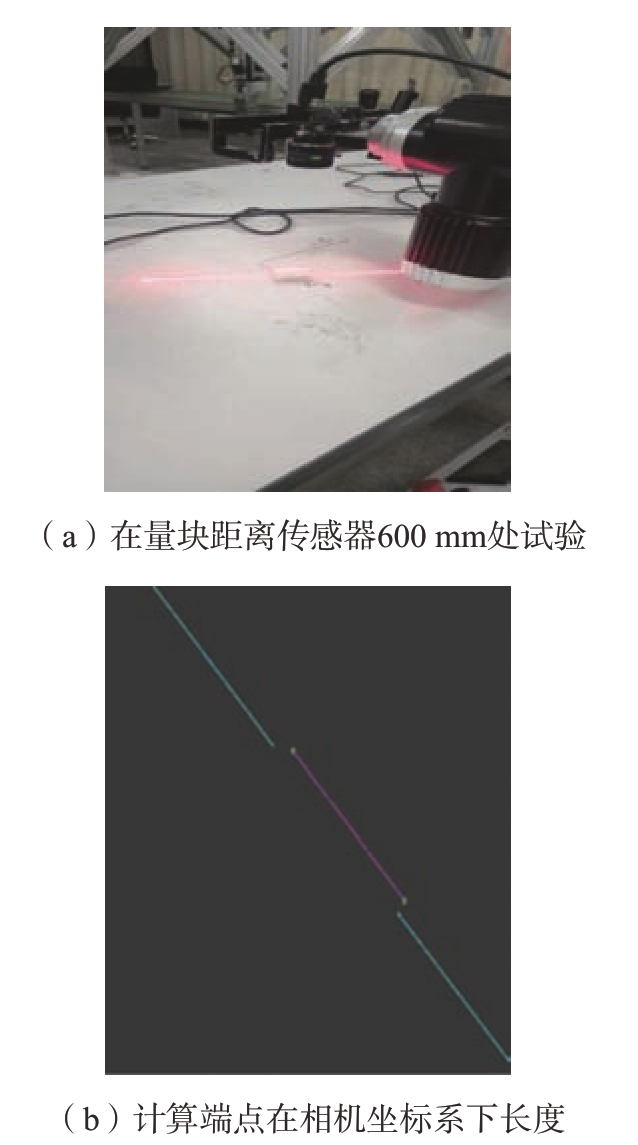

对光平面标定进行精度评价,本文通过3 条光条拟合光平面,利用长20 mm、高1 mm、宽10 mm,加工误差为± 0.001 mm 标准陶瓷量块对该标定方法进行误差分析。传感器在距离量块600 mm 处试验,提取光条中心,检测出在相机坐标系下光条中心点坐标中zc 高于均值的点,提取端点计算长度,如图15所示。重复上述过程100 次,采用方差作为误差评判指标。得到的最大误差为0.060 mm,均方差为0.056 mm,误差分布如图13(b)所示。

图15 光平面标定精度评估

Fig.15 Optical plane calibration accuracy evaluation

对三维关键焊接点位进行精度评价,本文使用结构光视觉传感器扫描200 ~ 300 mm 的路径,重复10 次获取287 幅具有焊缝特征的光条图,获取像素坐标系下关键焊接点位的坐标(x.,y.),手动标注焊接点位(x,y),将其转换到相机坐标系下,记为(x.c,y.c,z.c)和(xc,yc,zc),从而求取误差。最终提取最大误差为0.196 mm,平均误差为0.099 mm,误差分布如图13(c)所示。

4 结论

本文针对大型压力容器内部防浪板非标准焊接,研究了三维焊接点定位问题,设计了结构光视觉引导的工业机器人三维焊接点实时检测方法。主要结论如下。

(1)搭建了以机器人为主体,由相机、激光器、焊机、控制中心、悬臂梁组成的焊接点视觉检测平台。

(2)设计了三维焊接点实时检测方法,使用定位回归识别网络提取焊缝图ROI,之后拟合直线和曲线,取交点为二维关键点,最后通过系统标定结果求出三维焊接点位。该方法解决了铝合金罐体反光干扰的问题,误差分析和工业现场试验得出,相机标定平均误差为0.037 mm,光平面标定最大误差为0.060 mm,均方差为0.056 mm,三维焊接点检测最大误差为0.196 mm,平均误差为0.099 mm,程序计时得出平均检测时间0.09 s,三维焊接点检测精准、快速,可以满足后续机器人罐内焊接路径规划和自动焊接任务。

[1]俞隽,李泷杲,李根,等.一种基于多线结构光视觉引导的工业机器人定位方法[J].航空制造技术,2020,63(22):84–91.YU Jun,LI Shuanggao,LI Gen,et al.An industrial robot positioning method based on guidance of multi-line structured light vision[J].Aeronautical Manufacturing Technology,2020,63(22):84–91.

[2]郭吉昌,朱志明,于英飞,等.焊接领域激光结构光视觉传感技术的研究及应用[J].中国激光,2017,44(12):7–16.GUO Jichang,ZHU Zhiming,YU Yingfei,et al.Research and application of visual sensing technology based on laser structured light in welding industry[J].Chinese Journal of Lasers,2017,44(12):7–16.

[3]MA Y K,FAN J F,DENG S,et al.Efficient and accurate start point guiding and seam tracking method for curve weld based on structure light[J].IEEE Transactions on Instrumentation and Measurement,2021,70:1–10.

[4]刘涛,左继业,张晓森,等.环形焊缝的双目视觉定位与跟踪研究[J].机械科学与技术,2021,40(6):928–933.LIU Tao,ZUO Jiye,ZHANG Xiaosen,et al.Study on binocular vision location and tracking of circular seam[J].Mechanical Science and Technology for Aerospace Engineering,2021,40(6):928–933.

[5]张世宽,吴清潇,林智远.焊缝图像中结构光条纹的检测与分割[J].光学学报,2021,41(5):88–96.ZHANG Shikuan,WU Qingxiao,LIN Zhiyuan.Detection and segmentation of structured light stripe in weld image[J].Acta Optica Sinica,2021,41(5):88–96.

[6]解晓童.基于主被动视觉传感的机器人焊接过程焊缝跟踪与熔池监测研究[D].上海:上海交通大学,2020.XIE Xiaotong.In situ studies of full field strain and residual stress of welding heat affect zone using digital image correlation[D].Shanghai:Shanghai Jiao Tong University,2020.

[7]CHEN S F,LIU J,CHEN B,et al.Universal fillet weld joint recognition and positioning for robot welding using structured light[J].Robotics and Computer-Integrated Manufacturing,2022,74:102279.

[8]DU R Q,XU Y L,HOU Z,et al.Strong noise image processing for visionbased seam tracking in robotic gas metal arc welding[J].The International Journal of Advanced Manufacturing Technology,2019,101(5):2135–2149.

[9]FAN J F,JING F S,YANG L,et al.A precise seam tracking method for narrow butt seams based on structured light vision sensor[J].Optics &Laser Technology,2019,109:616–626.

[10]LI X H,LI X D,KHYAM M O,et al.Robust welding seam tracking and recognition[J].IEEE Sensors Journal,2017,17(17):5609–5617.