制造业是立国之本、强国之基,我国以《中国制造2025》为行动纲领,实现从制造大国向制造强国的历史性跨越。以航空为代表的先进制造业融合数字化技术,推进MBD(Model based definition)技术在制造领域的全流程应用[1]。但产业中的部分装配环节,由于仍以工人作为生产活动的主体,数字化技术难以深入应用,仍沿用传统的制造方式。

在目前的装配制造条件下,负责装配的工人需从图纸、指导书或数字化系统中获取信息,经过自身的理解消化,才能正确执行负责的装配工作[2–3]。面对快速改进和迭代的型号生产,作为生产主体的工人,难以快速跟进数字化设计系统的改变。随着数字化技术在上下环节不断深入,人工参与度高的环节已成为阻碍生产效率进一步提升的瓶颈。

投影标示技术属于空间增强现实技术(Spatial augmented reality,SAR)的一种[4–5],其特点在于,基于标定的视觉–投影系统,利用视觉传感的方式识别并解算待标示工件的空间位姿信息,再通过投影将所需的加工信息直接显示在零部件外表面。相比于通用意义上的空间增强现实技术,投影标示技术更加强调显示精度,侧重与生产制造领域的结合,应用于航空装配制造环节时,工人无需佩戴任何设备,仅凭自身裸眼即可获取所需的数字化信息,且满足多人协作和长时间作业要求。典型场景有飞行器大型零部件装配、管线装配、机身外表面涂装等。

本文将从投影标示的技术出发,介绍建立投影标示系统所需的标定、感知、映射3 大技术,以行业内国外典型的成功案例说明其在航空装配制造环节的重要作用,总结国内目前的研究现状和进展,最后指明研究的挑战和发展趋势。

1 投影标示技术

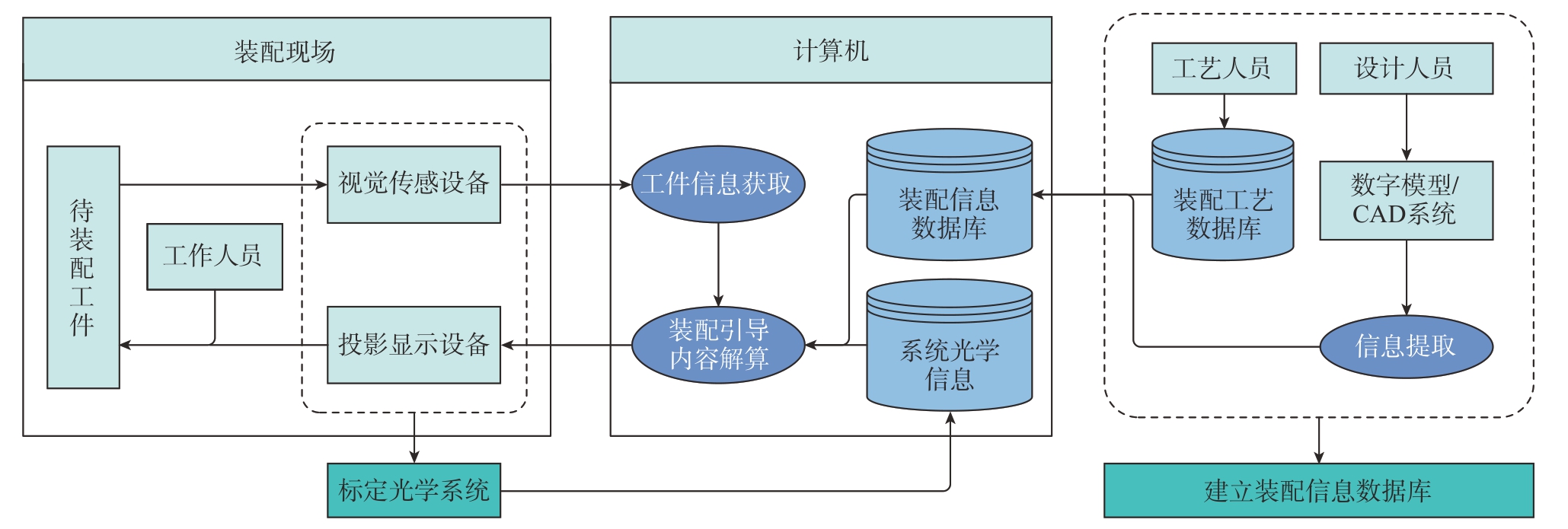

图1 展示了基于视觉传感的投影标示系统结构,分为离线与在线两部分。离线部分包括建立装配信息数据库与标定光学系统,这部分工作需在装配进行前完成。目前,在航空制造领域,技术上已能够实现产品的数字化定义,因而可以通过读取设计与工艺人员在研发阶段定义的制造信息,形成一套装配信息数据库作为装配引导信息的可靠来源。同时,对于高精度的投影标示系统来说,其光学组件标定的精度从根本上决定了系统整体的精度。

在线部分的技术流程与装配操作紧密结合。首先,基于机器视觉的方法,利用视觉传感设备获取工件的型号、位姿等信息。然后,计算机内的软件算法根据工件信息,结合预存储的装配信息库内容,计算装配引导的投影内容,基于系统光学信息渲染标示内容。最后,在工件表面标示信息的引导下,工作人员能够直接执行装配任务,无需查看图纸、指导书等材料。

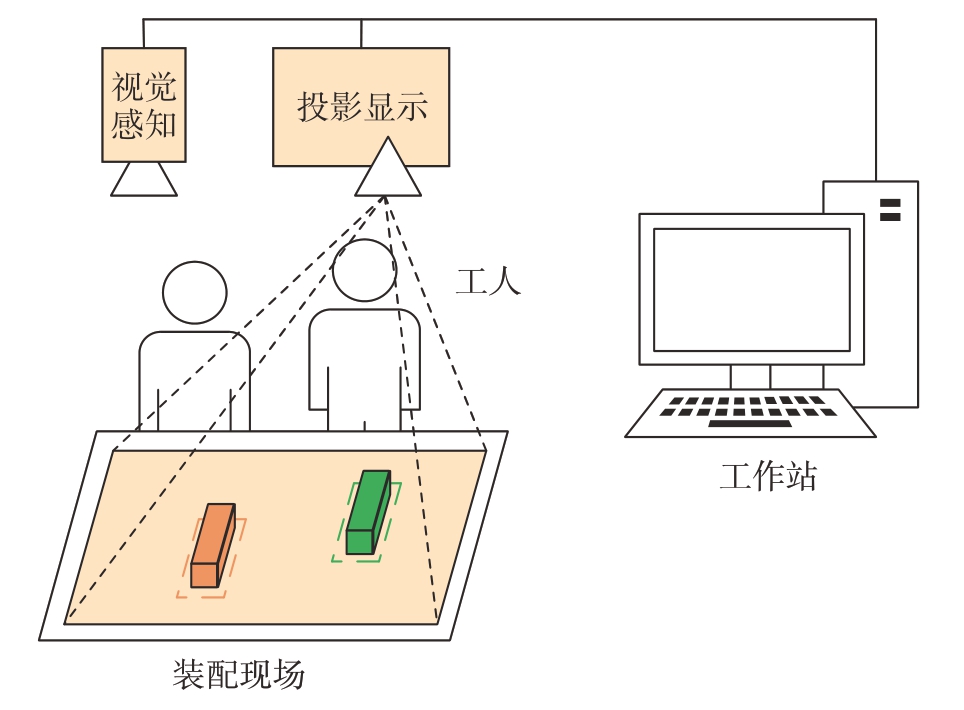

典型的基于视觉的投影标示系统如图2所示,由视觉感知设备与投影显示设备组成,工作站用于处理投影标示信息。其中,视觉感知与投影显示设备的光学特性与物理空间位姿关系通过离线的标定过程确立。基于此类系统,工人只需按照投影的引导信息进行装配作业,且投影标示信息多人共享,具备良好的协同工作基础[5],操作人员仍面对的是日常的物理空间,不会出现环境感知和空间感知障碍。

图2 典型的用于投影标示的投影–相机系统

Fig.2 Typical ProCams system for projection indication

目前,除投影标示外,还有许多基于增强现实(Augmented reality,AR)技术进行装配辅助的研究。相关研究表明,相比于纸质说明书、光学穿透式AR、视频穿透式AR 以及基于屏幕的AR 等显示方式,投影标示技术带来的认知负担大幅降低,也意味着效率的提升[6–8]。其原因在于:(1)投影标示环境下的操作者可以集中注意力于装配制造环节,无需在多个显示介质间来回切换;(2)引导内容直接显示在物体表面并保持相对静止,避免对操作者带来额外的认知负担,使其能够长时间工作;(3)学习掌握的门槛低,引导内容均呈现在工人熟悉的工作环境中,便于快速理解和开展工作。

2 投影标示的关键技术

作为SAR 技术的分支,投影标示的起源可追溯到20世纪60年代,工作人员预先录制歌手头部的视频影像,再将其投影到对应的半身像表面,使雕像变得栩栩如生[5,9]。在学术界,Raskar 等[10] 的“Office of the Future”最早擘画了技术框架。首个通过投影使场景实物与计算机生成内容融合的系统Shader Lamps 也由Raskar 研发[11],他还提出一种解决随意布置的投影–相机系统标定问题的方法[12],克服精确布置与维护的繁琐。之后的Dynamic shader lamps[13]是针对前者的改进。与Raskar 同时,Underkoffler 团队[14–16]的Luminous room为学术界提供了一个概念性框架,并摆脱了经典的矩形屏幕限制,在实际物体表面进行图形显示和交互。

结合图1 展示的系统结构图,投影标示的关键技术可以总结为光学系统标定、视觉传感及投影映射3 部分,对应投影标示系统的模型构建、目标工件定位和装配信息标示。

图1 基于视觉传感的投影标示系统结构图

Fig.1 Structure diagram of projection indication system based on visual sensing

2.1 光学系统的几何标定

投影标示的光学系统可归类为投影–相机(ProCams)[17]系统,主要面向制造领域,因而系统标定的重点在于实现高精度的几何标定。投影–相机系统的标定从标定视觉传感部分开始[18]。经典的相机标定方式为采集一组任意位姿的平面标定板图像,标定板虽然样式各异[19–22],但其核心意义在于提供稳定的视觉特征。最有代表性的是Zhang[23]提出的方法,基于此方法,后续研究者提出了许多改进方法,如Richardson 等[24]在采集图像前引入解算最佳拍照位姿的算法。Zhang[23]的方法又称为两步法,先利用线性求解得到相机的一部分参数,再引入非线性的畸变部分进行优化。线性部分的求解增加了稳定性,但仍存在非线性优化部分,迭代的过程造成计算速度降低、复杂度提高[25]。后续Martins 等[26]改进的双平面标定方法,可以直接利用线性求解,但存在稳定性、可靠性较弱的缺点。

投影光机的标定精度决定了引导信息的准确度。经典的投影仪标定算法,也可以称为坐标映射法。投影仪投射编码图案,再由相机采集编码图像,通过求解相位建立投影像素与图像像素间的映射关系。基于此映射关系,投影仪标定问题被转换为成熟的相机标定问题[27],其改进主要在精度和速度方面[28–31]。典型的有孙丽君等[32]提出的基于局部单应性的投影仪精确标定方法,以及周舵等[33]提出的基于1P2C(1Projector 2Cameras)系统的方法。

虽然坐标映射的方法可靠有效,但灵活性欠佳。另一类标定投影的方法基于坐标变换,该方法将特征点模板投射到标定平面。特征点的投影像素位置已知,再通过各种方法获得其三维坐标进行标定。此类方法的优点在于标定过程复杂度降低,主要包括Yang 等[34]提出的通过双目系统重建的方式;杨建柏等[35–36]提出的基于交比不变性消除相机引入误差的方法;徐维鹏等[37]采用深度相机,提出基于深度–颜色图对准的标定方法。为进一步优化系统整体的重投影误差,还可以采用联合标定的方法[38]。

此外,学术界也存在投影–相机自标定的方法,难点在于需要同时估计投影–相机系统的众多参数,并解决算法对输入图像及投影–相机对应关系的敏感性[39–43]。Yang 等[39]研究了面向大视场的标定方法,降低所需标定板的尺寸,但引入了离焦误差。Shahpaski 等[40] 在Audet[41] 和Chen[42]等的基础上进行算法的完善与流程的简化,方法简单有效。Li等[43]提出一种基于贪婪下降优化的方法解决系统的自标定,相比于Yamazaki[44]、Resch[45],Li[43] 等的方法更加完备,不但解决了忽略的部分标定参数问题,而且在面对图像噪声干扰时更加稳定。

2.2 视觉传感技术

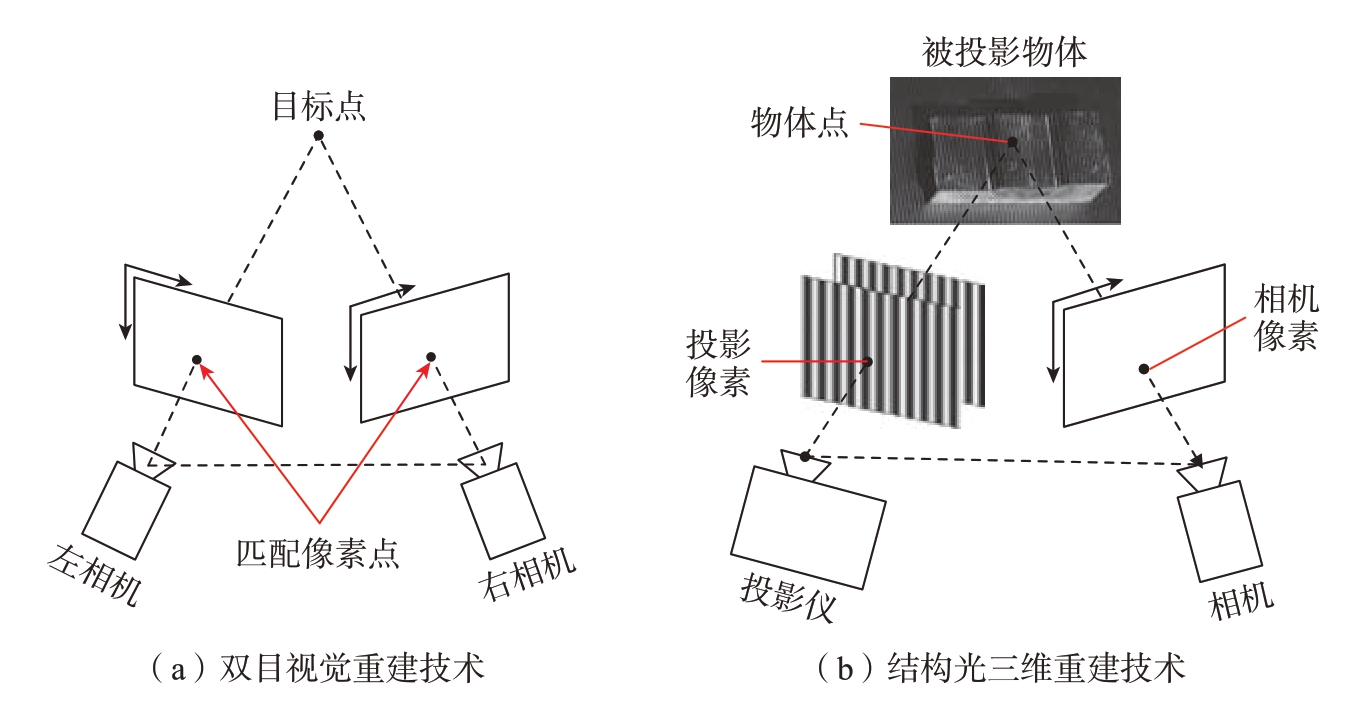

因为标示信息投影至物理实体表面,所以物理实体的三维空间位姿信息必不可少。一般采用视觉三维重建的方法进行场景信息的感知。场景的精确传感建立在光学系统准确标定的基础上。常用的三维重建方法有双目视觉重建与结构光重建,如图3所示。

图3 三维重建原理图

Fig.3 Schematic diagram of 3D reconstruction

双目视觉重建利用双目相机拍摄在同一时间下目标物体的左右视图,通过算法检索两幅图像中匹配的像素点,再利用匹配像素点之间的位置差,根据视差原理计算匹配像素点的三维空间信息[46]。其中,立体匹配是重难点。传统立体匹配可分为局部匹配、全局匹配及半全局匹配[47]。局部匹配算法运行快[48],但是精度低;全局匹配算法效果较好[49],但是计算速度慢[50]。半全局立体匹配算法中,Hirschmüller[51]的方法应用最为广泛,利用线扫优化,降低了计算复杂度,效果接近全局匹配算法。目前随着深度学习的发展,立体匹配越来越多地采用卷积神经网络,其效果大幅超越传统算法,如已经提出的基于CNN(Convolutional neural network)计算匹配代价[52],基于CNN 进行视差回归[53]以及融合多个网络[54]的方法。

结构光三维重建技术属于典型的主动光学测量方法,物体表面被投射预编码图案,编码图案在物体表面产生变形,由相机捕获变形图案信息,借助系统空间标定关系和变形图案解调即可得到物体的深度信息,进而恢复三维形貌。相比于上文的双目立体视觉法,由于编码图案的存在,结构光可用于对表面纹理信息较少的对象进行重建。此外,单个像素点独立编码,因此其中任一点不受邻域像素点影响,在理想状态下能够达到微米级测量精度[55–56]。左超团队使用复合相移技术及多视角物体图像实现了实时动态的三维重建[57–59]。基于相位测量技术对高速的动态目标进行误差补偿,同样实现了高精三维重建[60–61]。近年的相关研究表明,深度学习的引入提高了数据处理和三维重建速度[62–63]。此外Wu 等[64–65]的方法,也实现了复杂场景的高效可靠三维形貌测量。

2.3 投影映射技术

2.3.1 刚体动态投影映射

投影映射的早期研究集中于静态或缓慢移动的对象,这是由于动态对象投影的相关算法极大地增加了对系统的运算性能需求。近几年,随着计算机硬件的快速迭代以及高速相机与投影仪的商业化应用,越来越多的研究者开始从事动态投影技术的研究[18],对投影标示技术的实际应用具有较大意义。这里的动态是指对象的刚体动态变换或投影与相机的自由移动。进一步地,还有研究者针对非刚体、动态、未知平面进行投影映射,提出了实时估计完整表面信息的需求。此外,作为面向人机交互领域的技术,研究者还需要了解人眼感知世界的基础与视觉延迟的关系,相关工作可参考文献[66–67]。

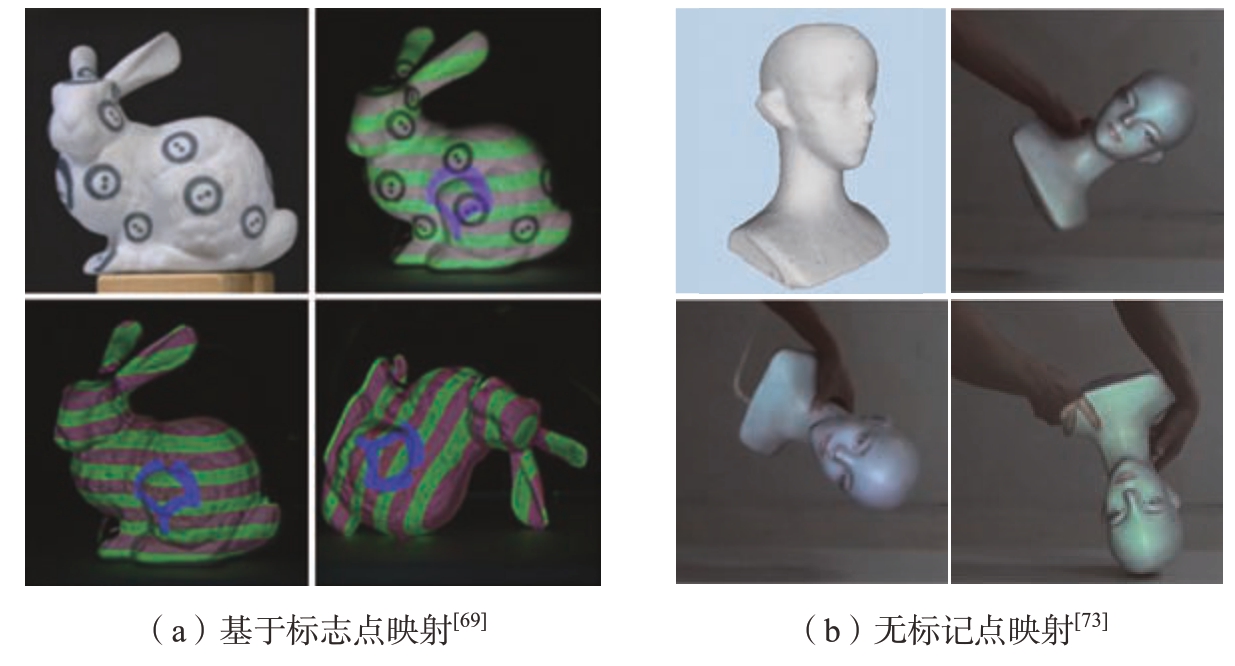

总体来说,对于刚体的动态投影无需完整的实时三维重建,仅需要系统与目标物体的位姿关系。较为经典的方法基于标志点跟踪,虽稳定可靠,但粘贴于物体表面的标记点成为物体表面材质的一部分,引入了视觉干扰。为解决该问题,Asayama等[68–69]通过投影补偿的方式实现标记点在视觉上的隐藏(图4(a))。Kitajima 等[70]则利用微型光电传感器,基于光栅扫描原理,确定目标物体在投影坐标系下的位置。也有针对无标记点物体的研究,该类方法通常基于点云的自然特征,如Resch等[71]采用稀疏点云重建方式进行辅助投影,采用迭代最近点的方法获取物体运动的位姿,进行投影映射。还有直接使用深度相机点云的方式,如Siegl 等[72]提出了自适应的实时投影系统,其算法兼容多设备协同。徐维鹏[37]则基于深度图对投影物体进行帧–模型的实时跟踪方法,实现动态跟踪并有效抑制了误差累积。此外,Hashimoto 等[73]利用红外相机进行了基于边缘特征的映射研究,如图4(b)所示。

图4 刚体投影映射近期进展

Fig.4 Recent progress on rigid body projection

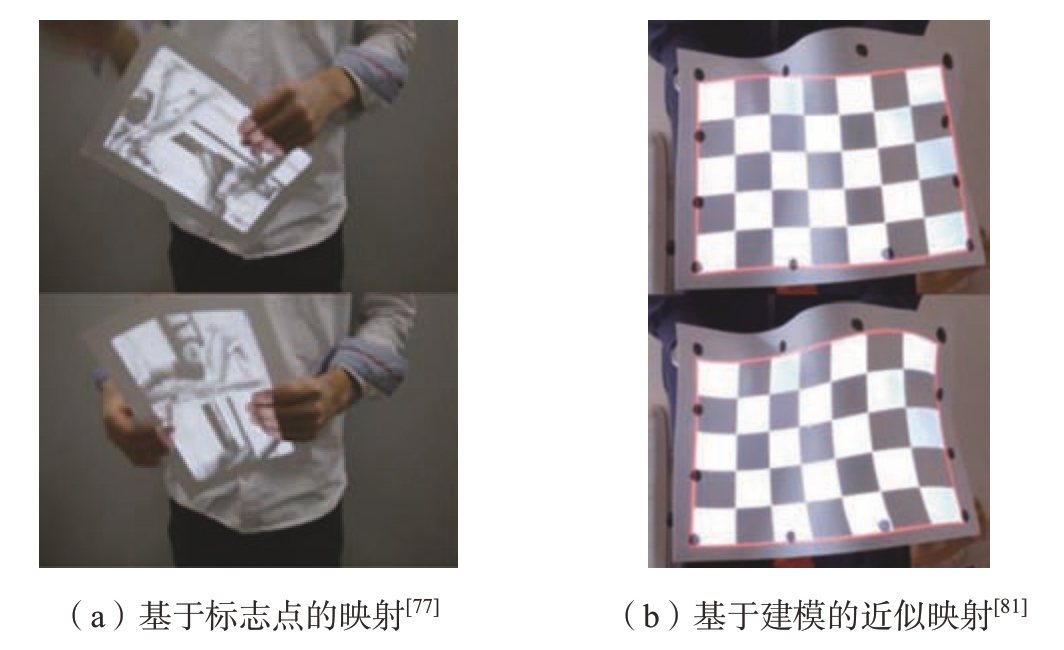

2.3.2 非刚体动态映射

非刚体的动态投影映射主要难点在于获得变形物体的变形信息。目前的方法主要有两类,一是基于标志点将柔软表面离散为多个小三角面;二是利用数学模型,采用近似的方法建立映射关系。Punpongsanon等[74–75]采用红外特征点,基于表面的红外散斑图形计算物体的非刚性形变,进一步解算投影信息。Narita等[76–77]基于高速红外相机进行了类似的研究,其后续工作进一步扩展到运动形变复合物体(图5(a))。类似地,Fujimoto 等[78]利用反射标记与预先设定的编码模板实现了同样的动态投影。此外,由于物体变形在边缘的变化比中心更为明显[79],Ibrahim 等[80–81]利用有理B 样条面片,建立弹性曲面的数学模型,基于边缘的特征点检测,实现非刚体对象投影映射(图5(b))。该方法依赖数学模型对变形的精准预测,所以其映射属于近似估计。

图5 非刚体投影映射近期进展

Fig.5 Recent progress on non-rigid body projection

3 航空工业应用及发展趋势

目前,制造业中传统的显示方式(如显示器、图纸等)以显示的便捷性为目的,利用二维的介质显示三维的内容。此类信息获取方式对从事装配作业的工人提出了一定的技术水平和工作经验要求。投影标示技术作为一种三维的显示方式,为解决以上问题提出了一种新思路。

3.1 航空工业应用

目前,投影标示技术的规模化应用主要集中在国外几个航空制造业发达的国家,且主要面向复杂产品制造领域[82–84]。对于复杂产品的制造系统,目前仍难以直接采用自动化设备进行数字化辅助制造。人工劳动参与是这类小批量、高柔性、快速迭代的产品的特点。其配套的数字化升级与生产效率提升应从增加辅助设备的渗透程度入手,以优化人工的操作效率为目标。国外的空客、波音、洛马、诺格等大型航空制造企业,均有面向实际生产或小规模试运行的投影标示应用。国内的西飞、商飞以及成飞等企业也引入了相关系统。表1 总结了国外的商业化投影标示系统。

表1 商业化投影标示系统

Table 1 Commercial projection indication system

公司产品特点功能国家8treex–Check 系列便携检测结果可视化以色列EXTEND3DWerklicht 系列固定式、便携辅助装配德国LAP–LASERCAD–PRO固定式辅助装配德国SL–LASERPRODIRECTOR固定式辅助装配德国DELTA SIGMAProjectionWorks固定式信息显示、辅助装配美国FAROTracer固定式辅助装配美国GERBERViRTEK IRIS固定式辅助装配加拿大DiotaDiotaPlayer固定式辅助装配法国

以美国航空制造业广泛采用的DSC(Delta Sigma Corporation)的ProjectionWorks 系列产品为例,AssemblyWorks、PaintWorks 及HarnessWorks 分别面向航空制造中的紧固件安装和检测、飞行器外观喷涂及线束的安装指导。基于投影标示技术,这些工程化的产品能够将工艺规范以及图纸上的装配信息投影到工件三维曲面,并且与数字化系统深度融合,实现提高装配效率,降低劳动强度及返工率的目的。据DSC的公开资料显示,该系统使劳动强度降低71%,误差减少69%,返工率降低92%。有研究表明,投影标示技术的引入大大降低了工人理解装配任务的时间[85]。

图6[85] 展示了AssemblyWorks在美国F–35 战机的中机身装配应用场景。紧固件的安装信息被投影到待装配部件表面,工人按照投影至工件表面的引导信息,个人独立或多人协同完成指定任务。传统的方式依赖划线、预制件、夹具、型架等辅助[86],消耗大量的人力物力,且没有充分利用数字化技术的优势,无法做出快速调整。此外,在运用数字化检测设备的基础上,将检测信息与标示系统互联即可实现可视化检测,能够帮助工人直观观察到装配工作是否合格,使工人在装配现场做出迅速地判断,进而采取调整措施,提升工作效率。

图6 投影标示系统在F–35 中机身装配的应用[85]

Fig.6 Application of projection indication systems in F–35 fuselage assembly[85]

飞机线缆敷设和安装工作的困难与装配零部件类似,线束与导管需按规定路径进行布置。为解决线缆装配问题,洛马公司曾采用布置大型屏幕于装配现场的方式辅助工人正确地执行敷设任务,并进行检验。但其后续实践表明,投影标示技术辅助线缆敷设的效果更佳。这是因为线缆的路径在传统的显示方式下仍不够直观,装配过程中容易出现错漏装等失误[85]。而采用投影标示技术后,敷设信息直接显示于安装位置,减少了反复切换观察对象带来的负担与错误率。

3.2 技术发展趋势

面向工业制造领域,投影标示技术的未来发展趋势如下。硬件设备上,主流的基于DMD 的投影仪已能普遍实现60 Hz 以上的刷新率,能够满足一些常见制造环节的标示需求。但面向航空制造的大型零部件,需要在投影光场的分辨率、投影画面的景深等方面做进一步研究。分辨率的提高可以从根源上提升标示的精度与内容的丰富程度;大景深的投影设备则能够降低航空大部件的投影标示系统维护成本,消除目前采用多套投影设备的冗余性。此外,还有系统组成的结构性问题,需要深入分析,突破传统的固联式ProCams 架构,提出新的系统模型。

软件算法层面,投影标示技术仍有亟须解决及优化的问题。首先是标示内容解算,如前文所述,较为依赖上下游制造环节的数字化信息,该问题可随着数字化技术的进一步发展解决。其次是目前缺少一套具有系统性理论支撑的标示范式,正如

WIMP(Window icon menu pointing)之于桌面系统,探索引导内容与装配效率之间的关系也是需要研究的内容之一。最后是人机交互方面,标示系统面向多人协同的制造场景,与目前增强现实的交互环境略有差异。未来在实现标示内容自动化解算的过程中也可以研究相应的智能算法,依据工人的操作实现自适应的引导,进一步提高人机协同效率。

4 国内研究现状及挑战

国内众多科研机构也开展了相关的技术研究和系统开发,目前国内研发的标示系统仍以固定式为主,主要面向装配引导、投影划线以及检测结果可视化任务。其中,面向装配引导领域的研究最多,投影划线领域的研究更加侧重于精度,检测结果可视化的系统则强调一体化协作。

4.1 装配引导系统

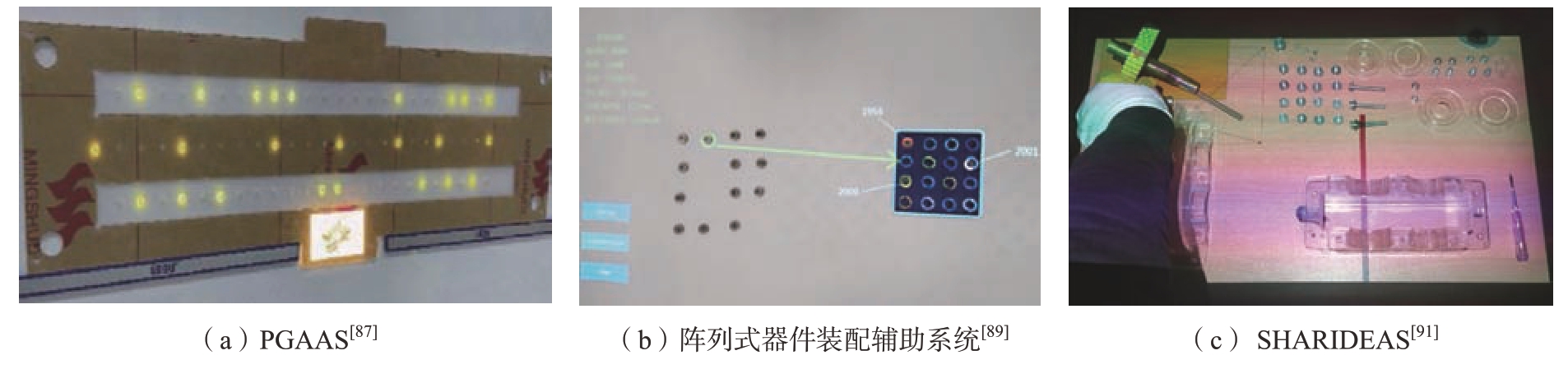

装配引导系统主要面向零件种类繁多、位置和工艺复杂的装配任务。该类标示系统通过在主要部件表面投影辅助装配信息对装配零件的工人进行引导,从而提升装配效率。面向航空制造,秦玉波等[87]研发了投影引导辅助装配系统(Projectionguided auxiliary assembly system,PGAAS),如图7(a)所示。试验表明,PGAAS 相比于查阅手册与表面标记的方法,装配耗时减少、错装率低,且满足航空装配制造领域的精度要求[88]。吴天航等[89]为解决阵列装配最优化问题,提出应用投影标示技术辅助人工装配(图7(b)),对比试验显示,相比于传统方法,在该系统的辅助下人工效率提升62.5%。此外,Wang 等[90–91]提出的面向存在遮挡的高精度装配场景的标示系统和具备智能人机协同的系统SHARIDEAS(图7(c)),Chen 等[92]研发的视点跟踪三维投影装配辅助系统,均在装配引导领域展现了投影标示系统相比于传统方法的高效性。

图7 面向装配引导的投影标示系统

Fig.7 Projection indication systems for assembly instruction

4.2 投影划线系统

在航空工业及其他大型装备制造业中,划线工作广泛地应用于生产中,典型场景有大型金属构件装配、复合材料敷贴等,通常由钳工完成划线,要求线条清晰并保证精度。为解决依赖人工划线的问题,研究者们采用振镜–相机系统进行光学标示,该系统与投影–相机系统类似。激光光线通过MEMS 系统(Microelectro-mechanical system)控制的振镜表面,经多次反射,照射到目标点上。在成像原理上,基于角度控制的激光光束相比基于像素控制的投影面具备高清晰度与高精度的特点,并且不受景深限制,因而适用于高精划线工作。

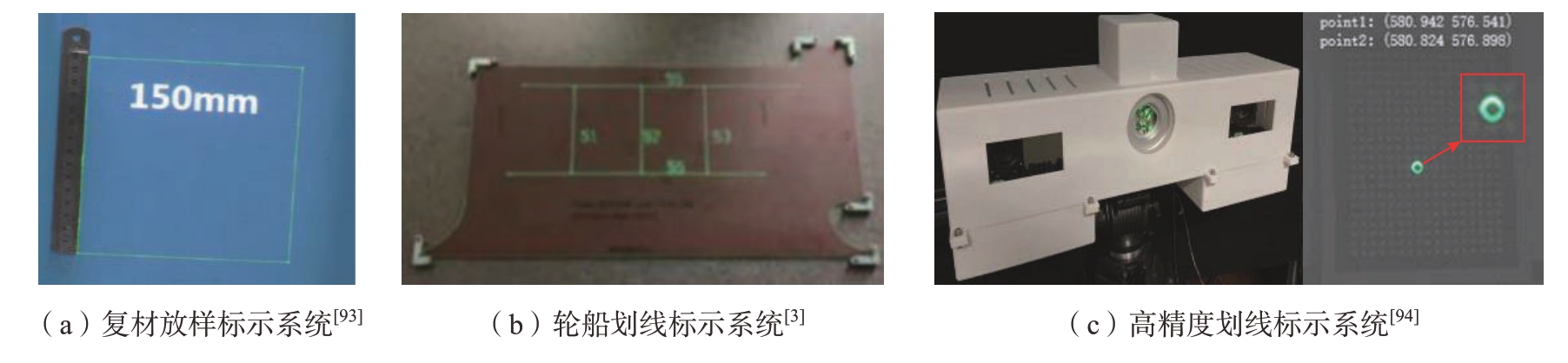

对于航空制造领域的复合材料放样、敷贴极度依赖手工高精度定位的问题,刘邈[93]研究了光学三维标示系统,在800 mm 的工作距离下,标示误差在0.17 mm 以内(图8(a))。Zhu 等[3]为解决造船业装配中制版、划线过于依赖工人技术的问题,基于光学投影与视觉技术,研发了一套激光辅助划线系统,取得了显著的效果,但目前该系统仅能应用于平面基板,距实际大规模应用仍需增加对曲面的研究(图8(b))。赵祖阳等[94]基于变焦相机,面向大视场环境进行了高精度投影划线系统研究,在3000 mm 的工作距离下投影精度可达0.3 mm(图8(c))。

图8 面向激光划线的投影标示系统

Fig.8 Projection indication systems for laser scribing

4.3 装配检测结果可视化系统

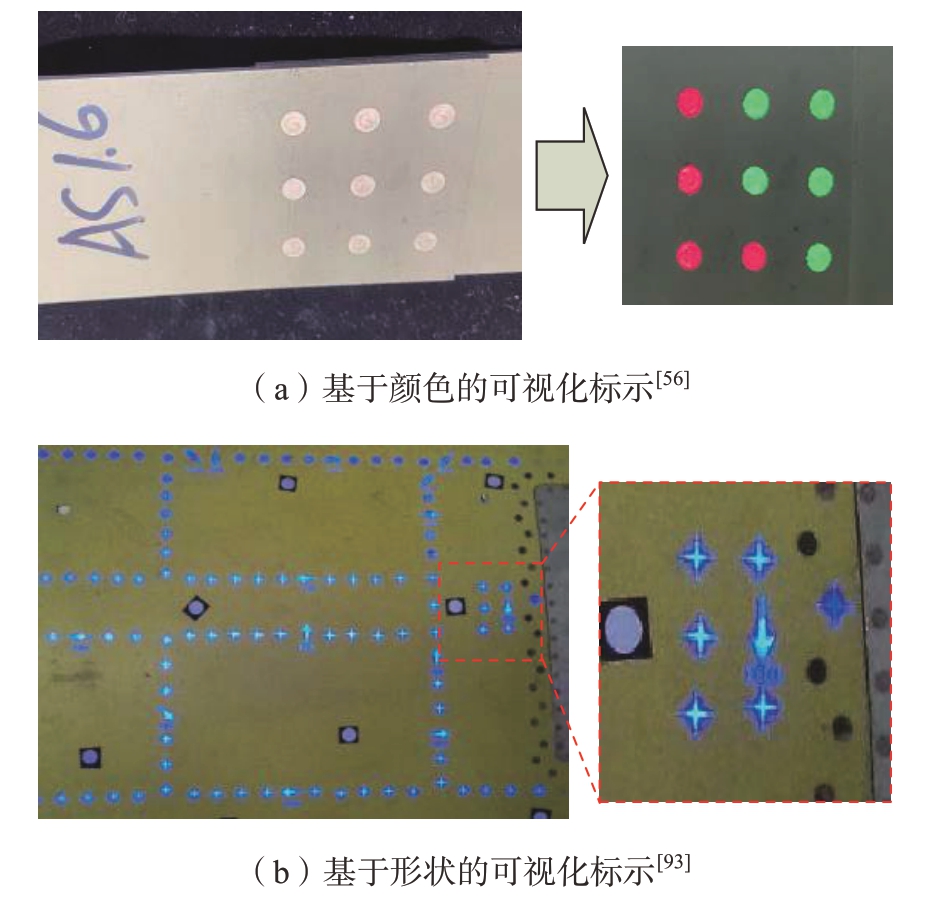

在组成结构上,基于视觉的投影标示系统与结构光测量系统十分类似,因而可以利用同一套ProCams系统实现检测与可视化。检测部分利用结构光三维重建原理,可视化部分采用投影标示技术。在航空制造业中,典型场景为飞机机身蒙皮铆钉阶差检测及其可视化,目前的检测手段需要人工手持接触式仪器测量,该过程需要大量的人力且无法避免出错。针对这一问题,国荣辉[56]与刘邈[93]分别进行了相关研究。二人基于结构光对待测对象进行三维重建,基于检测结果,利用标示技术进行投影,前者采用DLP4500 光机,进行颜色上的标示(图9(a)[56]);后者利用蓝光投影光机,通过形状进行检测结果的可视化表达(图9(b)[93])。

图9 面向检测结果可视化的投影标示系统

Fig.9 Projection indication systems for visualization of the inspection results

4.4 挑战

作为一种面向工业生产的人机交互方式,投影标示技术融合了多领域的研究成果,需结合实际的产业进行深入探索。根据对国内研究情况的总结,并面向航空工业需求,现阶段投影标示技术在研究深度以及产业化方面存在如下技术挑战。

(1)动态场景应用。

这里的动态场景指快速运动的刚体,以及软性材料加工制造的投影标示[95]。在投影标示技术中,需要基于机器视觉等方式确定目标物体的空间位姿。这是正确进行投影映射的基础,又被称为对象跟踪[96]。落实到投影标示技术中带来的挑战是投影光对获取图像的影响。投影光线叠加到物体表面会对视觉算法的特征提取带来较大的干扰,还有目标快速移动提出的对目标跟踪的精度以及实时性要求。另外,学术界使用红外标记辅助重建变形表面,或用近似的方式拟合变形关系。以上方法虽可以实现对非刚体材料的表面映射,但是并不适用于工业场景,无法满足产业化的需求。

(2)复杂狭小场景应用。

目前对于狭小舱段内表面的装配问题,缺少有效完整的解决方案[97]。以美国F–35为例,其机身舱段内布置多台投影系统,以克服场景内复杂结构的遮挡[85],但多台系统组合使用时,受投影角度、景深和范围的限制,不能有效解决封闭舱段内的狭小空间的受限问题。目前仍无突破性的解决方法。这类问题可归纳为系统的低灵活性问题,属于传统的自引导式ProCams 系统的结构性问题,需从系统的组成结构入手,研究解决方法。

(3)产业配套及维护。

投影标示落地应用的另一难点在于目前标示信息的定制极度依赖工人的工作量,缺少自动化处理数模及结合装配工艺生成标示内容的解决方案。产生这一问题的主要原因是标示内容的自动化解算依赖MBD技术。产业中的数字化程度越高,投影标示技术的应用越便捷。此外,根据国外的实际经验,投影标示技术对装配效率的提高是毋庸置疑的,但是对于某些成熟型号产品及长期从事该型号生产的工人来说,由于已形成肌肉记忆及装配习惯,引导信息带来的效率提升不明显。因而需要系统性的理论支撑进行投影标示的应用范式研究,探索高效且具有差异化标示信息的组织架构。

5 结论

在航空制造业采用投影标示技术具有重要意义。在目前人工装配无法被数字化、自动化技术替代的前提下,研究面向装配引导的投影标示技术,是进一步提升行业数字化程度及生产效率的新途径。投影标示技术从改变信息的显示方式入手,结合数字化系统,将任务目标信息直接呈现于待作业的部件表面,能够最大程度降低工人的认知负担。

从产业应用的角度,投影标示技术的规模化应用离不开行业整体的数字化升级助力,以及智能制造技术的推广。作为一个多学科交叉的技术领域,涉及的标定、传感、映射技术虽较为成熟,但未来的发展仍需各相关领域的科研工作者开展深入研究,实现产学研的一体化。

[1]郭洪杰,冯子明,张永亮,等.以模型为核心的飞机智能化装配工艺设计[J].航空制造技术,2017,60(11):64–69.GUO Hongjie,FENG Ziming,ZHANG Yongliang,et al.Design on aircraft smart assembly based numerical model[J].Aeronautical Manufacturing Technology,2017,60(11):64–69.

[2]刘镇阳,翟雨农,李东升,等.飞机复合材料壁板装配变形控制技术研究与应用进展[J].航空制造技术,2022,65(18):46–54,78.LIU Zhenyang,ZHAI Yunong,LI Dongsheng,et al.Research and application progress of deformation control technology for aircraft composite panel assembly[J].Aeronautical Manufacturing Technology,2022,65(18):46–54,78.

[3]ZHU Y,YANG J,ZHANG H W,et al.Intelligent assembly assistance for hull structure construction based on optical projection[J].Assembly Automation,2022,42(2):258–267.

[4]RASKAR R,WELCH G,FUCHS H.Spatially augmented reality[C]//First International Workshop on Augmented Reality.San Francisco,2018.

[5]袁庆曙,王若楠,潘志庚,等.空间增强现实中的人机交互技术综述[J].计算机辅助设计与图形学学报,2021,33(3):321–332.YUAN Qingshu,WANG Ruonan,PAN Zhigeng,et al.A survey on human–computer interaction in spatial augmented reality[J].Journal of Computer-Aided Design &Computer Graphics,2021,33(3):321–332.

[6]MARNER M R,IRLITTI A,THOMAS B H.Improving procedural task performance with augmented reality annotations[C]//2013 IEEE International Symposium on Mixed and Augmented Reality (ISMAR).Adelaide,2013:39–48.

[7]SCHWERDTFEGER B,KLINKER G.Supporting order picking with augmented reality[C]//2008 7th IEEE/ACM International Symposium on Mixed and Augmented Reality.Cambridge,2008.

[8]TANG A,OWEN C,BIOCCA F,et al.Comparative effectiveness of augmented reality in object assembly[C]//Proceedings of the SIGCHI Conference on Human Factors in Computing Systems.New York:Association for Computing Machinery,2003:73–80.

[9]MARNER M R,SMITH R T,WALSH J A,et al.Spatial user interfaces for large-scale projector-based augmented reality[J].IEEE Computer Graphics and Applications,2014,34(6):74–82.

[10]RASKAR R,WELCH G,CUTTS M,et al.The office of the future:A unified approach to image-based modeling and spatially immersive displays[C]//Proceedings of the 25th Annual Conference on Computer Graphics and Interactive Techniques.New York:Association for Computing Machinery,1998:179–188.

[11]RASKAR R,WELCH G,LOW K L,et al.Shader lamps:Animating real objects with image-based illumination[C]//Eurographics workshop on rendering techniques.Vienna:Springer,2001:89–102.

[12]RASKAR R,BROWN M S,YANG R G,et al.Multi-projector displays using camerabased registration[C]//Proceedings Visualization ’99(Cat.No.99CB37067).San Francisco,1999:161–522.

[13]BANDYOPADHYAY D,RASKAR R,FUCHS H.Dynamic shader lamps:Painting on movable objects[C]//Proceedings IEEE and ACM International Symposium on Augmented Reality.New York,2001:207–216.

[14]UNDERKOFFLER J,ULLMER B,ISHII H.Emancipated pixels:Real-world graphics in the luminous room[C]//Proceedings of the 26th annual conference on Computer graphics and interactive techniques.New York:Association for Computing Machinery,1999:385–392.

[15]UNDERKOFFLER J,ISHII H.Illuminating light:An optical design tool with a luminous-tangible interface[C]//Proceedings of the SIGCHI Conference on Human Factors in Computing Systems.New York:Association for Computing Machinery,1998:542–549.

[16]UNDERKOFFLER J.A view from the luminous room[J].Personal Technologies,1997,1(2):49–59.

[17]彭灵子.ProCams 系统的关键技术及其实现[D].杭州:浙江大学,2007.PENG Lingzi.The key technology and implementation of projector-camera based system[D].Hangzhou:Zhejiang University,2007.

[18]GRUNDHÖFER A,IWAI D.Recent advances in projection mapping algorithms,hardware and applications[J].Computer Graphics Forum,2018,37(2):653–675.

[19]ZHANG Z.A flexible new technique for camera calibration[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2000,22(11):1330–1334.

[20]HE H,LI H Y,HUANG Y B,et al.A novel efficient camera calibration approach based on K–SVD sparse dictionary learning[J].Measurement,2020,159:107798.

[21]KIM J S,GURDJOS P,KWEON I S.Geometric and algebraic constraints of projected concentric circles and their applications to camera calibration[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2005,27(4):637–642.

[22]HE D,LIU X L,PENG X,et al.Eccentricity error identification and compensation for high-accuracy 3D optical measurement[J].Measurement Science &Technology,2013,24(7):075402.

[23]ZHANG Z Y.Flexible camera calibration by viewing a plane from unknown orientations[C]//Proceedings of the Seventh IEEE International Conference on Computer Vision.Kerkyra,1999:666–673.

[24]RICHARDSON A,STROM J,OLSON E.AprilCal:Assisted and repeatable camera calibration[C]//2013 IEEE/RSJ International Conference on Intelligent Robots and Systems.Tokyo,2013:1814–1821.

[25]石岩青,常彩霞,刘小红,等.面阵相机内外参数标定方法及进展[J].激光与光电子学进展,2021,58(24):9–29.SHI Yanqing,CHANG Caixia,LIU Xiaohong,et al.Calibration methods and progress for internal and external parameters of area-array camera[J].Laser &Optoelectronics Progress,2021,58(24):9–29.

[26]MARTINS H A,BIRK J R,KELLEY R B.Camera models based on data from two calibration planes[J].Computer Graphics and Image Processing,1981,17(2):173–180.

[27]ZHANG S,HUANG P S.Novel method for structured light system calibration[J].Optical Engineering,2006,45(8):083601.

[28]FALCAO G,HURTOS N,MASSICH J.Plane-based calibration of a projector-camera system[J].VIBOT Master,2008,9(1):1–12.

[29]ANWAR H.Calibrating projector flexibly for a real-time active 3D scanning system[J].Optik,2018,158:1088–1094.

[30]冀红彬,张慧博,范京京,等.单周期条纹双四步相移投影仪的标定方法[J].光子学报,2017,46(1):108–115.JI Hongbin,ZHANG Huibo,FAN Jingjing,et al.Projector calibration method with single period fringe and double four-step phase shifting[J].Acta Photonica Sinica,2017,46(1):108–115.

[31]ZHANG W,LI W S,YU L D,et al.Sub-pixel projector calibration method for fringe projection profilometry[J].Optics Express,2017,25(16):19158–19169.

[32]孙丽君,张丹丹,陈天飞,等.一种基于局部单应性的投影仪精确标定方法[J].激光与光电子学进展,2022,59(13):269–278.SUN Lijun,ZHANG Dandan,CHEN Tianfei,et al.Accurate local homographybased projector calibration method[J].Laser &Optoelectronics Progress,2022,59(13):269–278.

[33]周舵,王鹏,孙长库,等.投影仪和双相机组成的三目立体视觉系统标定方法[J].光学学报,2021,41(11):120–130.ZHOU Duo,WANG Peng,SUN Changku,et al.Calibration method for trinocular stereovision system comprising projector and dual cameras[J].Acta Optica Sinica,2021,41(11):120–130.

[34]YANG S R,LIU M,SONG J H,et al.Projector calibration method based on stereo vision system[J].Optical Review,2017,24(6):727–733.

[35]杨建柏.基于数字光栅投影的三维测量关键技术研究[D].长春:中国科学院大学(中国科学院长春光学精密机械与物理研究所),2020.YANG Jianbai.Research on key technologies of 3D measurement based on digital fringe projection[D].Changchun:University of Chinese Academy of Sciences (Changchun Institute of Optics,Fine Mechanics and Physics,Chinese Academy of Sciences),2020.

[36]杨建柏,赵建,孙强.基于交比不变性的投影仪标定[J].中国光学,2021,14(2):320–328.YANG Jianbai,ZHAO Jian,SUN Qiang.Projector calibration based on cross ratio invariance[J].Chinese Optics,2021,14(2):320–328.

[37]徐维鹏,翁冬冬,刘越,等.基于深度相机的空间增强现实动态投影标定[J].系统仿真学报,2013,25(9):2097–2103.XU Weipeng,WENG Dongdong,LIU Yue,et al.Depth camera based dynamic projector calibration for spatial augmented reality[J].Journal of System Simulation,2013,25(9):2097–2103.

[38]FENG S J,ZUO C,ZHANG L,et al.Calibration of fringe projection profilometry:A comparative review[J].Optics and Lasers in Engineering,2021,143:106622.

[39]YANG L M,NORMAND J M,MOREAU G.Practical and precise projectorcamera calibration[C]//2016 IEEE International Symposium on Mixed and Augmented Reality(ISMAR).Merida,2016:63–70.

[40]SHAHPASKI M,SAPAICO L R,CHEVASSUS G,et al.Simultaneous geometric and radiometric calibration of a projector-camera pair[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Honolulu,2017:3596–3604.

[41]AUDET S,OKUTOMI M.A userfriendly method to geometrically calibrate projector-camera systems[C]//2009 IEEE Computer Society Conference on Computer Vision and Pattern Recognition Workshops.Miami,2009:47–54.

[42]CHEN C Y,CHIEN H J.An incremental target-adapted strategy for active geometric calibration of projector-camera systems[J].Sensors,2013,13(2):2664–2681.

[43]LI F,SEKKATI H,DEGLINT J,et al.Simultaneous projector-camera self-calibration for three-dimensional reconstruction and projection mapping[J].IEEE Transactions on Computational Imaging,2017,3(1):74–83.

[44]YAMAZAKI S,MOCHIMARU M,KANADE T.Simultaneous self-calibration of a projector and a camera using structured light[C]//CVPR 2011 WORKSHOPS.Colorado Springs,2011:60–67.

[45]RESCH C,KEITLER P,MENK C,et al.Semi-automatic calibration of a projectorcamera system using arbitrary objects with known geometry[C]//2015 IEEE Virtual Reality (VR).Arles,2015:271–272.

[46]张展.基于双目视觉的三维重建关键技术研究[D].沈阳:中国科学院大学(中国科学院沈阳计算技术研究所),2019.ZHANG Zhan.Binocular vision based 3D reconstruction key technologhies research[D].Shenyang:University of Chinese Academy of Sciences (Institute of Computing Technology,Chinese Academy of Sciences),2019.

[47]SCHARSTEIN D,SZELISKI R,ZABIH R.A taxonomy and evaluation of dense two-frame stereo correspondence algorithms[C]//Proceedings IEEE Workshop on Stereo and Multi-Baseline Vision (SMBV 2001).Kauai,2001:131–140.

[48]YOON K J,KWEON I S.Adaptive support-weight approach for correspondence search[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2006,28(4):650–656.

[49]KOLMOGOROV V,ZABIH R.Computing visual correspondence with occlusions using graph cuts[C]//Proceedings Eighth IEEE International Conference on Computer Vision.ICCV.Vancouver,2002:508–515.

[50]卢岸潇.基于双目立体视觉的工件定位技术研究[D].杭州:浙江大学,2019.LU Anxiao.Research on the technology of workpiece positioning based on binocular vision[D].Hangzhou:Zhejiang University,2019.

[51]HIRSCHMÜLLER H.Semi-global matching—Motivation,developments and applications[J].Photogrammetric Week,2011:173–184.

[52]PARK H,LEE K M.Look wider to match image patches with convolutional neural networks[J].IEEE Signal Processing Letters,2017,24(12):1788–1792.

[53]KENDALL A,MARTIROSYAN H,DASGUPTA S,et al.End-to-end learning of geometry and context for deep stereo regression[C]//2017 IEEE International Conference on Computer Vision (ICCV).Venice,2017:66–75.

[54]SONG X,ZHAO X,HU H W,et al.EdgeStereo:A context integrated residual pyramid network for stereo matching[M]//Asian Conference on Computer Vision.Cham:Springer International Publishing,2018:20–35.

[55]刘凯.基于多视几何约束的大尺寸快速结构光三维测量系统[D].南京:南京理工大学,2021.LIU Kai.Large-scale fast structured light three-dimensional measurement system based on multi-view geometric constraints[D].Nanjing:Nanjing University of Science and Technology,2021.

[56]国荣辉.飞机蒙皮铆接型面质量三维数字化检测技术研究[D].南京:南京航空航天大学,2021.GUO Ronghui.Research on 3D digital inspection technology for riveting shape quality of aircraft skin[D].Nanjing:Nanjing University of Aeronautics and Astronautics,2021.

[57]ZUO C,ZHANG Y Z,CHEN Q,et al.A two-frame approach for scene-based nonuniformity correction in array sensors[J].Infrared Physics &Technology,2013,60:190–196.

[58]ZUO C,CHEN Q,GU G,et al.Optimized three-step phase-shifting profilometry using the third harmonic injection[J].Optica Applicata,2013,43(2):393–408.

[59]TAO T Y,CHEN Q,DA J,et al.Realtime 3-D shape measurement with composite phase-shifting fringes and multi-view system[J].Optics Express,2016,24(18):20253–20269.

[60]FENG S J,ZUO C,TAO T Y,et al.Robust dynamic 3-D measurements with motioncompensated phase-shifting profilometry[J].Optics and Lasers in Engineering,2018,103:127–138.

[61]ZUO C,TAO T Y,FENG S J,et al.Micro fourier transform profilometry (μFTP):3D shape measurement at 10,000 frames per second[J].Optics and Lasers in Engineering,2018,102:70–91.

[62]FENG S J,CHEN Q,GU G H,et al.Fringe pattern analysis using deep learning[J].Advanced Photonics,2019,1(2):025001.

[63]FENG S J,ZUO C,YIN W,et al.Micro deep learning profilometry for high-speed 3D surface imaging[J].Optics and Lasers in Engineering,2019,121:416–427.

[64]WU Z J,GUO W B,ZHANG Q C,et al.Time-overlapping structured-light projection:High performance on 3D shape measurement for complex dynamic scenes[J].Optics Express,2022,30(13):22467–22486.

[65]WU Z J,ZUO C,GUO W B,et al.High-speed three-dimensional shape measurement based on cyclic complementary gray-code light[J].Optics Express,2019,27(2):1283–1297.

[66]徐涛.人类视觉系统的时间响应特性研究[D].呼和浩特:内蒙古工业大学,2010.XU Tao.Investigation on temporal property of human visual system[D].Hohhot:Inner Mongolia University of Tehchnology,2010.

[67]NG A,LEPINSKI J,WIGDOR D,et al.Designing for low-latency direct-touch input[C]//Proceedings of the 25th Annual ACM Symposium on User Interface Software and Technology.Cambridge,2012:453–464.

[68]ASAYAMA H,IWAI D,SATO K.Diminishable visual markers on fabricated projection object for dynamic spatial augmented reality[C]//SA’15:SIGGRAPH Asia 2015 Emerging Technologies.Kobe,2015.

[69]ASAYAMA H,IWAI D,SATO K.Fabricating diminishable visual markers for geometric registration in projection mapping[J].IEEE Transactions on Visualization and Computer Graphics,2017,24(2):1091–1102.

[70]KITAJIMA Y,IWAI D,SATO K.Simultaneous projection and positioning of laser projector pixels[J].IEEE Transactions on Visualization and Computer Graphics,2017,23(11):2419–2429.

[71]RESCH C,KEITLER P,KLINKER G.Sticky projections—A new approach to interactive shader lamp tracking[C]//2014 IEEE International Symposium on Mixed and Augmented Reality(ISMAR).Munich,2014:151–156.

[72]SIEGL C,COLAIANNI M,THIES L,et al.Real-time pixel luminance optimization for dynamic multi-projection mapping[J].ACM Transactions on Graphics,2015,34(6):1–11.

[73]HASHIMOTO N,KOIZUMI R,KOBAYASHI D.Dynamic projection mapping with a single IR camera[J].International Journal of Computer Games Technology,2017:4936285.

[74]PUNPONGSANON P,IWAI D,SATO K.Projection-based visualization of tangential deformation of nonrigid surface by deformation estimation using infrared texture[J].Virtual Reality,2015,19(1):45–56.

[75]PUNPONGSANON P,IWAI D,SATO K.DeforMe:Projection-based visualization of deformable surfaces using invisible textures[C]//SA’13:SIGGRAPH Asia 2013 Emerging Technologies.Hong Kong,2013:1–3.

[76]NARITA G,WATANABE Y,ISHIKAWA M.Dynamic projection mapping onto a deformable object with occlusion based on highspeed tracking of dot marker array[C]//Proceedings of the 21st ACM Symposium on Virtual Reality Software and Technology.Beijing,2015:149–152.

[77]NARITA G,WATANABE Y,ISHIKAWA M.Dynamic projection mapping onto deforming non-rigid surface using deformable dot cluster marker[J].IEEE Transactions on Visualization and Computer Graphics,2016,23(3):1235–1248.

[78]FUJIMOTO Y,SMITH R T,TAKETOMI T,et al.Geometrically-correct projection-based texture mapping onto a deformable object[J].IEEE Transactions on Visualization and Computer Graphics,2014,20(4):540–549.

[79]GOLDSTEIN E B,CACCIAMANI L.Sensation and perception[M].Boston:Cengage Learning,2021.

[80]I B R A H I M M T ,MEENAKSHISUNDARAM G,MAJUMDER A.Dynamic projection mapping of deformable stretchable materials[C]//Proceedings of the 26th ACM Symposium on Virtual Reality Software and Technology.Virtual Event,2020:1–5.

[81]IBRAHIM M T,MAJUMDER A,GOPI M.Dynamic projection mapping on deformable stretchable materials using boundary tracking[J].Computers &Graphics,2022,103:61–74.

[82]SERVÁN J,MAS F,MENÉNDEZ J L,et al.Using augmented reality in AIRBUS A400M shop floor assembly work instructions[J].AIP Conference Proceedings,2012,1431(1):633–640.

[83]武殿梁,周烁,许汉中.增强现实智能装配辅助技术研究[J].航空制造技术,2021,64(13):26–32.WU Dianliang,ZHOU Shuo,XU Hanzhong.Assembly operation process assistance based on augmented reality and artificial intelligence[J].Aeronautical Manufacturing Technology,2021,64(13):26–32.

[84]魏禛,郭宇,汤鹏洲,等.增强现实在复杂产品装配领域的关键技术研究与应用综述[J].计算机集成制造系统,2022,28(3):649–662.WEI Zhen,GUO Yu,TANG Pengzhou,et al.Research and application of augmented reality in complex product assembly[J].Computer Integrated Manufacturing Systems,2022,28(3):649–662.

[85]KINARD D A.The F–35 lightning II:From concept to cockpit[M].Reston:American Institute of Aeronautics and Astronautics,Inc.,2019.

[86]范玉青.基于模型定义技术及其实施[J].航空制造技术,2012,55(6):42–47.FAN Yuqing.Model based definition technology and its practices[J].Aeronautical Manufacturing Technology,2012,55(6):42–47.

[87]秦玉波,穆欣伟,邹方.基于空间增强现实的辅助装配系统研究[J].航空制造技术,2022,65(12):56–62.QIN Yubo,MU Xinwei,ZOU Fang.Research on auxiliary assembly system based on spatial augmented reality[J].Aeronautical Manufacturing Technology,2022,65(12):56–62.

[88]国防科学技术工业委员会.HB/Z 223—2003 飞机装配工艺[S].北京:国防科学技术工业委员会,2003.National Defense Science,Technology and Industry Commission.HB/Z 223—2003 Aircraft assembling technology[S].Beijing:National Defense Science,Technology and Industry Commission,2003.

[89]吴天航,何卫平,张利,等.基于CPS 的特殊阵列式元件配装[J].航空制造技术,2016,59(13):73–80.WU Tianhang,HE Weiping,ZHANG Li,et al.Special array part assembly based on CPS[J].Aeronautical Manufacturing Technology,2016,59(13):73–80.

[90]WANG Z,BAI X L,ZHANG S S,et al.M–AR:A visual representation of manual operation precision in AR assembly[J].International Journal of Human-Computer Interaction,2021,37(19):1799–1814.

[91]WANG Z,WANG Y,BAI X L,et al.SHARIDEAS:A smart collaborative assembly platform based on augmented reality supporting assembly intention recognition[J].The International Journal of Advanced Manufacturing Technology,2021,115(1):475–486.

[92]CHEN C J,TIAN Z K,LI D N,et al.Projection-based augmented reality system for assembly guidance and monitoring[J].Assembly Automation,2021,41(1):10–23.

[93]刘邈.高精度光学三维标示关键技术及应用研究[D].天津:天津大学,2016.LIU Miao.Research on key technique and application of the precise 3D optical projecting indication system[D].Tianjin:Tianjin University,2016.

[94]赵祖阳,崔海华,杜坤鹏,等.基于单应性矩阵的三维激光投影标定方法[J].光子学报,2022,51(11):312–321.ZHAO Zuyang,CUI Haihua,DU Kunpeng,et al.Calibration method of 3D laser projection based on homography matrix[J].Acta Photonica Sinica,2022,51(11):312–321.

[95]陈利平,曹正华,郭健.大型复合材料构件数字化制造技术[J].航空制造技术,2009,52(1/2):28–29.CHEN Liping,CAO Zhenghua,GUO Jian.Digital manufacturing technology for large scale composites component[J].Aeronautical Manufacturing Technology,2009,52(1/2):28–29.

[96]YANG H X,SHAO L,ZHENG F,et al.Recent advances and trends in visual tracking:A review[J].Neurocomputing,2011,74(18):3823–3831.

[97]SAFI M,CHUNG J,PRADHAN P.Review of augmented reality in aerospace industry[J].Aircraft Engineering and Aerospace Technology,2019,91(9):1187–1194.